新智元報道

來源:微軟研究院AI頭條

【新智元導讀】近日,國際計算語言學協會 ACL 舉辦的 WMT 2021 國際機器翻譯比賽的評測結果揭曉。由微軟亞洲研究院、微軟翻譯産品團隊及微軟圖靈團隊聯合釋出的 Microsoft ZCode-DeltaLM 模型獲得了 WMT 2021 「大規模多語言翻譯」賽道的冠軍。該模型基于微軟亞洲研究院機器翻譯研究團隊打造的能支援上百種語言的多語言預訓練模型 DeltaLM,在微軟 ZCode 的多任務學習架構下進行訓練生成。研究員們希望能夠借助該多語言翻譯模型,有效支援更多低資源和零資源的語言翻譯,終有一日實作重建巴别塔的願景。

近期,在剛剛結束的國際機器翻譯大賽(WMT 2021)上,微軟亞洲研究院、微軟翻譯産品團隊及微軟圖靈團隊強強聯手,在「大規模多語言機器翻譯」評測任務賽道上大展風采,憑借 Microsoft ZCode-DeltaLM 模型以巨大的優勢在該賽道的全部三項子任務上均取得排名第一的成績。相比于參數量相當的 M2M 模型,Microsoft ZCode-DeltaLM 模型在大任務上更是獲得了10個 BLEU 分數以上的提高。

WMT 國際機器翻譯大賽是全球學術界公認的國際頂級機器翻譯比賽。自2006年至今,WMT 機器翻譯比賽已成功舉辦16屆,每次比賽都是全球各大高校、科技公司與學術機構展示自身機器翻譯實力的平台,更見證了機器翻譯技術的不斷進步。其「大規模多語言機器翻譯」評測任務賽道提供了上百種語言翻譯的開發集和部分語言資料,旨在推動多語言機器翻譯的研究。該評測任務由三個子任務組成:一個大任務,即用一個模型來支援102種語言之間的10,302個方向上的有向翻譯任務,以及兩個小任務:一個專注于包括英語和5種歐洲語種之間的翻譯,另一個專注于包括英語和5種東南亞語種之間的翻譯。

WMT 2021 大規模多語言翻譯任務中 Full-Task 和 Small-Task1 的官方結果(BLEU分數)

重建巴别塔計劃

據統計,目前世界上存在有7000多種不同的語言,有很多語言正瀕臨消失或已經消失了。每種語言都承載着不同的文明。笛卡爾曾經說過:「語言的分歧是人生最大的不幸之一」。長久以來,重建巴别塔,能夠在經濟活動、文化交流中消除語言造成的隔閡,實作語言互通,是人類共同的夢想。1888年,語言學家波蘭籍猶太人柴門霍夫在拉丁語的基礎上創立了一種新的語言,稱為世界語(Esperanto)。他希望全世界人類都學習使用同一種語言。這是一個理想的解決方案,但世界語最後并沒有流行起來。

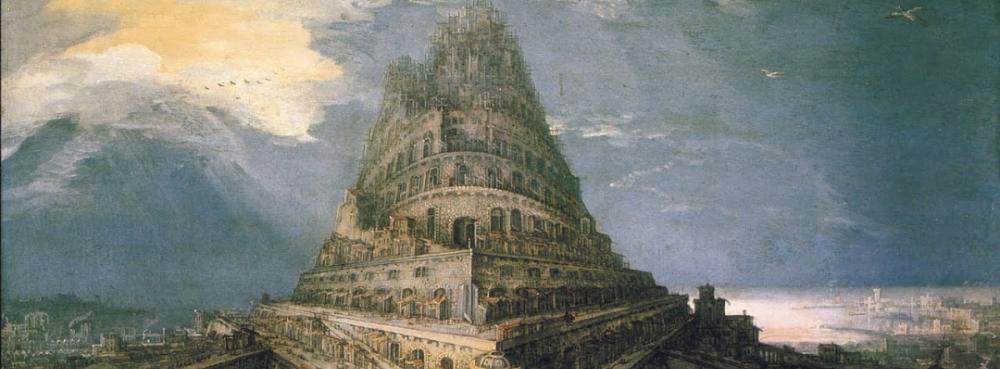

彼得·勃魯蓋爾(Bruegel Pieter)于1563年創作的油畫《巴别塔》。聖經上記載,人類最早生活在一起,使用同一種語言,後來人類越來越強大,他們想修建一座通往天堂的高塔,稱為巴别塔。上帝聽聞後震怒,為了阻止人類建造巴别塔,上帝打亂了人類的語言,讓人類說不同的語言,互相之間不能溝通,巴别塔計劃是以失敗,人類從此散落世界各地。

後來,計算機科學家們希望通過算法模型來實作機器翻譯。初期,科研人員們嘗試設計規則完成任意兩種語言之間的翻譯,手段包括編撰雙語詞典、總結翻譯轉換規則、建構翻譯知識庫手段等。但是基于規則的方法存在很大缺陷,比如規則描述顆粒度大、覆寫率低、規則庫維護代價極大等現象,進而導緻翻譯品質低、魯棒性差,且容易出現新舊規則的沖突與相容性問題。之後,研究人員開始嘗試基于資料驅動的方法來解決語言翻譯問題,從基于執行個體的方法,到基于統計的方法,再到目前流行的基于神經網絡的方法。

基于資料驅動的翻譯方法依賴于雙語平行語料的數量和品質。受益于資訊技術的發展,高資源語言的資料相對來說容易獲得,機器翻譯系統針對高資源語言的翻譯品質越來越高,如今也得以大量部署和商用,幫助解決了部分語言之間的交流障礙,促進了各種跨語言的商業應用發展,使人們看到了重建巴别塔的希望。

但盡管如此,目前機器翻譯仍面臨着許多困難。首先,仍然有大量的低資源語言存在,它們的雙語語料很難擷取,是以針對低資源語言的獨立機器翻譯系統翻譯品質非常低。其次,為所有語言單獨建立機器翻譯系統,開發、維護成本都非常大。

巴别塔的曙光:多語言機器翻譯模型

那麼,有沒有更好的技術方法能夠一次性實作所有語言之間的翻譯且兼顧翻譯性能呢?為此,研究人員開始探索多語言機器翻譯模型,即僅使用一個模型,來實作所有語言之間的翻譯。這種模型方法的動機和優點在于:

(1).基于資料驅動的方法,将所有語言編碼映射到一個語義空間中,然後再從該空間通過解碼算法生成目智語言。相對于顯式構造的世界語來說,這個語義空間是隐式存在的,理論上它能夠将所有人類語言的語義資訊進行編碼。就好比人類大腦能了解多種模态(視覺、觸覺、聽覺、嗅覺、味覺等)的輸入資訊,并對各模态發出相應的指令資訊。

(2). 語言之間是有關聯的,很多語言之間是同源的,而且很多語言文字之間有着相同的詞根。人類語言在日常使用中也經常出現多語種混雜使用的現象。盡管不同語言的資源不均衡,但是将所有語言混合後用于模型訓練,不僅能夠共享不同語言之間的知識,也可以利用高資源語言的知識幫助提升低資源語言的翻譯品質。

(3). 該方法充分發揮了計算機的硬體算力。基于先進的深度學習算法,僅使用一個模型就可以支援幾十種、上百種、直至所有語言之間的互譯問題。從這個意義上來說,機器已經超越了人類專家的翻譯能力,因為即使在吉尼斯世界紀錄中,一個人最多可以掌握的語言種類也隻有32種,而一個機器模型則可以做到更多。

多語言機器翻譯模型是目前非常重要的一個熱點研究問題,有望幫助人們實作重建巴别塔的願望。近年來,微軟亞洲研究院機器翻譯研究團隊開展了多語言機器翻譯模型多方位的相關研究,包括模型結構探索、模型預訓練方法、參數初始化、微調方法,以及建構大規模模型的方法等等。該團隊在機器翻譯領域積累了很多研究經驗,在以中文為中心的語言翻譯任務上取得了豐厚的成果,包括實作東亞語言(如中日韓語言)之間的翻譯,中國少數民族語言的翻譯,中國方言(如粵語),以及文言文的翻譯。相關機器翻譯的技術成果也賦能了微軟多種跨語言的産品應用,如語音翻譯、跨語言檢索與跨語言問答等。

基于DeltaLM+Zcode,獨占鳌頭

在 WMT 2021 比賽中脫穎而出的多語言機器翻譯模型Microsoft ZCode-DeltaLM 是在微軟 ZCode 的多任務學習架構下進行訓練的。而實作該模型的核心技術則是基于微軟亞洲研究院機器翻譯研究團隊此前打造的能支援上百種語言的多語言預訓練模型 DeltaLM。DeltaLM 是微軟開發的一系列大規模多語言預訓練語言模型中的最新一款。作為一個基于編碼器-解碼器網絡結構的通用預訓練生成模型,DeltaLM 可用于許多下遊任務(如機器翻譯、文檔摘要生成、問題生成等),并且都展示出了很好的效果。

預訓練一個語言模型通常需要很長的訓練時間,為了提高 DeltaLM 的訓練效率和效果,微軟亞洲研究院的研究員們并沒有從頭開始訓練模型參數,而是從先前預訓練的目前最先進的編碼器模型(InfoXLM)來進行參數初始化。雖然初始化編碼器很簡單,但直接初始化解碼器卻有一定難度,因為與編碼器相比解碼器增加了額外的交叉注意力子產品。是以,DeltaLM 基于傳統的 Transformer 結構進行了部分改動,采用了一種新穎的交錯架構來解決這個問題(如下圖所示)。研究員們在解碼器中的自注意力層和交叉注意力層之間增加了全連接配接層。具體而言,奇數層的編碼器用于初始化解碼器的自注意力,偶數層的編碼器用于初始化解碼器的交叉注意力。通過這種交錯的初始化,解碼器與編碼器的結構比對,可以與編碼器用相同的方式進行參數初始化。

DeltaLM 模型結構及參數初始化方法示意圖

DeltaLM 模型的預訓練充分使用了多語言的單語語料和平行語料,它的訓練任務是重構單語句子和拼接後的雙語句對中随機指定的語塊,如下圖所示。

DeltaLM 模型預訓練任務示例

在參數微調方面,研究員們将多語言翻譯任務視為 DeltaLM 預訓練模型的下遊任務,使用雙語平行資料對其進行了參數微調。不同于其它自然語言處理任務的微調,多語言機器翻譯的訓練資料規模較大,是以參數微調的成本也非常大。為了提高微調的效率,研究員們采用了漸進式訓練方法來對模型進行從淺層到深層的學習。

微調的過程可以分為兩個階段:在第一階段,研究員們直接在 DeltaLM 模型的24層編碼器和12層解碼器架構上使用所有可用的多語言語料庫進行參數微調。在第二階段,研究員們将編碼器的深度從24層增加到36層,其中編碼器的底部24層複用微調後的參數,頂部12層參數随機初始化,然後在此基礎上繼續使用雙語資料進行訓練。由于使用了更深的編碼器,擴大了模型的容量,考慮到編碼器的可并行性,是以新增的編碼器層數不會增加太多額外的任務計算時間成本。

此外,微軟亞洲研究院的研究員們采用了多種資料增強技術,以解決多語言機器翻譯多個方向的資料稀疏問題,進一步提高了多語言模型的翻譯性能。研究員們使用了單語語料庫和雙語語料庫在以下三個方面進行了資料增強:

1)為了得到英文到任意語言的反向翻譯資料,研究員們使用初始的翻譯模型回譯英文單語資料以及其它語言的單語資料;

2)為了得到非英文方向的雙僞資料,研究員們通過将相同的英文文本分别回譯為兩種語言進行配對。當這個方向效果足夠好的時候,研究員們也将該方向的單語預料進行直接回譯來擷取僞平行資料;

3)研究員們還使用了中樞語言來進行資料增強。具體而言就是将中樞語言到英文的雙語資料進行回譯,進而得到目智語言到英文以及中樞語言的三語資料。

面對複雜的資料類型構成(包括平行資料、經過資料增強的反向翻譯合成資料和雙僞平行資料)以及語種資料規模的非均衡性,研究員們基于動态調整政策,不僅調整資料類型的優先級,同時應用溫度采樣來平衡不同語言對資料的訓練使用次數。比如,在模型微調前期更多側重于高資源語言翻譯的學習,而後期則更加平均地從不同語言資料中學習翻譯知識。針對每個語言對的翻譯任務,研究員們還根據其開發集上的性能表現決定選擇是采用直接翻譯政策,還是通過利用英語作為軸語言進行橋接翻譯。

基于以上方法,研究員們建構的大規模多語言系統 Microsoft ZCode-DeltaLM 模型,在 WMT 2021 隐藏測試集的官方評測結果超出預期。如下圖所示,該模型領先位于第二的競争對手大約平均4個 BLEU 分數,比基準 M2M-175 模型領先大約10至21的 BLEU 分數。與較大的 M2M-615 模型比較,模型翻譯品質也分别領先了10到18 BLEU 分數。

WMT 2021 大規模多語言翻譯模型評測結果榜單總結

通用模型,超越翻譯

盡管微軟的科研人員們對于此次在 WMT 2021 比賽中所取得的成績倍感興奮,但更令人激動的是 Microsoft ZCode-DeltaLM 模型不僅僅是一個翻譯模型,而是一個通用的預訓練編碼器-解碼器語言模型,可适用于所有類型的自然語言生成任務。Microsoft ZCode-DeltaLM 在 GEM Benchmark 中的許多生成任務上也取得了最佳性能,包括摘要生成(Wikilingua),文本簡化(WikiAuto)和結構化資料到文本(WebNLG)等任務。如下圖所示,微軟 ZCode-DeltaLM 模型的性能表現遠優于其他更大參數規模的模型,如37億參數量的 mT5 XL 模型。

Microsoft ZCode-DeltaLM 模型在 GEM Benchmark 中摘要生成和文本簡化任務上的評測結果