導讀

遷移移學習(TL)試圖利用來自一個或多個源域的資料或知識來促進目标域的學習。由于标記成本、隐私問題等原因,當目标域隻有很少或沒有标記資料時,它特别有用。

不過,TL的有效性并不總是得到保證。負遷移(NT),即源域資料/知識導緻目标域學習性能下降,是TL中一個長期存在且具有挑戰性的問題,文獻中提出了各種克服負遷移的方法。本文從源資料品質、目标資料品質、域差異和內建算法四個方面對近100種對抗NT的方法進行了分類和回顧,填補了這一空白。本文也讨論了相關領域的NT,如多任務學習、多語言模式和終身學習。

今天介紹的是華中科技大學伍冬睿教授團隊關于遷移學習中的負遷移領域進行的一個綜述。雖然這篇綜述的主要内容講述的是遷移學習與負遷移的研究進展,然而将遷移學習應用于腦機接口、腦電資料處理時也必須考慮到訓練和測試樣本往往來自不同分布的問題。關于腦機接口中的遷移學習綜述可以檢視:《華中科技大學伍冬睿教授:非侵入式腦機接口中的遷移學習綜述(2016-2020)》、《伍冬睿教授:腦機接口中遷移學習的完整流程》、《腦機接口中的流形嵌入知識遷移學習》等。

傳統機器學習的一個基本假設是訓練和測試資料來自同一個分布。然而,在 現實應用中這個假設往往不能滿足。比如,兩個圖像資料庫可能是用不同的相機在不同光照條件下采集的;腦機接口中的被試往往具有很大的個體差異。是以,從訓練集上獲得的模型在測試集上的泛化能力往往不好。

一個直覺的解決辦法是重新采集跟測試集樣本分布相同的大量帶标注樣本,然後從中訓練一個有監督機器學習模型。然而,現實應用中并不能總是獲得這樣的大量帶标注樣本,比如因為标注成本高、隐私考慮等。

更好的解決辦法是使用遷移學習,即使用源域的資料或資訊來幫助目标域的學習。這樣,目标域隻需要很少或完全不需要帶标注樣本。

然而,遷移學習并不總是有效的,除非其基本假設都得到滿足:

-

- 源域和目标域的學習任務相似或相關;

- 源域和目标域資料分布比較接近;

- 存在一個源域和目标域同時适用的模型。

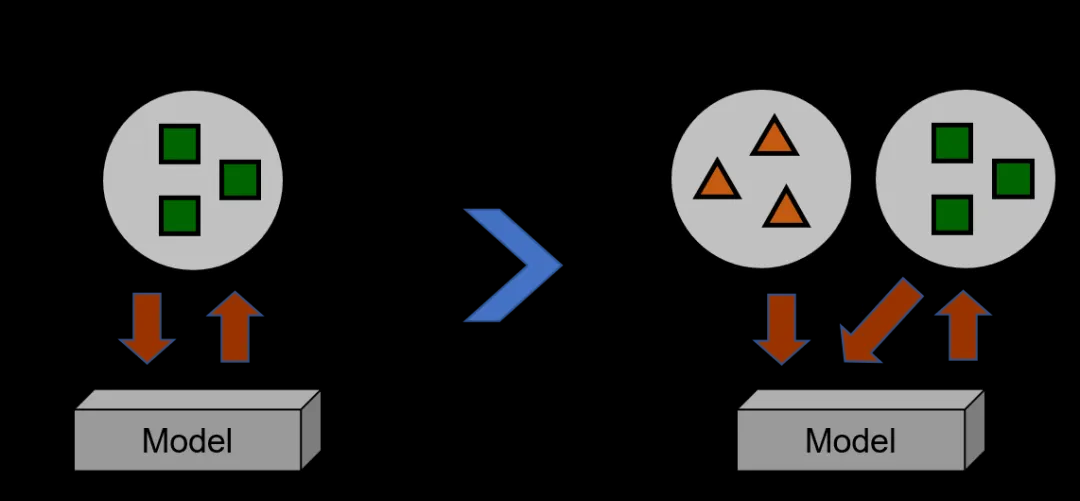

當這些假設不滿足時,負遷移就會産生,即使用源域的資料或知識反而會讓學習性能變差,不如直接用目标域的資料進行訓練,如下圖所示:

可靠的遷移學習需要同時考慮3個問題:

-

- 遷移什麼?

- 如何遷移?

- 何時遷移?

然而大多數遷移學習研究隻考慮了前2個問題。

盡管負遷移是個很常見和嚴重的問題,人們也提出了很多克服負遷移的方法,但是目前并不存在關于負遷移的詳盡的綜述。研究人員在最近的這篇綜述文章裡填補了這個空白。

研究者從4個方面系統性地歸類和總結了近100種不同的克服負遷移的方法:源域資料品質,目标域資料品質,域間差異,內建性的算法。下圖對上述提到的4個方面進行了概況:

更多具體的内容,可以檢視對應的文章。

論文資訊

Overcoming Negative Transfer: A Survey

編輯:鄒思

腦機接口BCI學習交流QQ群:515148456