第一章 模式識别基本概念

模式識别的常見運用領域

計算機視覺領域:字元識别、交通及标志識别、動作識别

人機互動領域:語音識别

醫學領域:模式識别

機器人領域:目标抓取

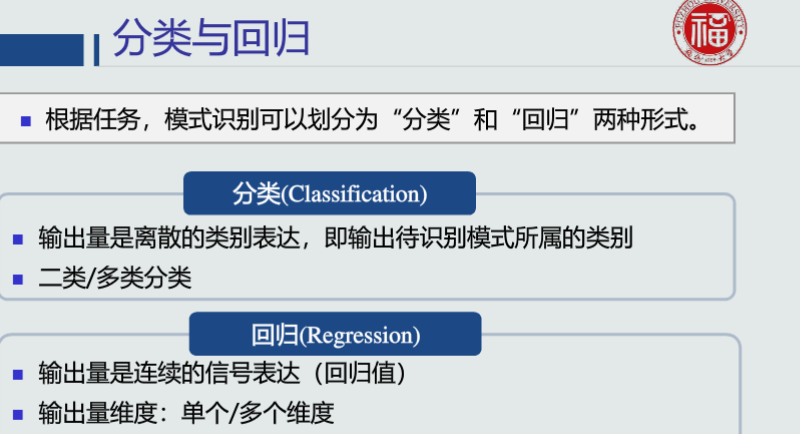

模式識别的形式

模式識别分為“分類”和“回歸”兩種形式。模式是被本質上也是一種推理過程

模型的組成:狹義:特征提取+回歸器,廣義:特征提取+回歸器+判别函數

分類器:回歸器+判别函數

特征向量的相關性

由于每個特征向量代表一個模式,是以度量特征向量兩兩之間的相關性是識别模式之間是否相似的基礎

機器學習方式

監督式學習、無監督式學習、半監督式學習、強化學習

評估方法

留出法:将資料集随機分為訓練集和測試集

留一驗證:每次隻取資料集中的一個樣本做測試集,剩餘的做訓練集

K折交叉驗證:将資料集分割成K個子集

評估名額

準确度:将陽性和陰性綜合起來度量識别正确的程度。

精度:預測為陽性樣本的準确程度。在資訊檢索領域也稱作查準率。 P=TP/(TP+FP)

召回率:也稱作敏感度,全部陽性樣本中被預測為陽性的比例。在資訊檢索領域也稱作查全率。R=TP/(TP+FN)

精度高、同時召回率也高,說明模型性能越好。

常用曲線

PR曲線:橫軸為召回率,縱軸為精度。曲線越往上凸,則性能越好。對各類别之間樣本分布比例敏感

ROC曲線:橫軸為FPR,縱軸為TPR。曲線越往左上凸,則性能越好。對各類别之間樣本分布比例不敏感

第二章 基于距離的分類器

基本概念

基于距離決策:把測試樣本到每個類的距離作為決策模型,将測試樣本判定為距離最近的類

特征白化

将原始特征映射到一個新的特征空間,使得在新空間中特征的協方差矩陣為機關矩陣,進而去除特征變化的不同及特征之間的相關性。

步驟:

1)解耦:去除特征之間的相關性

2)白化:對特征進行尺度變換,使每維特征的方差相等

總結-模式識别常見的分類器

MED分類器

基于歐氏距離:

相當于高維空間内向量說表示的點到點之間的距離。

由于特征向量的各分量的量綱不一緻,通常需要先對各分量進行标準化,使其與機關無關,比如對身高(cm)和體重(kg)兩個機關不同的名額使用歐式距離可能使結果失效。

優點:簡單,應用廣泛

缺點:沒有考慮分量之間的相關性,展現單一特征的多個分量會幹擾結果。

MICD分類器

基于馬氏距離:

适用場合:

1)度量兩個服從同一分布并且其協方差矩陣為C的随機變量X與Y的差異程度

2)度量X與某一類的均值向量的差異程度,判别樣本的歸屬。此時,Y為類均值向量.

優點:

1)獨立于分量量綱

2)排除了樣本之間的相關性影響。

缺點:不同的特征不能差别對待,可能誇大弱特征。

MAP分類器

基于後驗機率:

選擇後驗機率最大的類作為判别結果,即最小化機率誤差

貝葉斯分類器

基于MAP分類器的基礎上,引入決策風險

優點:接受大量資料訓練和查詢時所具備的高速度,支援增量式訓練;對分類器實際學習的解釋相對簡單

缺點:無法處理基于特征組合所産生的變化結果

第三章 貝葉斯決策與學習

基于距離決策問題

基于距離的決策僅考慮每個類别各自觀測到的訓練樣本的分布情況,例如均值和協方差。沒有考慮類的分布等先驗知識,例如類别之間樣本數量的比例,類别之間的互相關系。

貝葉斯規則-已知先驗機率和觀測機率

公式:P(B|A)=P(A|B)P(B)/P(A)

P(B):先驗機率

P(A|B):觀測似然機率/條件機率

P(A):邊緣機率

将測試樣本決策分類給後驗機率最大的那個類

機率誤差等于未選擇的類所對應的後驗機率。

貝葉斯決策

決策的期望損失:所有樣本的決策損失之和。

決策目标:讓最小化期望損失

如何實作期望損失最小化:對每個測試樣本選擇風險最小的類。

為了避免出現錯誤決策,分類器可以選擇拒絕

如何拒絕:引入門檻值τ

當τ=1,所有樣本的任何決策都會被拒絕

當τ<1/K,所有樣本的決策不會被拒絕,K是類别的個數

最大似然的估計偏差

如果一個參數的估計量的數學期望是該參數的真值,則該估計量稱作無偏估計。

KNN估計

K近鄰估計:給定x,找到其對應的區域R使其包含k個訓練樣本,以此計算p(x)。

針對任意一個模式x,需要以其為中心,在訓練樣本中尋找k個相鄰點來估計該模式的機率,同時,容易受噪聲影響。

第四章 線性判據與回歸

線性判據基本概念

給定訓練樣本{xn},直接在輸入空間内學習其機率密度函數p(x)

判别模型

給定訓練樣本{xn},直接在輸入空間内估計後驗機率

線性判據

如果判别模型f(x)是線性函數,則f(x)為線性判據優勢,計算量少,适用于訓練樣本較少的情況下

Fisher線性判據

找到一個最合适的投影軸,使兩類樣本在該軸上投影的重疊部分最小,進而使分類效果達到最佳。

類間樣本的差異程度:用兩類樣本分布的均值之差度量

類間樣本的離散程度:用每類樣本分布的協方差矩陣表征

支援向量機

給定一組訓練樣本,使得兩個類中與決策邊界最近的訓練樣本到決策邊界之間的間隔最大

支援向量:決策邊界記作∏,平行∏且分别通過x+和x-的兩個超平面記作∏+和∏-,稱為間隔邊界。