第一章

1.2模式識别數學表達

輸入空間&輸出空間

模型的概念

用于回歸

用于分類

判别函數

判别公式&決策邊界:用于分類

特征&特征空間

1.3特征向量的相關性

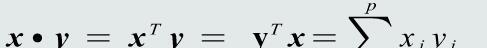

特征向量點積:代數定義

特征向量點積:幾何定義

特征向量投影

點積與投影

殘差向量

特征向量的歐氏距離

1.4機器學習基本概念

訓練樣本

模型的參數和結構

線性模型

非線性模型

樣本量與模型參數量比較

目标函數

優化算法

機器學習的方式

輸出真值

監督式學習

無監督式學習

半監督式學習

強化學習

1.5模型的泛化能力

訓練集&測試集

訓練誤差&測試誤差

模型的泛華能力

過拟合

提高泛化能力

選擇複雜度适合的模型

調節超參數

正則化

多項式拟合&超參數

1.6評估方法與性能名額

評估方法

留出法

K折交叉驗證

留一驗證

性能名額度量

F-Score

混淆矩陣

曲線度量

PR曲線

ROC曲線

AUC

第二章

2.1MED分類器

基于距離分類的基本概念

判别公式

決策邊界

2.2特征白化

特征正交白化

特征解耦任務

特征向量與特征值

特征解耦

2.3MICD分類器

馬氏距離的屬性

第三章

3.1 貝葉斯決策與MAP分類器

後驗機率:用于分類決策

貝葉斯規則

觀測機率&後驗機率

MAP分類器

3.2MAP分類器:高斯觀測機率

先驗和觀測機率的表達方式

觀測機率:單維高斯分布

高斯觀測機率:決策邊界

觀測機率:高維高斯分布

3.3 決策風險與貝葉斯分類器

決策風險概念

損失概念

損失的評估

決策風險的評估

貝葉斯分類器

決策損失

決策目标

樸素貝葉斯分類器

3.4 最大似然估計

監督式學習方法

參數估計方法

最大似然估計

先驗機率估計

觀測機率估計:高斯分布

高斯分布參數估計

均值估計

協方差估計

3.5 最大似然的估計偏差

無偏估計

高斯均值

高斯協方差

高斯協方差估計偏值

協方差估計的修正

3.6 貝葉斯估計(1)

貝葉斯估計概念

貝葉斯估計:高斯觀測似然

參數先驗機率

參數後驗機率

3.7 貝葉斯估計(2)

貝葉斯估計也最大似然估計對比

3.8 KNN估計

機率估計密度基本理論

KNN估計

KNN的優缺點

3.9 直方圖與核密度估計

直方圖估計:原理

直方圖估計:優缺點

直方圖雙線性插值

直方圖估計:帶寬選擇

核密度估計

原理

核密度估計:核函數

核密度估計:優缺點

核密度估計:帶寬選擇

直方圖與核密度估計

第四章

4.1 線性判據基本概念

生成模型

優缺點

判别模型

線性判據定義

線性判據數學表達

線性判據:決策邊界

線性判據:w的方向

任意樣本到決策邊界的距離

決策邊界到坐标原點的距離

4.2 線性判據學習概述

參數空間&解域

解域:

加入限制條件

4.3 并行感覺機算法

感覺機算法:預處理

感覺機:解域

并行感覺機:目标函數

梯度下降法

并行感覺機:參數更新

并行感覺機:算法流程

4.4 串行感覺機算法

串行感覺機

算法流程

參數更新過程

感覺機:收斂性

全局最優與局部最優

感覺機:步長與收斂性

提升感覺機泛化能力

加入margin限制