本节书摘来自华章社区《spark核心技术与高级应用》一书中的第3章,第3.2节构建spark的开发环境,作者于俊 向海 代其锋 马海平,更多章节内容可以访问云栖社区“华章社区”公众号查看

3.2 构建spark的开发环境

无论windows或linux操作系统,构建spark开发环境的思路一致,基于eclipse或idea,通过java、scala或python语言进行开发。安装之前需要提前准备好jdk、scala或python环境,然后在eclipse中下载安装scala或python插件。

3.2.1 准备环境

准备环境包括jdk、scala和python的安装。

1.安装jdk

(1)下载jdk(1.7以上版本)

(2)配置环境变量(以windows为例)

新增java_home变量,值:c:program filesjavajdk1.7.0_71。

新增classpath变量,值:.;%java_home%lib。

增加path变量,补充;%java_home%bin。

进入cmd界面测试jdk是否安装成功。

2.安装scala

安装完毕配置环境变量,增加path变量,补充c:program files (x86)scalabin;。

进入cmd界面测试scala是否安装成功。

3.安装python

安装完毕配置环境变量,增加path变量,补充c:python33;。

进入cmd界面测试python是否安装成功。

3.2.2 构建spark的eclipse开发环境

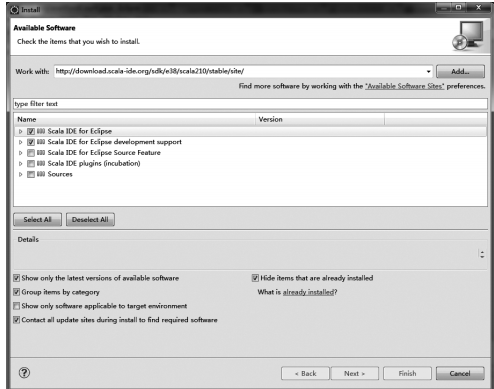

使用eclipse进行spark开发,需要安装scala和python插件,安装步骤如下:

1)安装eclipse,在官网下载eclipse,解压缩到本地后直接使用即可。

安装完毕pydev之后,配置python/jython解释器,在eclipse菜单栏中,选择“window”→

重启eclipse使安装生效。

3.2.3 构建spark的intellij idea开发环境

官方提供了ultimate版和community版可供选择,主要区别如下:

1)ultimate版功能齐全的ide,支持web和enterprise,免费试用30天,由官方提供一个专有的开发工具集和架构支持。

2)community版支持java、groovy、scala、android的开发,免费并且开源,由社区进行支持。

作者使用的版本是ideaic-14.1.4,请选择适合的操作系统进行安装。

如何安装intellij idea?

windows :直接运行.exe文件,按照向导步骤操作即可。

mac os x:打开.dmg包,并复制intellij idea到应用文件夹。

linux:解压.tar.gz压缩包,并运行bin/idea.sh(需要在环境变量path中加入idea目录,并执行source命令使配置文件生效)。

根据实际需求,我们选择windows系统的community版本进行scala程序的开发。步骤包括:安装scala插件和创建项目并在idea中编写scala代码。

1.?安装scala插件

①?运行idea并安装和配置idea的scala开发插件,启动程序界面如图3-2所示,此时需要选择“conf?igure”,然后进入idea的配置页面。

③?点击安装界面左下角的“install jetbrains plugin”选项,进入jetbrains插件选择页面,如图3-4所示。

插件安装完毕,重启idea。

2.?创建项目并在idea中编写scala代码

①?进入首页(见图3-2),选择“create new project”命令,此时选择左侧列表中的“scala”选项,为了方便以后的开发工作,选择右侧的“sbt”选项,如图3-6所示。

③?由于在前面选择了“sbt”选项,所以此时idea智能地构建sbt工具:点击工程名称“hellospark”,可以看到sbt自动创建的一些目录,如图3-8所示。

④?此时右击src目录下main中的scala,在弹出的“new”菜单下选择“scala class”,在弹出的“create new scala class”对话框中输入文件名“hellospark”,把kind选择为“object”,点击“ok”按钮完成,如图3-9所示。

3.?加入spark开发包

使用idea导入外部jar包,具体步骤:“file”→“project structure”→“modules”→“dependencies”→+...→“library...”→“library type(java)”→“select library files”→“conf?igure library”,以添加spark-assembly-1.5.0-hadoop2.3.0.jar为例,添加步骤如下:

①?点击“file”,选择“project structure”,如图3-11所示。

④?通过“select library files”,选择“spark-assembly--.jar”,如图3-14所示。

选择完毕进行spark开发包加载。

4.?jdk路径错误处理

如果sbt出现如图3-15提示,这是由于没有设置java的jdk路径。

请点击最右侧的“project structure”,如图3-16所示,进入视图,并配置项目jdk。

选择最左侧的“project”选项,并选择“no sdk”的“new”如图3-17所示,选择项目jdk为1.7。

重启idea,问题解决。

5.?sbt下载不完整问题处理

如果不能出现完整的sbt目录,选择“view”目录的下拉菜单“tool windows”目录,选择“sbt”,如图3-18所示。

如果完整目录还是不可见,可以查看具体日志,然后将需要下载的sbt包下载下来,放到相应的目录,一般是当前用户的.ivy2目录,然后删除hellospark项目,重新建项目。

最终可以见到完整的sbt路径。

6.?idea生成jar包

使用idea编译class文件,同时可以将class打包成jar文件,方法如下:

①?选择菜单“file”→“project structure”,弹出“project structure”的设置对话框;

②?选择左边的“artifacts”,点击上方的“+”按钮;

③?在弹出的对话框中选择“jar”→“from moduls with dependencies”;

④?选择要启动的类,然后确定;

⑤?应用之后选择菜单“build”→“build artifacts”,选择“build”或者“rebuild”后即可生成,生成的jar文件位于工程项目目录的out/artifacts下。