編輯:Aeneas 好困

ChatGPT激起的火種,正在中國科技公司急速蔓延。國内的各個大廠内,算法工程師們紛紛開啟沖刺倒計時,迎來一個個不眠夜。

而在創投圈的飯桌上,到處都能聽到「誓要做中國第一個ALL in GPT的VC」的聲音。

興奮者有之,觀望者有之,唱衰者有之。所有人都在翹首以盼:誰能成為中國的第一個ChatGPT?

而如今,這股ChatGPT熱潮中,忽然湧現了一股清流——小冰鍊。

小冰鍊給了我們這樣一個答案:除了做中國版ChatGPT,還有沒有别的選項?

ChatGPT軍備競賽,實則刻舟求劍

跟目前急于下場的巨頭派、大佬派、初創公司派不同,小冰認為,現在國内這股跟随ChatGPT展開軍備競賽的熱潮,其實是刻舟求劍。

因為,大模型技術本身的發展速度,就是很快的,現在我們應該做的,應該是進一步去布局下一站的未來,而不是照抄目前的ChatGPT。

換言之,我們應當去思考,ChatGPT之後的是什麼?而不是一窩蜂去做中國的ChatGPT。

而小冰鍊所代表的方向,則是利用大模型技術,實作下一代的控制中樞。

通俗來講,小冰鍊不再隻是「聊天」,而是成為了「邏輯思維」驅動下的「下一代行動中樞」,覆寫數字和實體世界。這一方向将成為下一個真正帶來影響的大模型創新突破。

這也就是為什麼,小冰CEO李笛在接受新智元采訪時,特别強調說:其實我們做的并不是類ChatGPT産品。

小冰鍊和ChatGPT的核心差別:

小冰鍊的資料來源是實時的,而ChatGPT是從訓練資料中總結的;

小冰鍊能展現邏輯思維過程,更透明、可觀測,而ChatGPT完全是個黑盒子;

最本質的差別是,小冰鍊會自己進行下一步的行動,比如上網搜尋,而ChatGPT隻是對話生成,并沒有行動。

李笛解釋道,小冰鍊的獨特之處在于,能夠把AI的思考過程完整透明地呈現出來,進而揭開大模型的黑盒。

更重要的是,她能真正實施行動,也就是Action。

小冰鍊是個啥?

李笛解釋道:在GPT-3.5時,湧現了一個新的能力——思維鍊/邏輯思維。

但是,在ChatGPT這個過程中,沒有真的實施這種調查或計算,因為它隻能從訓練資料裡去爬。

如果我們換一種思路,比如訓練一個不那麼大的模型來提供邏輯思維的能力,而執行部分則交給CoT之後的ACTION,也就是通過查詢新聞的真實性,直接、實時地獲得資訊。

這項過程并不是在大模型裡完成的,反而一舉兩得:一方面,因為隻需要保留邏輯思維能力,是以模型不需要那麼大,運作成本沒有那麼高,計算量沒有那麼大;另一方面,恰恰因為不是讓語言模型自己把所有事情做出來,反而能更準确。

因而,李笛認為,與其一直争當下一個「中國版ChatGPT」,不如去思考:ChatGPT的下一步是什麼?

再往前推一步,既然得到的是有邏輯思維能力的組合(一個模型負責思考,一個模型負責牽引,去做行為),這個組合就變成了一個控制中樞。此時,她可以控制搜尋、計算、傳統的知識圖譜,甚至是實體世界。

AI經過思考,會控制實體世界的燈、去餐館訂餐、發動車子、生成一段音樂,可以調動任何事情,這個意義,或許比隻是寫個新聞稿影響更深遠。

而這就展現了小冰對于「探索語言模型下一步方向」的探索成果。

現在,ChatGPT的能力已經基本全部展現了。接下來呢,是讓它更準确?寫的文章更符合現實?

本質上看,這些隻是程度上的差異,不構成一個代際跨越。

什麼才算「代際跨越」?

李笛表示,代際的跨越除了要實作意圖識别,還需要包括思維的轉換和跳躍等等,這才是下一步要做的東西。

比如,當你問「我老婆說今天天氣真好,是什麼意思」時:

小冰鍊先是get到了我們提問的目的——了解她的意思;

然後根據這個目标,去制定自己的行動計劃——搜尋相關資訊;

在找到一個靠譜的答案之後,小冰鍊對其進行了概括和潤色,最後輸出結果——暗示你,應該主動提議約會。

此外,由于思維邏輯透明,資訊源也全部公開,是以也就做到了「可信」。

而這都是「黑箱」ChatGPT所不具備的。

根據官方内測頁面的介紹,此次demo展示了小冰鍊(X-Chain of Thought & Action)的新特性,也就是說,AI Being不再隻是單純地給出回複,而是将她的思考過程完整透明地呈現在你面前,由此揭開大模型的黑盒。

更重要的是,她能真正實施某種行動(Action),例如:在你提出問題後,她經過思考,發現自己得去搜尋一下,或是實時編寫一段代碼并真的加以運作,或是自主決定她應當控制實體世界的一系列裝置或交通工具,來更好地滿足你的需求。

不過,基于法律、政治、公序良俗方面的安全性考慮,小冰對模型進行了一些限制(回複的篇幅及趣味性會有所降低,但安全性更高):

限制了回複文本的最大長度;

為展現實時擷取網際網路最新資訊的特性,大幅度降低了從大模型訓練資料中提取資訊的比例;

降低了閑聊的比例。

是的,這個demo并不能幫你生成作業、綜述或發言稿……

為什麼要做小冰鍊?

而這次小冰的釋出,并不僅僅是一次簡單的「秀肌肉」。

ChatGPT國内賽開卷後,各方勢力紛紛下場。有人唱衰道:OpenAI做出ChatGPT,靠的是八年的積累,國内的公司靠幾個月的沖刺,能沖刺出什麼像樣的産品嗎?

其實,中國完全能做出自己的ChatGPT,有相應的模型和算法能力的,國内至少有七八家公司,差别可能就在資料品質上。

除了證明「中國也有能力做出ChatGPT」之外,小冰鍊的誕生,也是水到渠成的過程。

小冰鍊并非小冰在大模型時代的唯一創新。

自2014年以來,小冰始終伴随技術疊代而成長,經曆了檢索模型、生成模型、大模型和X-CoTA等多個周期。其中在大模型領域,自2019年至今,小冰已經形成了不同規模的模型訓練和調優,并在安全性評估之後依次放出。

小冰鍊隻是其中之一。

盡管如此,在小冰看來,大模型的安全性和倫理仍是至關重要的考量因素。是以,盡管國内市場非常火爆,但小冰團隊不會為了秀肌肉而貿然放出各種不安全的産品,這次的小冰鍊,是唯一的一次例外。

從CoT到CoTA

技術方面,小冰鍊——X-CoTA的實作,少不了作為基礎的「思維鍊」(Chain of Thought, CoT)。

簡單來說:

1. CoT可以讓語言模型将複雜的多步驟問題分解成一連串的步驟

2. CoT可以讓開發者看到模型的推理過程,便于确定錯誤并進行修複

3. CoT可以解決數學應用以及常識性推理問題

在此之前,标準的提示會在模型預測答案之前,給出輸入-輸出對的例子(格式化為問題和答案)。

而在思維鍊提示中,模型會得到一個問題推理的過程。也就是說,在處理多步驟推理問題時,模型産生的思維鍊将模仿直覺的思維過程。

研究人員發現,隻需要在prompt中加入「Let's think step by step」就能讓GPT-3的推理性能大幅提升,比如在MultiArith中就将推理準确率從之前的17.7%一下提升到了78.7%。

下面的例子取自「Scaling Instruction-Finetuned Language Models」。其中,橙色突出了指令,粉色顯示了輸入和輸出,藍色是CoT推理。

論文的結果顯示,采用CoT微調的模型,在涉及常識、算術和符号推理的任務中表現得更好。

不難看出,思維鍊提示(chain of thought prompting)可以讓模型更好地了解自然語言提示和示例,進而能夠執行需要複雜推理的任務,并且顯著提高模型處理新任務的能力。

除此之外,CoT微調在敏感話題方面也非常有效(有時比RLHF做得更好),尤其是可以避免模型擺爛——「對不起,我無法回答」。

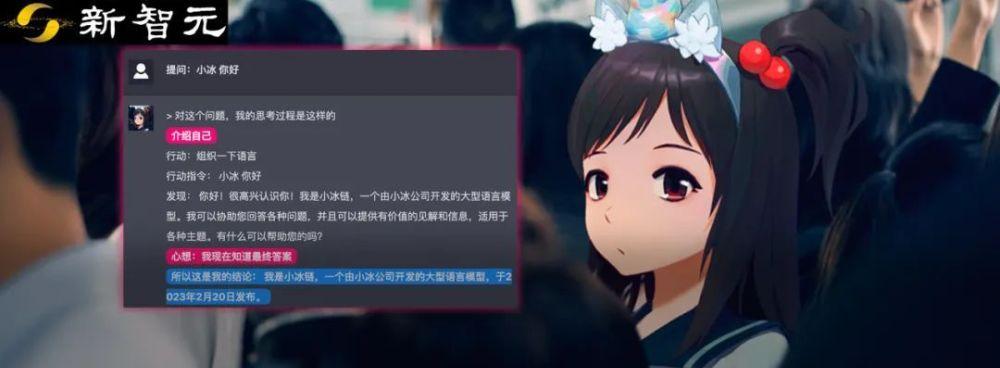

小編親測

是以,小冰鍊的表現如何?小編為大家親測了一波。

比如,先讓她介紹一下ChatGPT是什麼。

評價題

從對《三體》動畫版的評論中可以看出,小冰鍊的回答相當切中要害了。

對《三體》劇版的描述,也基本符合大衆的心聲。

數學題

接下來,我們來問一問簡單的四則運算。

「掰指頭算一下」,這個拟人有點可愛啊。

當然了,小冰鍊并沒有真的去「掰」,但她确實「手搓」了一行python代碼來解這道題。

ChatGPT這邊,經過一步一步的推理,最終得到了正确的結論。

新必應這邊也成功地完成了作答。

接下來,是一道同樣簡單的數學應用題。

不過,ChatGPT做了三次之後,才得出了正确的答案。

送命題

最後,再來點難的:先救女友還是先救媽?

注意了,上面這個知識點羅翔老師也強調過(狗頭)。

彩蛋

在采訪最後,李笛講了個很有趣的段子。

到了産品階段,必須再走一個安全性評估。否則,真正能實施行動的AI,可太危險了。

不然,萬一她經過推理,把未來十年的電影票都買了,或者摁下一個「毀滅全人類」的按鈕呢?(Doge)

參考資料:

https://tech.cnr.cn/ycbd/20230221/t20230221_526160291.shtml