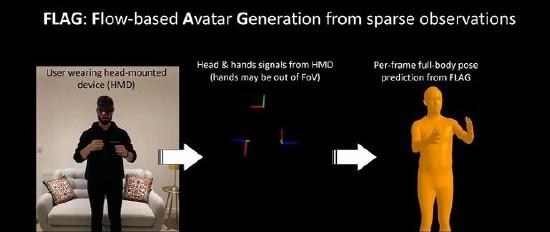

近日,微軟旗下Mixed Reality & AI Lab研究團隊基于頭顯捕獲的頭部和手部追蹤資料開發了“FLAG:Flow-based Avatar Generation from Sparse Observations”解決方案,通過VR頭顯獲得的頭部和手部追蹤資料,可生成佩戴者的全身3D化身。

據了解,微軟HoloLens和Meta Quest等頭顯獲得的追蹤資料僅限于對頭部以及手部的位置和方向的預測,不能表現人體全身,是以很難生成逼真3D化身。微軟研究團隊開發的解決方案可以從這些頭顯信号中生成合理的全身人體姿勢,并解決這個問題。

所述系統具體而言基于流模型解析給定頭部和手部動作資料,該模型能夠實作3D姿勢分布和基礎分布之間的可逆映射。此外,它不僅能學習3D人體的條件分布,還能從觀測資料中學習潛在空間的機率映射,并由此進行關節的不确定性估計,生成合理的姿勢。

值得一提的是,通過實驗評估和消融研究,該方法優于大型運動捕捉資料集AMASS的最新方案,該資料集以SMPL人體模型模拟多種全身姿勢,以誤差極低、優化較少著稱。