ICLR 2016

本文主要内容是 結合 RNN 和 attention model 用來做目标跟蹤。

其中模型的組成主要是:

1. an attention model 主要用來從輸入圖像中提取 patch;

2. RNN 用來預測 attention 參數,即:下一幀應該 look 的問題。

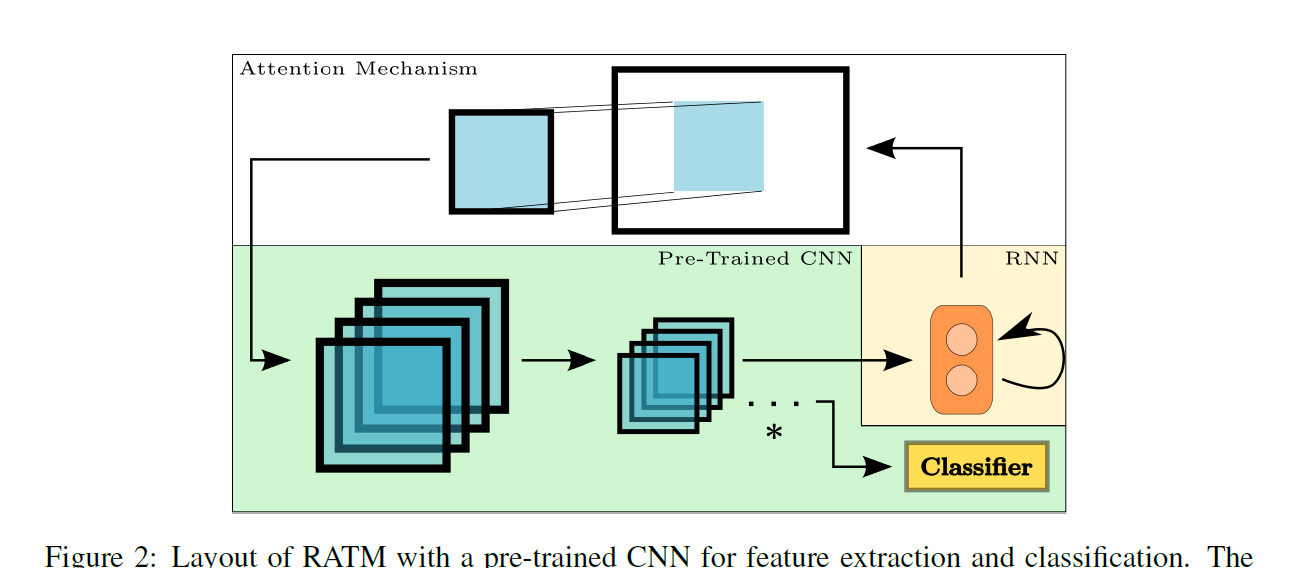

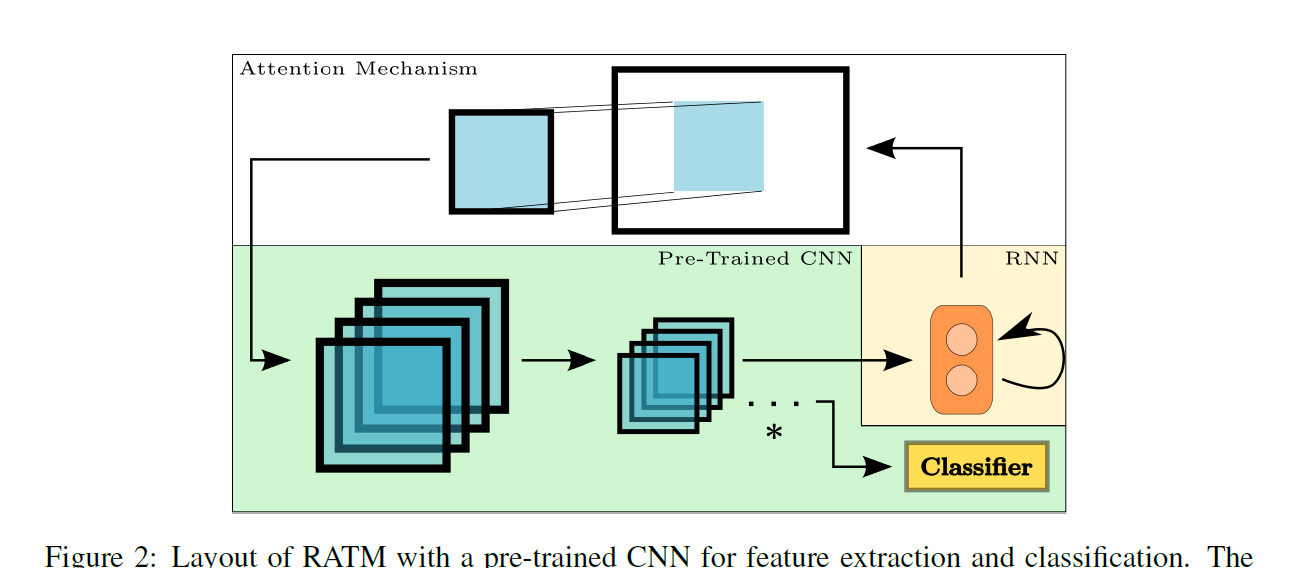

本文所使用的架構流程圖如下所示:

1. Attention

本文提到, attention model 非常适合跟蹤問題,因為他可以通過目标的曆史軌迹來縮小 region-of-interst 的區域。

原本的 attention model 從輸入圖像中産生 glimpse(一瞥),是通過一個叫做 a grid of 2D Gaussian filters,順序的執行一系列的 row filter 和 column filter。該 grid 擁有 4個參數,即:

the grid center $g_X, g_Y$,the isotropic standard deviation, and the stride between grid points.

對于在 attention patch中的行 i,列 j,平均距離 $\mu_X^i, \mu_Y^j$ 通過下式進行計算:

動态産生的參數 作為一個向量 h 的線性轉換:

然後對參數進行歸一化:

其中 A 和 B 分别是輸入圖像的寬和高。

濾波器通過下面的公式計算得到提取的 patch,即:

在上式中, a 和 b 代表輸入圖像的列和行的索引。通過這兩個公式就可以得到一個 N*N 的 patch p:

2. RNN

一個最簡單的 RNN 包括一個輸入,一個 hidden,一個 輸出層。在時間步驟 t,該網絡,基于輸入幀 $x_t$ 和 之前的 hidden state $h_{t-1}$,計算新的 hidden state:

本文對 RNN 并未做過多介紹,因為創新點也不在于此,隻是說是基于 Theano 架構做的實驗。

3. Recurrent Attentive Tracking Model:

跟蹤問題主要是将一系列的輸入視訊幀 $X = (x_1, x_2, ... , x_T)$ 映射成 一系列的位置 $Y = (y_1, y_2, ... , y_T)$。那麼在一個時刻 t 的位置預測 $y_t$,那麼其軌迹通常具有非常高的相關内容資訊,并且非常适合用 一個隐層狀态模型(a hidden state model)來對這個軌迹進行表示。所提出的 RNN 就是結合了 attention model 和 RNN 的優勢,并且差別于普通的神經網絡。

每一個時間步驟,RNN的 hidden state vector $h_t$ 通過公式2,3 映射成 window parameters。然後在下一個時刻,由 attention model 輸出的image patch 作為 RNN 的輸入。并非直接将 原始圖像輸入給 RNN,而是用預先訓練的 CNN model 提出其feature 傳給 RNN。具體結構見下圖:

實驗: