1.数据挖掘的基本任务

数据挖据的基本任务包括利用分类与预测、聚类分析、关联规则、时序模式、偏差检验、智能推荐等方法,帮助企业提取数据中蕴含的商业价值,提高企业的竞争力。

2.数据挖掘的过程

2.1 定义数据挖掘目标

(1) 分析挖掘用户数据,建立用户画像与物品画像等

(2) 基于用户画像实现动态商品智能推荐,帮助用户快速发现自己感兴趣的商品,同时确保给用户推荐的也是企业所期望的,实现用户与企业的双赢。

(3) 对平台客户进行群体细分,了解不同客户的贡献度与消费特征,分析哪些客户是最有价值的,哪些是需要重点的,对不同价值的客户采取不同的营销策略,将有限的资源投放到最有价值的客户身上,实现精准化营销。

(4) 基于商品的历史销售情况,综合节假日、气候和竞争对手等影响因素,对商品销售量进行趋势预测,方便企业准备库存。

2.2 数据抽样

2.3 数据预处理

2.4 挖掘建模

2.5 模型评价

3.常用的数据挖据建模工具

3.1 sas enterprise miner

(1) 数据获取工具

(2) 数据抽样工具

(3) 数据筛选工具

(4) 数据变量转换工具

(5) 数据挖据数据库

(6) 数据挖掘过程

(7) 多种形式的回归工具

(8) 为建立决策树的数据剖分工具

(9) 决策树浏览工具

(10) 人工神经元网络

(11) 数据挖据的评价工具

在sas/em中,可利用具有明确代表意义的图形化的模块将这些数据挖掘工具单元组成一个数据流程图,并以此来组织你的数据挖掘过程。对于有经验的数据挖掘专家,sas/em提供大量的选项,可让有经验的数据分析人员进行精细化调整分析处理。

3.2 ibm spss modeler

3.3 python

3.4 sql server

3.5 rapidminer

3.6 weka

3.7 knime

knime是一个基于eclipse平台开发,模块化的数据挖掘系统。它能够让用户可视化创建数据流(也就常说的pipeline),选择性的执行部分或所有分解步骤,然后通过数据和模型上的交互式视图研究执行后的结果。可以扩展使用weka中的算法,同时knime也提供基于数据流的方式来组织数据挖掘过程,每个节点都有数据的输入/输出端口,用接收或输出计算结果。

3.8 tipdm

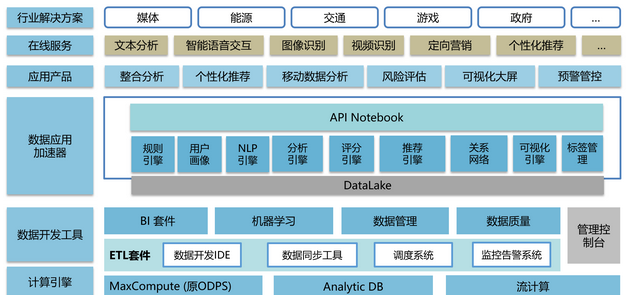

4.数加平台

数加的生态体系组成如下: