擷取一個網頁最簡單的方法就是:構造一個向伺服器請求資源的Request對象,傳回一個Response對象即r,其包含從伺服器傳回的所有的相關資源

r = requests.get(url)

requests.get()完整的使用方法有三個參數

requests.get(url,params=None,**kwargs)

url:擷取頁面的url連結

params:url中的額外參數,字典或位元組流格式,可選

**kwargs:12個控制通路的參數,可選

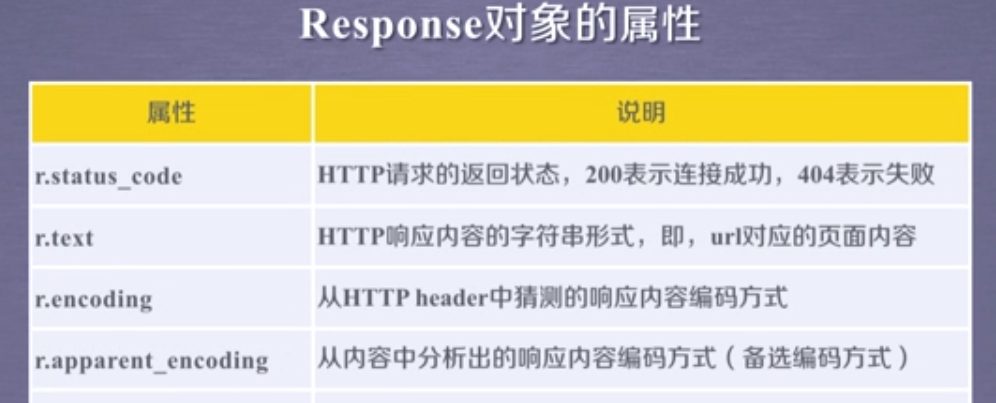

Response對象

Response對象包含了爬蟲傳回的全部内容

Response對象最常用和最必要的屬性

使用get方法擷取網絡資源的基本流程

首先用r.status_code來檢查傳回的Response對象的狀态,如果狀态是200,就可以用r.text、r.encoding、r.apparent_encoding和r.content等解析傳回的内容;如果傳回的狀态碼是404或者其他,那就說明我們這次url的通路因為某種原因出錯或産生異常了

執行個體:

#coding:utf-8

import requests

# 調用request庫

r = requests.get("http://www.baidu.com")

# 用get方法去通路百度的首頁

print(r.status_code)

# 用r.status_code來檢測這個請求的狀态碼,如果狀态碼是200,說明通路成功;如果不是200,通路失敗

print type(r)

# 用type檢測r的類型,可以看到傳回的是一個類,這個類的名是Response

print (r.headers)

# 用r.headers擷取頁面的頭部資訊