懶得手翻了,全文機器翻譯,湊合着看吧,建議對着原文看

RGB-D圖像的深度補全(Deep Depth Completion of a Single RGB-D Image)(全文機器翻譯)

Yinda Zhang

普林斯頓大學

摘要

我們的工作目标是完成RGB-D圖像的深度通道。 商品級深度相機通常無法探測到有光澤、明亮、透明和遠處的物體表面的深度。 為了解決這一問題,我們訓練了一個以RGB圖像為輸入,預測密集表面法線和遮擋邊界的深度網絡。 然後,這些預測與RGB-D相機提供的原始深度觀測相結合,以解決所有像素的深度,包括原始觀測中缺失的像素。 這種方法優于其他方法(例如直接繪制深度),這是使用新的深度完成基準資料集進行大量實驗的結果,該基準資料集通過呈現多視圖RGB-D掃描生成的表面重構來填充訓練資料。 在不同的網絡輸入、深度表示、損失函數、優化方法、inpaint方法和深度估計網絡中進行的實驗表明,我們提出的方法比這些方法提供了更好的深度完井效果。

1. 介紹

深度感覺已經廣泛應用于自動駕駛、增強現實和場景重建等領域。 盡管深度傳感技術最近取得了進步,但微軟Kinect、英特爾RealSense和谷歌Tango等日用品級RGB-D相機在表面過于光滑、明亮、薄、近或遠時,仍然會産生資料缺失的深度圖像。 這些問題出現在房間大,表面有光澤,強烈的照明充足時,例如,在博物館,醫院,教室,商店等。

我們的工作目标是完成一個RGB-D圖像的深度通道捕獲與一個商品相機(即。 ,填滿所有的洞)。 盡管在過去的20年裡,深度繪畫受到了很多關注,但通常是通過手工調整方法來解決的,即通過外推邊界表面[51]來填充洞,或者使用馬爾可夫圖像合成[16]來解決。 提出了一種利用深度網絡從顔色中估計深度的新方法

1

普林斯頓大學托馬斯·芬克豪斯

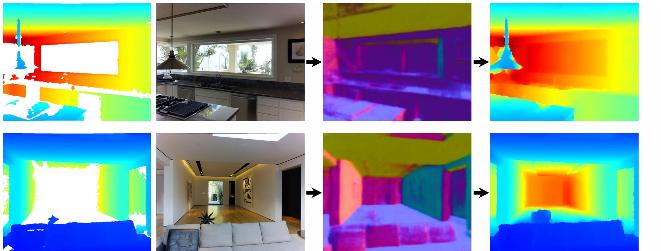

圖1所示。 深度完成。 利用顔色預測法線,對RGB-D圖像的深度通道進行大面積缺失區域的填充,然後求解完整的深度。

[19]。 然而,它們還沒有用于深度完井,這有其獨特的挑戰:

訓練資料:對于與“複合”深度圖像(例如,為孔提供地面真值深度)比對的捕獲的RGB-D圖像,大型訓練集并不容易獲得。 是以,大多數深度估計方法都是針對普通的RGB-D相機捕獲的像素進行訓練和評估的[64]。 從這些資料中,他們最多能學會再現觀測到的深度,但不能再現未觀測到的完整深度,因為這些深度具有明顯不同的特征。 為了解決這個問題,我們引入了一個新的資料集,其中包含105,432張RGB-D圖像,與72個真實環境中大規模地表重建計算得到的完整深度圖像對齊。

深度表示:解決我們的問題最明顯的方法是使用新的資料集作為監督,訓練一個完全卷積的網絡直接從RGB-D回歸深度。 然而,這種方法并不能很好地工作,特别是對于像圖1底部一行所示的大洞。 從單目彩色圖像中估計絕對深度,即使對人[53]也是困難的。 相反,我們訓練網絡隻預測深度的局部微分性質(表面法線和遮擋邊界),這更容易估計[35]。 然後我們用全局最優解出絕對深度。

深度網絡設計:以前沒有研究如何最好地設計和訓練端到端深度網絡來完成從RGB-D輸入的深度圖像。 乍一看,它似乎直接擴充了以前的net-

圖2。 系統管道。 在給定一幅輸入RGB-D圖像的情況下,利用顔色預測表面法線和遮擋邊界,然後利用輸入深度正則化的全局線性優化算法求解輸出深度。

為顔色到深度訓練的作品(例如,通過提供一個額外的深度通道作為輸入)。 然而,我們發現很難訓練網絡從深度輸入來填充大洞——它們通常隻學習複制和插值輸入深度。 對于網絡來說,學習如何适應顔色和深度的失調也是一個挑戰。 我們的解決方案是隻向網絡提供彩色圖像作為輸入(圖2)。我們訓練它在監控下預測局部表面的normals和遮擋邊界。 我們稍後将這些預測與全局優化中的輸入深度相結合,以解回已完成的深度。 通過這種方式,網絡隻能根據顔色預測局部特征,而這正是它擅長的。 通過全局優化和輸入深度正則化,重構了場景的粗尺度結構。

總的來說,我們主要的算法觀點是,最好将RGB-D深度補全分解為兩個階段:1)僅通過顔色來預測表面法線和遮擋邊界,2)通過觀測深度提供的軟限制預測來優化全局表面結構。 實驗表明,該方法的相對誤差明顯小于其他方法。 它還有一個額外的好處,即訓練後的網絡是獨立于觀測深度的,是以不需要為新的深度傳感器重新訓練。

2. 相關工作

在深度估計、繪制和處理方面,已有大量的前期工作。

深度估計。 單目彩色圖像的深度估計是計算機視覺中一個長期存在的問題。 經典的方法包括基于陰影的形狀(shape-from- shade)[78]和基于散焦的形狀(shape-from-defocus)[67]。 其他早期的方法是基于手工調整的模型和/或表面朝向的假設[31,60,61]。 較新的方法将深度估計視為一個機器學習問題,最近使用的是深度網絡[19,73]。 例如,Eigen等人首先使用

一種多尺度卷積網絡,從彩色圖像回歸到深度[19,18]。 Laina等人使用了基于ResNet[37]的全卷積網絡架構。 Liu等人提出了一種深度卷積神經場模型,将深度網絡與馬爾可夫随機場[40]相結合。 Roy等人将淺層卷積網絡與回歸森林相結合,減少了對大型訓練集[59]的需求。 所有這些方法都是經過訓練的,隻用于再現用普通的RGB-D相機獲得的原始深度。 相反,我們關注深度補全,其明确的目标是對深度傳感器沒有傳回的像素做出新的預測。 由于這些像素經常在原始深度中丢失,是以僅在原始深度上訓練的方法不能很好地預測它們。

深度修補。 許多方法已經提出了填補RGB-D管道深度圖像,包括那些使用平滑先驗[30],快速行進方法(25日42)、n - s[6],各向異性擴散[41],背景表面外推(51歲,68),顔色深度邊緣對齊(77,81),低秩矩陣完成[75],張量投票[36],[44]Mumford-Shah功能優化,與其他屬性的聯合優化的内在圖像[4], 以及基于patch的圖像合成[11,16,24]。 近年來,人們提出了利用自動編碼器和GAN架構[58]對彩色圖像進行inpainting的方法[70]。 然而,以往的工作還沒有研究如何使用這些方法inpainting的深度圖像。

深度超分辨率。 提出了幾種提高高分辨率彩色深度圖像空間分辨率的方法。 他們已經開發了多種方法,包括Markov random fields [48, 15, 46, 56, 63], shape-from- [27,76], segmentation[45]和dictionary methods[21,34, 49, 69]。 雖然其中一些技術可以用于深度完井,但超分辨率的挑戰是非常不同的——在那裡,重點是提高空間分辨率,在那裡,低分辨率測量被認為是完整的,并定期采樣。 相比之下,我們的重點是填補漏洞,這可能是相當大和複雜的,是以需要合成大規模的内容。

稀疏樣本深度重建。 其他工作研究了用稀疏深度測量集增強彩色圖像的深度重建。 Hawe等人研究了用小波基重構[29]。 Liu等人将小波和contourlet字典[43]結合起來。 Ma等人表明,對于NYUv2[47],提供∼100個間距良好的深度樣本比僅使用顔色的方法提高了兩倍的深度估計,但仍然得到了相對較低品質的結果。 這些方法與我們的工作有一些共同之處。 然而,他們的動機是降低在特殊環境下的傳感成本(例如,為機器人省電),而不是完成通常在現成的深度相機中遺漏的資料。

3. 方法

本文研究了如何利用深度網絡來完成單個RGB-D圖像的深度通道。 我們的調查集中在以下幾個問題上:“我們如何獲得深度完成的教育訓練資料?” ,“我們應該使用什麼深度表示?” 以及“顔色和深度的線索應該如何組合?”

3.1。 資料集

我們解決的第一個問題是建立一個資料集的RGB-D圖像與完成的深度圖像配對。

實作這一任務的一個直接方法是使用低成本的RGB-D錄影機捕捉圖像,并用成本更高的深度傳感器将它們與同時捕獲的圖像對齊。 這種方法是昂貴和耗時的——這種類型的最大公共資料集覆寫了少量的室内場景(例如,[57,62,75])。

相反,為了建立我們的資料集,我們利用現有的表面網格重構從多視圖RGB-D掃描大型環境。 這類資料集有幾個,其中包括Matterport3D[8]、ScanNet[12]、SceneNN[32]和SUN3D[26,72]等。 我們使用Matter-port3D。 對于每個場景,我們使用經過篩選的Poisson surface reconstruction[33]從全局表面重建中提取一個三角形網格M,每個房間有大約1-6百萬個三角形。 然後,對場景中的RGB-D圖像進行采樣,從圖像視點的相機位姿出發,将重構後的網格M進行渲染,得到完整的深度圖像D*。 這個過程為我們提供了一組不用收集新資料的RGB-D→D*圖像對。

圖3顯示了來自資料集的深度圖像補全的一些示例。 盡管完井并不總是完美無缺的,但它們具有一些有利的性能

圖3。 深度資料集完成。 深度完井是通過對大型室内環境的多視圖表面重建計算得到的。 在本例中,底部顯示了原始顔色和深度通道,視點的呈現深度标記為紅點。 渲染網格(在大圖中由頂點着色)是通過結合來自場景中各種其他視圖的RGB-D圖像建立的(黃色點),這些視圖在渲染到紅點視圖時協同填充空洞。

為我們的問題[52]訓練一個深度網絡。 首先,完成的深度圖像通常有更少的孔。 那是因為它不受限于一個相機角度的觀察(例如,圖3中的紅點),而是由所有錄影機的觀察視角的結合導緻表面重建(黃點在圖3)。是以,表面遙遠的一個視圖,但另一個範圍内,将包括在完成深度圖像。 同樣,光滑的表面,當以掠射角度觀察時,通常不提供深度資料,可以用其他相機更直接地觀察表面的資料填充(注意,在渲染深度中,光澤地闆的完成)。 我們的重建過程平均填補了原始深度圖像中缺失像素的64.6%。

其次,完成的深度圖像通常複制了近距離表面的原始分辨率,但對遠距離表面的分辨率要高得多。 由于表面重建的三維網格大小與深度相機的分辨率相當,是以在完成深度圖像中通常不會丢失分辨率。 然而,當投影到視圖平面上時,同樣的3D分辨率為離錄影機更遠的表面提供了更高的像素分辨率。 是以,在渲染高分辨率網格時,完成的深度圖像可以利用亞像素反走樣來獲得比原始圖像更好的分辨率(請注意圖3中家具中的細節)。

最後,完成的深度圖像通常比原始圖像的噪聲小得多。 由于表面重建算法通過濾波和平均的方法結合了來自多個相機視圖的噪聲深度樣本,本質上對表面去噪。 這對于遠距離觀測(例如>4米)尤其重要,因為原始深度測量是量子化和有噪聲的。

總的來說,我們的資料集包含了117516張渲染完的RGB-D圖像,我們将其分為一個包含105,432張圖像的訓練集和一個包含12,084張圖像的測試集。

3.2。 深度表示

第二個有趣的問題是“什麼幾何表示最适合深度補全?”

一種直接的方法是設計一個從原始深度和顔色回歸完成深度的網絡。 然而,絕對深度很難從單目圖像中預測,因為它可能需要對象大小、場景類别等知識。

以前的工作考慮了深度的一些間接表示。 例如,Chen等人研究了相對深度[9]。 Charkrabarti等人提出了深度導數[7]。 Li等人将深度導數與深度[39]結合使用。 我們已經用基于預測導數的方法進行了實驗。 然而,我們發現他們并沒有在我們的實驗中表現得最好(見第4節)。

相反,我們專注于預測表面法線和遮擋邊界。 由于法線是微分曲面性質,它們隻依賴于像素的局部鄰域。 此外,它們與直接在彩色圖像中觀察到的局部光照變化密切相關。 是以,以往對彩色圖像表面法線密度預測的研究取得了很好的結果[3,18,38,71,80]。 類似地,遮擋邊界以像素為機關産生局部模式(如邊緣),是以通常可以用深度網絡來魯棒檢測它們[17,80]。

然而,一個關鍵的問題是,我們如何使用預測的表面法線和遮擋邊界來完成深度圖像。 一些研究人員已經使用預測法線來細化觀察到的3D表面的細節[28,55,74],Galliani等人使用表面法線來恢複桌面對象多視圖重建中缺失的幾何形狀。 然而,對于複雜環境下單目RGB-D圖像的深度估計或補全,還沒有人使用過表面法線。

不幸的是,僅從表面法線和遮擋邊界求解深度在理論上是不可能的。 有些病理情況下,圖像不同部分之間的深度關系不能僅從法線推斷出來。 例如,在圖4(a)中,僅根據給定的表面法線是不可能推斷出通過視窗看到的牆的深度的。 在這種情況下,可見區域的牆壁是完全封閉的

圖4。 使用表面法線求解深度補全。 (a)無法從表面法線解出深度的一個例子。 (b)缺少深度的地區用紅色标出。 紅色箭頭表示深度不能從曲面n -mals積分的路徑。 然而,在真實世界的圖像中,通常有許多通過相鄰像素(沿着地闆、天花闆等)連接配接的路徑,可以在這些路徑上內建深度(綠色箭頭)。

通過遮擋邊界(輪廓線)從相機的角度,使其深度不确定相對于其餘的圖像。

然而,在實際應用中,對于真實場景,圖像的一個區域不太可能同時被遮擋邊界包圍并且完全不包含原始深度觀察(圖4(b))。 是以,我們發現利用預測的遮擋邊界權重的相幹性預測表面法線和受觀測原始深度限制的正則化來完成深度圖像中較大的孔是可行的。 在實驗中,我們發現,從預測的表面法線和遮擋邊界求解深度,比預測絕對深度目錄,甚至從深度導數求解深度完井效果更好(見第4節)。

3.3。 網絡架構與教育訓練

第三個有趣的問題是“訓練一個深度網絡來預測表面法線和遮擋邊界的最佳方法是什麼?”

在我們的研究中,我們選擇了Zhang等人提出的deep network architecture,因為它在正常估計和邊界檢測方面都表現出了競争性能[80]。 該模型是一個建立在VGG-16後骨骼上的全卷積神經網絡,具有對稱的編碼器和解碼器。 它還配備了用于相應的最大池和反池層的捷徑連接配接和共享池掩碼,這對于學習本地圖像特性至關重要。 我們用重建網格計算出的“地面真實”表面法線和輪廓邊界訓練網絡。

在選擇了這個網絡之後,關于如何對其進行深度補全的訓練仍然存在一些有趣的問題。 下面的段落将重點讨論這些問題的正常估計,但是這些問題和結論同樣适用于遮擋邊界檢測。

什麼損失應該用來教育訓練網絡? 與以往的表面法線估計工作不同,我們的主要目标是訓練一個網絡來預測原始深度圖像孔内像素的法線。 由于這些像素的顔色外觀特征很可能與其他像素不同(閃亮、遠離錄影機等),是以有人可能認為應該對網絡進行監控,以便僅對這些像素進行歸一化處理。 然而,洞裡的像素比沒有的要少,是以這種類型的訓練資料是有限的。 目前還不清楚是否最好的訓練是隻針對孔還是針對所有像素。 是以,我們對兩者進行了測試和比較。

我們将觀察到的像素定義為具有來自原始傳感器和呈現網格的深度資料的像素,将未觀察到的像素定義為具有來自呈現網格的深度的像素,而不是原始傳感器。 對于任意給定的一組像素(觀察到的、未觀察到的或兩者都有),我們通過在反向傳播過程中屏蔽其他像素上的梯度來訓練隻有這些像素損失的模型。

定性和定量結果比較不同訓練模型的結果顯示在補充材料。 結果表明,用所有像素訓練的模型比隻使用觀察到的或隻使用未觀察到的像素訓練的模型表現得更好,而使用呈現的norm -mals訓練的模型比使用原始法線訓練的模型表現得更好。

網絡應該輸入哪些圖像通道? 有人可能認為,訓練網絡從原始的RGB-D圖像預測地表法線的最好方法是提供所有四個通道(RGBD)并訓練它傳回三個正常通道。 然而,令人驚訝的是,我們發現,當以這種方式訓練時,我們的網絡在預測沒有觀測深度的像素法線方面表現得很差。 它們很擅長預測具有觀測深度的像素的法線,但不擅長預測孔内的法線。 ,深度補全所需的。 無論損失中包含什麼像素,這個結果都成立。

我們推測,原始深度訓練的網絡主要學習直接從深度計算法線,而沒有學習如何在深度不存在的情況下從顔色預測法線,這是深度補全的關鍵技能。 一般來說,我們發現,即使給網絡一個額外的通道,其中包含一個二進制掩碼,表明哪個像素具有觀察到的深度,網絡也能更好地從顔色而不是深度來預測normals[79]。 例如,在圖5中,我們看到僅從顔色預測的大洞中的法線比從深度預測的法線好,并且與從顔色和深度預測的法線一樣好。 表1中的定量實驗支援了這一發現。

這個結果非常有趣,因為它表明,我們可以訓練一個網絡,僅從顔色來預測表面法線,并且在從法線求深度時,僅将觀測到的深度作為正則化處理(下一節)。 将“無深度預測”與“有深度優化”分離開來的政策之是以引人注目,有兩個原因。 首先,預測網絡不需要針對不同深度的傳感器進行再訓練。 其次,優化可以

圖5。 不同輸入的表面法向估計。 第一行顯示了輸入的彩色圖像、原始深度和呈現的法線。 下面一行顯示了隻輸入深度、顔色和兩者時的表面正常預測。 中間的模型在缺失的區域表現最好,即使沒有深度作為輸入,在其他地方也可以與其他兩個模型進行比較。

廣義地以各種深度觀測為再ularization,其中可能包括稀疏深度樣本[47]。 這在第4節中進行了實驗研究。

3.4。 優化

在預測了面法線圖像N和遮擋邊界圖像B後,我們解出一組方程組來完成深度圖像d。目标函數定義為四項誤差的權重平方和:

E =λDED +λSES +λNENB ED =

X

p∈則

| | D (p)−D0 (p) | | 2

EN =

X

p, q∈N

|| < v(p, q), N(p) > ||2 (1)

ES =

X

p, q∈N

| | D (p)−D (q) | 2

其中ED測量像素p處估計深度D(p)與觀測原始深度D0(p)之間的距離,EN測量估計深度與預測表面法線N(p)之間的一緻性,ES鼓勵相鄰像素具有相同的深度。 B∈[0,1]對基于預測機率的法線項進行降級,其中a像素位于遮擋邊界(B(p))。

在最簡單的形式下,這個目标函數是非線性的,這是由于點積與EN中的表面法線所需的切向量v(p, q)的歸一化。 然而,我們可以用線性形式近似這個誤差項,如[55]中所建議的,通過前面的向量歸一化。 在其他設定中,這種近似會增加縮放誤差的敏感性,因為更小的深度會導緻更短的切線和更小的EN項。 然而,在深度完成設定中,資料表示力

深度完成 表面正常的估計

輸入Rel↓RMSE 1.253 1.252 1.25 1.10 1.05↓↑↑↑↑↑↓↓中位數11.25意味着深度30↑↑↑22.5 0.107 0.165 38.89 48.54 61.12 73.57 80.98 35.08 23.07 27.6 49.1 58.6 0.090 0.124 40.13 51.26 64.84 76.46 83.05 35.30 23.59 26.7 48.5 58.1顔色0.089 0.116 40.63 51.21 65.35 76.64 82.98 31.13 17.28 37.7 58.3 67.1

表1。 不同輸入對我們深層網絡的影響。 我們訓練模型的深度,顔色,和分别為表面法線估計和深度完成。 僅使用顔色作為輸入就可以獲得與兩者類似的性能。

全局解決方案,通過強制與觀察到的原始深度保持一緻來保持正确的規模,是以這不是一個重要的問題。

由于方程組的矩陣形式是稀疏對稱正定的,我們可以用稀疏Cholesky因子分解(如CSparse[13]中的cs cholsol)有效地求解。 最後的解是近似目标函數的全局最小值。

這種線性化方法對該方法的成功與否至關重要。 表面法線和遮擋邊界(以及可選的深度導數)隻捕獲表面幾何的局部屬性,這使得它們相對容易估計。 隻有通過全局優化,我們才能把它們結合起來,在一個一緻的解決方案中完成所有像素的深度。

4. 實驗結果

我們進行了一系列實驗來驗證所提出的方法。 除非另有規定,否則網絡将在SUNCG資料集上進行預訓練[66,80],并對新資料集的訓練分割進行微調,隻使用顔色作為輸入,并計算所有呈現像素的損失。 進行了優化與λD = 103,λN = 1,和λS = 10−3。 對新資料集的測試拆分進行了評估。

我們發現,在NVIDIA TITAN X GPU上,從320x256的顔色預測表面法線和遮擋邊界需要約0.3秒。 在Intel Xeon 2.4GHz CPU上,求解深度的線性方程需要約1.5秒。

4.1。 燒蝕研究

第一組實驗研究不同的測試輸入、訓練資料、損失函數、深度表示和優化方法如何影響深度預測結果(進一步的結果可以在補充材料中找到)。

由于我們的工作重點是預測深度傳感器無法觀測到的深度,是以我們的評估隻測量測試深度圖像中未觀測到的(但呈現在呈現的圖像中)測試圖像像素的深度預測誤差。 這與之前大多數深度估計的工作相反,以前的工作隻測量由深度相機觀察到的像素的誤差。

在評估深度預測時,我們報告相對于呈現深度的中值誤差(Rel)、以米為機關的均方根誤差(RMSE)和pix-的百分比

船預計深度下跌區間内([δ= |預測−真| /真]),δ是1.05,1.10,1.25,1.252,1.253。 除了增加1.05和1.10的門檻值以支援更細粒度的評估之外,這些名額是以前深度預測工作中的标準。

在評估表面法線預測時,我們報告平均值和中值誤差(以度為機關),以及法線預測值小于門檻值11.25、22.5和30度的像素百分比。

應該向網絡輸入什麼資料? 表1顯示了一個實驗的結果,該實驗測試哪種類型的輸入最适合我們的正常預測網絡:隻顯示顔色、隻顯示原始深度,或者兩者兼備。 從直覺上看,兩者都輸入似乎是最好的。 然而,我們發現,當隻給出顔色時,網絡學習預測表面法線更好(中值誤差= 17.28◦的顔色和23.07◦的兩個),這導緻深度估計也略好(Rel = 0.089 vs. 0.090)。 無論我們對所有像素進行深度訓練,隻對觀察到的像素進行深度訓練,還是隻對未觀察到的像素進行深度訓練(結果是補充材料),這種差異都會持續存在。 我們預計原因是,如果有觀測深度,網絡可以快速地學習插值,這阻礙了它學習在大孔中合成新的深度。

這個結果的影響是相當顯著的,因為它激發了我們的兩階段系統設計,将正常/邊界預測隻從顔色和原始深度優化中分離出來。

什麼深度表示最好? 表2顯示了一個實驗的結果,測試哪種深度表示最适合我們的網絡進行預測。 我們分别訓練網絡預測絕對深度(D)、表面法線(N)和8個方向的深度導數(DD),然後通過優化方程1使用不同的組合完成深度。 結果表明,從預測法線(N)求深度得到的結果最好(Rel = 0.089),而深度(D)為0.167,導數(DD)為0.100,法線和導數(N+DD)為0.092。 我們預計這是因為法線隻表示曲面的方向,這相對容易預測[35]。 此外,與深度或深度導數不同,法線不随深度縮放,是以在一系列視圖中更一緻。

遮擋邊界的預測有幫助嗎? 表2的最後六行顯示了要測試的實驗結果

B代表Rel↓RMSE↓1.05↑1.10↑1.25↑1.252↑1.253↑1.253↑- D 0.167 0.241 16.43 31.13 57.62 75.63 84.01

不

DD 0.123 0.176 35.39 45.88 60.41 73.26 80.73 N+DD 0.112 0.163 37.85 47.22 61.27 73.70 80.83

N 0.110 0.161 38.12 47.96 61.42 73.77 80.85

是的

DD 0.100 0.131 37.95 49.14 64.26 76.14 82.63 N+DD 0.092 0.122 39.93 50.73 65.33 77.04 83.25

N 0.089 0.116 40.63 51.21 65.35 76.74 82.98

表2。 預測表示法對深度精度的影響。 DD表示深度導數,N表示曲面法線。 并對邊界權值的應用效果進行了評價。 第一行顯示了直接估計深度的性能。 總的來說,用表面法線和遮擋邊界求解反深度的效果最好。

圖6。 遮擋邊界預測對法線的影響。 第二列顯示了估計的表面法線和遮擋邊界。 第3列和第4列顯示了帶有/不包含遮擋邊界權值的優化結果。 為了幫助了解三維幾何和局部細節,我們還可視化了從輸出深度計算出的表面法線。 遮擋邊界提供了深度不連續的資訊,有助于保持邊界的銳度。

是否降低接近預測遮擋邊界的表面法線的權重有助于優化器解決更好的深度問題。 第2-4行沒有邊界預測(第一列中的“No”),第5-7行有邊界預測(“Yes”)。 結果表明,邊界預測将結果提高了約19% (Rel = 0.089 vs. 0.110)。 這表明網絡平均正确地預測了表面法線有噪聲或不正确的像素,如圖6所示。

需要觀察多少深度? 圖7顯示了一個實驗的結果,測試我們的深度補全方法在多大程度上依賴于輸入深度的數量。 為了研究這個問題,我們通過随機屏蔽不同像素數的輸入深度圖像,然後将其提供給優化器,以便從預測的法線和邊界解出完整的深度。 這兩個圖顯示了曲線,表示原始深度圖像中觀察到的像素(左)和未觀察到的像素(右)的深度精度。 從這些結果中,我們可以看到,優化器能夠在隻給出原始深度圖像中一小部分像素的情況下,幾乎同樣精确地求解深度。 正如預期的那樣,在未被原始深度觀察到的像素上,性能要差得多(它們更難)。 然而,深度估計仍然是相當好的時候

圖7。 稀疏原始深度輸入對深度精度的影響。 該方法具有良好的完井效果。 t個具有深度的輸入像素。 從圖中可以看出,對于未觀測到的像素點,深度估計要比觀測到的困難。 實驗結果表明,該方法僅對少量的稀疏像素具有良好的處理效果,在實際應用中得到了廣泛的應用。

隻提供了一小部分原始像素(曲線上最右邊的點在2000像素處,僅占所有像素的2.5%)。 結果表明,該方法可用于其它稀疏測量深度傳感器的設計。 在這種情況下,我們的深層網絡将不必為每一個新的高密度傳感器(因為它隻取決于顔色)重新訓練,這是我們兩階段方法的一個好處。

4.2。 與基線方法的比較

第二組實驗研究了該方法與基線繪制深度和深度估計方法的比較。

表8顯示了一項研究結果,該研究将我們提出的方法與典型的非資料驅動的深度Inpainting方法進行了比較。 本研究的重點是建立已知方法的執行情況,進而為這個新資料集提供一個關于問題有多難的基線。 是以,我們考慮的方法包括:a)聯合雙線性濾波[64](雙邊),b)快速雙邊求解器[5](fast), c)全局邊緣感覺能量優化[20](TGV)。 表8中的結果表明,我們的方法明顯優于這些方法(Rel=0.089,而其他方法的結果是0.103-0.151)。 該方法通過訓練用深度網絡預測曲面法線,學習用資料驅動的先驗來完成深度,這比簡單的幾何啟發式算法更有效。 圖8顯示了與經過測試的最佳手工調優方法(雙邊)之間的差異。

方法Rel↓RMSE↓1.05↑1.10↑1.25↑1.252↑1.253↑光滑度0.151 0.187 32.80 42.71 57.61 72.29 80.15

雙側[64]0.118 0.152 34.39 46.50 61.92 75.26 81.84 Fast [5] 0.127 0.154 33.65 45.08 60.36 74.52 81.79 TGV [20] 0.103 0.146 37.40 48.75 62.97 75.00 81.71

我們的0.089 0.116 40.63 51.21 65.35 76.74 82.98

表3。 與基線畫法比較。 我們的方法明顯優于基線繪畫方法。

與深度估計方法的比較結果如表4所示

圖8。 與雙側聯合濾光片inpainting比較。 我們的方法從顔色中學習到更好的指導,産生了比較清晰和準确的結果。

圖9。 與深度估計方法比較。 在此基礎上,對現有的深度估計方法進行了比較。 我們的方法不僅能産生精确的深度值,而且能産生反映在表面法線上的大規模幾何形狀。

以前的方法,估計深度隻從顔色。 我們考慮比較查克拉巴蒂等人的[7],其方法

Obs Meth Rel↓RMSE↓1.05↑1.10↑1.25↑1.252↑1.253↑Y

[37] 0.190 0.374 17.90 31.03 54.80 75.97 85.69 [7] 0.161 0.320 21.52 75.5 58.75 77.48 85.65 our 0.130 0.274 30.60 43.65 61.14 75.69 82.65

N

[37] 0.384 0.537 8.86 16.67 34.64 55.60 69.21 [7] 0.352 0.610 11.16 20.50 37.73 57.77 70.10 our 0.283 0.537 17.27 27.42 44.19 61.80 70.90

表4。 與深度估計方法比較。 我們與Laina等人的[37]和Chakrabarti等人的[7]進行了比較。 所有方法在未觀測到的像素上的性能都比觀測到的像素差,說明未觀測到的像素更難處理。 我們的方法明顯優于其他方法。

最類似于我們的(它使用預測的衍生物),以及Laina等人的[37],他們最近在NYUv2的實驗中報告了最先進的結果[64]。 我們對資料集中的[7]進行了微調,但是沒有提供[37]在NYUv2上的預訓練模型,因為沒有提供它們的訓練代碼。

當然,這些深度估計方法解決的問題與我們的不同(沒有輸入深度),替代方法對深度值的比例尺具有不同的敏感性,是以我們盡最大努力使它們和我們的方法适應相同的設定,以便進行公平的比較。 為此,我們運作所有隻使用彩色圖像作為輸入的方法,然後均勻地縮放它們的深度圖像輸出,以在一個随機像素上完美地與真實深度對齊(對所有方法選擇相同的)。 在我們的例子中,由于方程1是欠限制的,沒有任何深度資料,我們在優化過程中任意将中間像素設定為3米的深度,然後應用與其他方法相同的縮放。 這種方法的重點是比較預測的“形狀”的計算深度圖像,而不是其全球規模。

比較結果如圖9和表4所示。 從圖9的定性結果中,我們可以看到我們的方法最好地再現了場景的結構和精細的細節——即使隻有一個原始深度的像素。 由表4所示的定量結果可知,無論評價像素是否具有觀測深度(Y) (N),我們的方法都比其他方法好23-40%。這些結果表明,預測表面法線也是一種很有前途的深度估計方法。

5. 結論

本文介紹了一種利用RGB-D錄影機完成RGB-D圖像深度通道的深度學習架構。 它提供了兩個主要的研究貢獻。 首先,提出了利用顔色預測表面法線和遮擋邊界的兩階段過程來完成深度,然後根據這些預測來求解完成深度。 其次,通過對大規模地表重建資料的監督訓練,學習完成深度圖像。 在使用新的基準進行測試時,我們發現所提出的方法在繪制深度和估計方面優于以前的基線方法。

參考文獻

适用于windows的[1]Kinect。 https://developer.microsoft.com/en-us/windows/kinect。 14

[2]結構傳感器。 https://structure.io/。 14

[3] A. Bansal, B. Russell和A. Gupta。 Marr重溫:通過表面法線預測二維-三維對準。 《IEEE計算機視覺與模式識别會議論文集》,2016年第5965-5974頁。 4

[4] J. T.巴倫和J.馬利克。 單一rgb-d圖像的固有場景屬性。 《IEEE計算機視覺與模式識别會議論文集》,2013年第17-24頁。 2

[5] J. T.巴倫和B.普爾。 快速雙邊解決方案。 在歐洲計算機視覺會議上,第617-632頁。 施普林格,2016年。 7、15

[6] M. Bertalmio, A. L. Bertozzi和G. Sapiro。 納維-斯托克斯,流體動力學,圖像和視訊繪畫。 計算機視覺與模式識别,2001。 CVPR 2001。 2001年IEEE計算機學會會議論文集,第1卷,第1頁。 IEEE 2001。 2

[7] A. Chakrabarti, J. Shao和G. Shakhnarovich。 通過協調過于完整的本地網絡預測,從單個圖像獲得深度。 《神經資訊處理系統研究進展》,第2658-2666頁,2016。 4、8、13

[8] A. Chang, A. Dai, T. Funkhouser, M. Halber, M. Niessner, M. Savva, S. Song, A. Zeng, Y。 張。 Matterport3d:在室内環境中學習rgb-d資料。 2017年3D視覺國際會議(3DV)。 3.

[9] W. Chen, Z. Fu, D. Yang, J. Deng。 單幅圖像在野外的深度感覺。 《神經資訊處理系統的進展》,第730-738頁,2016。 4

[10] W. Chen, H. Yue, J. Wang,和X. Wu。 一種改進的深度圖嵌入邊緣檢測算法。 《光學與雷射工程》,55:69-77,2014。 2

[11] M. Ciotta和D. routsos。 深度引導圖像完成結構和紋理合成。 在聲學、語音和信号處理(ICASSP), 2016年IEEE國際會議上,第1199-1203頁。 IEEE 2016。 2

[12]a, a . x, m·薩瓦m .沒什麼,t . Funkhouser和m . Nießner。 Scannet:豐富的室内場景三維重建注釋。 《IEEE計算機視覺與模式識别會議論文集》(Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017)。 3、14

[13]t·戴維斯。 Csparse。 工業與應用數學學會,費城,2006。 6

[14]j . D 'Errico。 填補nan, 2017年。 www.mathworks.com/matlabcentral/fileexchange/4551-

inpaint-nans。 15

[15] J. Diebel和S. Thrun。 馬爾可夫随機場在距離傳感中的應用。 《神經資訊處理系統的進展》,第291-298頁,2006。 2

[16] D. Doria和R. J. Radke。 通過嵌入深度梯度填充雷射雷達資料中的大孔。 在計算機視覺和模式識别研讨會(CVPRW), 2012年IEEE計算機學會會議上,第65-72頁。 IEEE 2012。 1、2

[17] K. A. Ehinger, W. J. Adams, E. W. Graf, J. H. Elder, K. Vaia-pury, B. Purushothaman, A. Pal, S. Agarwal, B. Bhowmick,

I. Rafegas等。 局部深度邊緣檢測與深度神經網絡。 在《IEEE計算機視覺與模式識别會議論文集》2017年第2681-2689頁。

[18] D. Eigen和R. Fergus。 使用通用的多尺度卷積結構預測深度、表面法線和語義标簽。 發表于2015年IEEE計算機視覺國際會議論文集,第2650-2658頁。 2、4

[19] D. Eigen, C. Puhrsch和R. Fergus。 利用多尺度深度網絡對單幅圖像進行深度地圖預測。 《神經資訊處理系統研究進展》,2014年第2366-2374頁。 1、2

[20]d . Ferstl c . Reinbacher r . Ranftl m . Rü,女孩和h。 利用各向異性總廣義變異量進行圖像引導深度上采樣。 在計算機視覺(ICCV), 2013年IEEE國際會議上,第993 - 1000頁。 IEEE 2013。 7、15

[21] W. T. Freeman, T. R. Jones和E. C. Pasztor。 基于執行個體的超分辨率。 IEEE計算機圖形與應用,22(2):56-65,2002。 2

[22] S.加利亞尼和K.辛德勒。 隻看圖像:特定于視點的表面法線預測,用于改進的多視點重建。 《IEEE計算機視覺與模式識别會議論文集》,2016年第5479-5487頁。 4

[23]d·加西亞。 一維及更高維網格資料的魯棒平滑與缺失值。 計算統計學與資料分析,54(4):1167-1178,2010。 15

[24] J. Gautier, O. Le Meur和C. Guillemot。 基于深度的圖像完成為視圖合成。 3D電視會議:3D視訊的真實視覺捕捉、傳輸和顯示(3DTV- con), 2011,第1-4頁。 IEEE 2011。 2

龔,劉,周,劉。 通過快速行進的方法引導深度增強。 圖像與視覺計算,31(10):695-703,2013。 2

[26] M. Halber和T. Funkhouser。 rgb-d掃描的精細到粗的全局配準。 《IEEE計算機視覺與模式識别會議論文集》(Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017)。 3.

[27]Y。 漢族,J。 - y。 李和我。 高品質的形狀從一個單一的rgb-d圖像在未經校準的自然光照。 發表于《IEEE計算機視覺國際會議論文集》(Proceedings of the IEEE International Conference on Computer Vision, page 1617-1624, 2013)。 2

[28] C. Hane, L. Ladicky和M. Pollefeys。 方向問題:使用表面法向分類器進行深度估計。 《IEEE計算機視覺與模式識别會議論文集》,381-389頁,2015。 4

[29] S. Hawe, M. Kleinsteuber和K. Diepold。 密集視差映射來自稀疏視差測量。 在計算機視覺(ICCV), 2011年IEEE國際會議上,第2126-2133頁。 IEEE 2011。 3.

[30]d Herrera, j . Kannala j .麼̈,等。 深度地圖在繪制之前的二階平滑度。 在斯堪的納維亞圖像分析會議上,第555-566頁。 施普林格,2013年。

[31] D. Hoiem, A. A. Efros和M. Hebert。 自動彈出照片。 《ACM圖形學報》(TOG), 24(3):577 - 584, 2005。 2

[32]s。 華,Q.-H。 阮文堂,m.k。 Tran L.-F。 Yu和研究。 楊。 場景:場景用注釋來網格資料集。 在3D視覺(3DV), 2016第四屆國際會議上,第92-101頁。 IEEE 2016。 3.

[33] M. Kazhdan和H. Hoppe。 篩選泊松曲面重建。 圖論ACM Transactions on Graphics (TOG), 32(3): 29,2013。 3、12

[34] M. Kiechle, S. Hawe和M. Kleinsteuber。 深度圖超分辨率的強度與深度聯合稀疏分析模型。 在IEEE計算機視覺國際會議論文集,第1545-1552頁,2013。 2

[35] J. J. Koenderink, A. J. Van Doorn, and A. M. Kappers。 圖檔中的表面感覺。 注意,知覺,&心理-喬波實體學,52(5):487-496,1992。 1、6

[36] M. Kulkarni和A. N. Rajagopalan。 用張量投票的方法畫出深度。 JOSA A, 30(6): 1155-1165, 2013。 2

[37] I. Laina, C. Rupprecht, V。 Belagiannis, F. Tombari和N. Navab。 全卷積剩餘網絡的深度預測。 在3D視覺(3DV), 2016第四屆國際會議上,第239-248頁。 IEEE 2016。 2、8

B.李,C.沈,Y。 戴,A.範登亨格爾,和M.何。 利用深度特征回歸和分層crfs對單目圖像進行深度和表面法線估計。 發表于2015年IEEE計算機視覺與模式識别會議論文集,第1119-1127頁。 4

李,克萊恩,姚。 一種雙流網絡,用于從單個rgb圖像估計精細的深度地圖。 在《IEEE計算機視覺與模式識别會議論文集》2017年第3372-3380頁。 4

劉f、沈c、林g和裡德。 利用深度卷積神經場從單目圖像中學習深度。 《IEEE模式分析與機器智能學報》,38(10):2024-2039,2016。 2

[41] J. Liu和X. Gong。 通過各向異性擴散引導深度增強。 在太平洋沿岸多媒體會議上,第408-417頁。 施普林格,2013年。 2

劉,龔,劉。 kinect深度地圖的引導inpainting和filter。 在模式識别(ICPR), 2012年第21屆國際會議上,2055-2058頁。 IEEE 2012。 2

[43]L.-K。 劉,陳少雄,阮子強。 稀疏樣本深度重構:表示、算法和采樣。 IEEE圖像處理學報,24(6):1983-1996,2015。 3.

[44]劉先生,何曉欣,和薩爾茲曼先生。 通過完成和産生幻覺的深度和語義來建構場景模型。 在歐洲計算機視覺會議上,第258-274頁。 施普林格,2016年。 2

[45] J. Lu和D. Forsyth。 稀疏深度超分辨率。 《IEEE計算機視覺與模式識别會議論文集》,2015年第2245-2253頁。 2

呂俊傑,戴敏,柏華,杜敏。 重溫基于mrf的深度圖超分辨率和增強。 在聲學,語音和信号處理(ICASSP), 2011年IEEE國際會議上,第985-988頁。 IEEE 2011。 2

[47] F. Ma和S. Karaman。 稀疏到稠密:從稀疏深度樣本和單個圖像進行深度預測。 預印本arXiv:1709.07492, 2017。 3、5

[48] O. Mac Aodha, N. D. Campbell, A. Nair和G. J. Bros-tow。 基于Patch的單深度圖像超分辨率合成。 在歐洲計算機視覺會議上,第71-84頁。 施普林格,2012年。 2

[49] M. Mahmoudi和G. Sapiro。 用于範圍資料恢複的稀疏表示。 [11]王建民,王建民。基于圖像處理的IEEE學報,21(5):2909-2915,2012。 2

[50]毛,沈,Y .- b。 楊。 圖像恢複使用非常深的卷積編解碼器網絡與對稱跳過連接配接。 《神經資訊處理系統進展》,第2802-2810頁,2016。 15

[51],松子和Y。 青木。 利用局部切平面近似增強深度圖像。 《IEEE計算機視覺與模式識别會議論文集》,3574-3583頁,2015。 1、2

[52]美國邁斯特,美國Izadi·克裡m公頃̈mmerle, c·洛特,d . Kondermann。 什麼時候可以使用kinectfusion進行地面真實感采集。 2012年第2期《機器人學中顔色-深度相機融合技術研讨會》。 3.

[53] E. Mingolla和J. T. Todd。 從陰影中感覺實體形狀。 生物控制論,53(3):137-151,1986。 1

[54] S. M. Muddala, M. Sjostrom和R. Olsson。 基于深度的inpainting用于去除遮擋填充。 3D電視大會:3D視訊的真實視覺捕捉、傳輸與顯示(3D電視大會),2014,第1-4頁。 IEEE 2014。 2

[55] D. Nehab, S. Rusinkiewicz, J. Davis和R. Ramamoorthi。 有效地結合位置和法線精确的三維幾何。 《ACM圖形學報》(TOG), 24(3):536 - 543, 2005。 4、5

柏建傑,金學賢,楊。 泰,布朗先生和奎恩先生。 高品質的深度地圖上采樣的三維tof相機。 在計算機視覺(ICCV), 2011年IEEE國際會議上,第1623-1630頁。 IEEE 2011。 2

[57] J.帕克,Q。 - y。 周,V。 Koltun。 重新通路彩色點雲注冊。 《IEEE計算機視覺與模式識别會議論文集》,第143-152頁,2017。 3.

[58] D. Pathak, P. Krahenbuhl, J. Donahue, T. Darrell和A. A. Efros。 上下文編碼器:通過inpainting學習。 在《IEEE計算機視覺與模式識别會議論文集》2016年第2536-2544頁。 2、15

[59] A. Roy和S. Todorovic。 利用神經回歸森林進行單目深度估計。 在《IEEE計算機視覺與模式識别會議論文集》2016年第5506-5514頁。 2

[60] A. Saxena, s.h. Chung和a.y。 Ng。 單目圖像的學習深度。 《神經資訊處理系統的進展》,第1161-1168頁,2006。 2

[61] A. Saxena, M. Sun和A. Y。 Ng。 Make3d:從單個靜止圖像學習三維場景結構。 [11]張建民,張建民,等。基于模态分析與機器智能的IEEE學報,31(5):824 - 840,2009。 2

[62]d . Scharstein h . Hirschmü噢,Y。 Kitajima, g . Krathwohl n . Nešićx Wang和p .韋斯特林。 高分辨率立體資料集與子像素精确的地面真相。 在德國模式識别會議上,第31-42頁。 施普林格,2014年。 3.

[63] E. Shabaninia, A. R. Naghsh-Nilchi和S. Kasaei。 高階馬爾可夫随機場用于單深度圖像的超分辨率。 IET計算機視覺,2017。 2

[64] N.希爾伯曼,D.霍伊姆,P.科利和R.費格斯。 室内分割和支援從rgbd圖像推理。 計算機視覺- eccv 2012,第746-760頁,2012。 1 7 8 15

[65] S. Song, S. P. Lichtenberg, J. Xiao。 Sun rgb-d: rgb-d場景了解基準套件。 在IEEE計算機視覺與模式識别會議論文集,567-576頁,2015。 14

[66]宋聖,餘發,曾,常,薩瓦,芬克豪斯。 語義場景完成從一個單一的深度圖像。 IEEE計算機視覺與模式識别會議論文集,2016。 6

[67] S. Suwajanakorn, C. Hernandez和S. M. Seitz。 深度從焦點與您的手機。 《IEEE計算機視覺與模式識别會議論文集》,3497-3506頁,2015。 2

[68] A. K. Thabet, J. Lahoud, D. Asmar, B. Ghanem.分段平面場景中深度地圖的三維感覺校正與補全。 在亞洲計算機視覺會議上,第226-241頁。 施普林格,2014年。 2

[69] I. Tosic和S. Drewes。 學習聯合強度-深度稀疏表示。 IEEE圖像處理學報,23(5):2122-2132,2014。 2

[70] A. van den Oord, N. Kalchbrenner, L. Espeholt, O. Vinyals, A. Graves等。 條件圖像生成與像素-cnn解碼器。 《神經資訊處理系統進展》,2016年第4790-4798頁。

[71]王曉霞,傅希,古普塔。 設計用于表面法向估計的深度網絡。 《IEEE計算機視覺與模式識别會議論文集》,539-547頁,2015。 4

[72] J. Xiao, A. Owens, A. Torralba。 Sun3d:使用sfm和對象标簽重建大空間的資料庫。 在IEEE計算機視覺國際會議論文集,1625-1632頁,2013。 3.

[73]謝,R.格希克,A.法哈迪。 深度3d:采用深度卷積神經網絡,全自動2d- 3d視訊轉換。 在歐洲計算機視覺會議上,第842-857頁。 施普林格,2016年。 2

[74]謝文文,王文民,齊曉霞,張林。單法線貼圖的三維表面細節增強。 在《IEEE計算機視覺與模式識别會議論文集》2017年第2325-2333頁。 4

[75]薛,張,蔡。 深度圖像繪制:改進低秩矩陣完成與低梯度正則化。 IEEE圖像處理學報,26(9):4311-4320,2017。 2、3

[76]L.-F。 于研究。 楊,Y, w。 基于陰影的rgb-d圖像形狀細化。 《IEEE計算機視覺與模式識别會議論文集》,2013年第1415-1422頁。 2

[77]張洪濤,于傑,于志峰。 王。 機率輪廓引導深度圖的繪制和超分辨率使用非局部總廣義變異。 《多媒體工具與應用》,2017年第1-18頁。 2

[78]張,P.-S.。 蔡,J. E. Cryer和M. Shah。 Shape-from-shading:一項調查。 《IEEE模式分析與機器智能學報》,21(8):690-706,1999。 2

[79]張,J。 - y。 朱,P.伊索拉,耿曉霞,林亞生,餘,和A. A.埃弗羅斯。 實時使用者引導圖像着色與學習深先驗。 圖論ACM Transactions on Graphics (TOG), 9(4), 2017。 5、12

[80]Y。 張,宋,于默,薩瓦,J。 - y。 Lee, H. Jin和T. Funkhouser。 基于實體的卷積神經網絡室内場景了解渲染。 IEEE計算機視覺與模式識别會議論文集,2017。 4 6 12 15

[81]Y。 左,吳,張,安平。 顯式邊緣不一緻性評價模型用于彩色地圖深度增強。 IEEE視訊技術電路與系統學報,2016。 2

補充材料

本文檔包含了燒蝕研究的進一步實作細節和結果,跨資料集實驗,以及與其他不适合在主要論文中的inpainting方法的比較。

A.進一步實施細節

本節為我們的方法提供了額外的實作細節。 所有資料和代碼将在驗收後釋出,以確定重制性。

. 1。 網格重建與渲染

對于Matterport3D資料集中的每個場景,使用以下過程對網格進行重構和渲染,以提供“完整的深度圖像”。 首先,每個房子都被手動劃分成大緻對應于房間的區域,使用互動式的平面圖繪制界面。 其次,提取每個區域内包含RGB-D點(像素)的密集點雲,不包括距離錄影機4米以上的像素(避免重構網格中的噪聲)。 第三,利用經過篩選的泊松曲面重建[33],深度為oc-tree 11,從每個區域的點重建網格。 然後對所有區域的網格進行合并,形成每個場景的最終重構網格M。 然後,使用OpenGL為每個原始的RGB-D相機視圖建立“完成深度圖像”,并讀取深度緩沖區。

圖10顯示了使用此過程生成的網格的圖像。 第一行顯示了覆寫整個房子的外部視圖(左邊是頂點顔色,右邊是平陰影)。 底部一行顯示了網格内部視圖的特寫圖像。 雖然網格并不完美,但它有12.2米的三角形再現了大部分的表面細節。 請注意網格是完整的,在RGB-D圖像中通常出現的洞(窗戶,閃亮的桌面,椅子的薄結構,光滑的櫥櫃表面等)。 此外,請注意距離錄影機較遠的表面的高細節(例如,通過門道可以看到隔壁房間的家具)。

由信用證。 網絡體系結構

本項目所用的所有網絡均來自Zhang et.al[80]提出的表面法向估計模型,并進行了如下修改。

根據輸入的不同,網絡在第一卷積層接收不同通道的資料。

•顔色。 顔色是一個3通道張量,每個都有R G B。 強度值被歸一化為[-0.5 0.5]。

圖10。 為一個場景重建網格。 用于渲染完成深度圖像的網格從外部視圖(頂部)和内部視圖(底部)中顯示,使用頂點顔色(左側)和平面陰影(右側)進行渲染。

如果需要,我們使用雙線性插值來調整彩色圖像的大小。

•深度。 以米為機關的深度絕對值作為輸入。 沒有來自傳感器深度信号的像素被指派為零。 為了解決“缺失”和“0米”之間的模糊性,根據Zhang et.al[79]的建議,增加了一個二進制掩碼作為附加通道,該掩碼表示傳感器具有深度的像素。 總的來說,深度輸入包含2個通道(絕對深度和二進制有效掩碼)。 為了防止平滑不準确,我們使用最近鄰搜尋來調整深度圖像的大小。

•顔色+深度。 本例中的輸入是前面介紹的顔色和深度的連接配接。 這就産生了一個5通道張量作為輸入。

輸出網絡的絕對深度、表面法線、深度導數分别輸出1、3、8通道的結果。 遮擋邊界檢測網絡生成3個通道輸出,表示每個像素屬于“無邊緣”、“深度折痕”和“遮擋邊界”的機率。

損失深度、表面法線和導數被預測為回歸任務。 訓練深度和導數使用SmoothL1有損s1,訓練曲面法線使用餘弦包埋有損s2。 将遮擋邊界檢測轉化為分類任務,并利用交叉熵損失s3進行分類。 最後兩批歸一化lay-

1 https: / /github.com/torch/nn/blob/master/doc/criterion.md # nn.Smoot-hL1Criterion

2 https: / /github.com/torch/nn/blob/master/doc/criterion.md # nn.Cosine-EmbeddingCriterion

3 https: / /github.com/torch/nn/blob/master/doc/criterion.md # nn.CrossE-ntropyCriterion

輸入代表Rel↓RMSE↓1.05↑1.10↑1.25↑1.253↑C D 0.408 0.500 6.49 12.80 30.01 54.44 72.88 C 1/D 0.412 0.492 6.86 12.88 54.51 73.13 D D 0.167 0.241 31.43 57.62 75.63 84.01 D 1/D 0.199 0.255 73.70 74.19 83.85

我們的0.089 0.116 40.63 51.21 65.35 76.74 82.98

表5所示。 不同深度表示的比較。 預測深度(D)或視差(1/D)比預測表面法線和求解顔色或深度輸入的深度(我們的)結果更糟。

er被删除了,因為這在實踐中産生了更好的性能。

出具。 教育訓練模式

在Torch中實作了神經網絡的訓練和測試。 所有訓練任務均采用RMSprop優化算法。 動量設定為0.9,批量大小為1。 最初将學習率設定為0.001,并且每100K疊代将學習率降低一半。 所有模型在300K疊代内收斂。

B.進一步實驗結果

本節提供了額外的實驗結果,包括燒蝕研究、跨資料集實驗以及與其他深度完井方法的比較。

責任。 燒蝕研究

本文第4.1節提供了消融研究的結果,旨在研究不同的測試輸入、訓練資料、損失函數、深度表示和優化方法如何影響我們的深度預測結果。 本節将提供該類型的進一步結果。

不同設定訓練的曲面法向估計模型定性結果如圖11所示。 相比之下,使用我們設定的訓練曲面法向估計模型(即隻使用彩色圖像作為輸入,所有可用的像素都以渲染深度為監督,如圖4列所示),可以獲得最好的預測品質,進而有利于深度補全的全局優化。

什麼樣的地面真相更好? 本試驗研究了在訓練地面預報網絡時,應采用何種法線作為損失監測名額。 我們實驗了從原始深度圖像計算法線和從渲染網格計算法線。 表6前兩行(比較:Target)的結果表明,根據呈現深度訓練的模型比根據原始深度訓練的模型性能更好。 這種改進似乎部分來自于為未觀測區域提供訓練像素,部分來自于更精确的深度(更少的噪音)。

什麼損失應該用來教育訓練網絡? 本實驗研究的是在訓練曲面預測網絡時,哪些像素點應該包含在損失中。 我們隻使用未觀察到的像素進行實驗,隻使用觀察到的像素,并同時作為監督。 這三個模型分别訓練訓練分裂的新的資料集,然後評估與測試集的呈現法線。定量結果的最後三行表6(比較:像素)表明,模型訓練和監督從觀察到的和未被注意的像素(底部行)隻略優于一個訓練有素的工作或無法觀察到的像素像素。 這表明未觀測到的像素确實提供了額外的資訊。

什麼樣的深度表現最好? 本文考慮了幾種深度表示(n -mals、導數、深度等)。 本節提供了關于直接預測深度和視差(即1 /深度)的進一步結果,以補充/修正本文表2中的結果。

實際上,本文表2的第一行(第2列中的Rep為' D ')被錯誤地描述為直接通過顔色預測深度——它實際上是直接通過輸入深度預測整個深度。 那是個錯誤。 對不起,給您添麻煩了。 正确的結果在這個文檔表5的頂部行(Input=C, Rep=D)。 結果非常相似,沒有改變任何結論:預測表面法線,然後求解深度比直接預測深度好(Rel = 0.089 vs. 0.408)。

我們還考慮了Chakrabarti et.al等人在[7]等論文中提出的對差異而不是深度的預測。 我們分别訓練模型直接從顔色和原始深度來估計視差。 結果如表5所示。 我們發現,當顔色或深度作為深度補全應用程式的輸入時,估計差異導緻的性能并不比估計深度好。

B.2。 Cross-Dataset實驗

這個測試研究是否可能在一個資料集上訓練我們的方法,然後在另一個資料集上有效地使用它。

我們首先在Matterport3D和ScanNet資料集之間進行了實驗。 這兩種方法都具有針對大型環境集(每個∼1000個房間)的3D表面重構,是以可以為訓練提供合适的訓練資料,并使用呈現的網格測試我們的方法。 我們在每個資料集上分别訓練一個表面法向估計模型,然後在不進行微調的情況下對另一個測試集執行深度補全。 的

圖11。 不同訓練設定下的正常估計比較。 第4列顯示僅使用顔色作為輸入訓練模型的輸出,以及所有像素的渲染深度作為監督,這是我們為系統選擇的設定。 相對而言,它比其他替代訓練設定生成更好的表面法線。

比較設定 深度完成 面法線估計輸入目标像素Rel↓RMSE↓1.05↑1.10↑1.25↑1.252↑1.253↑均值↓中值↓11.25↓22.5↑30↑

目标顔色原色均為0.094 0.123 39.84 50.40 64.68 76.38 82.80 32.87 18.70 34.2 55.7 64.3顔色渲染均為0.089 0.116 40.63 51.21 65.35 76.64 82.98 31.13 17.28 37.7 58.3 67.1像素

未觀察到的顔色分别為0.090 0.119 40.71 51.22 65.21 83.04 31.52 17.70 35.4 57.7 66.6、0.089 0.116 40.63 51.21 65.35 76.64 82.13 17.28 37.7 58.3 67.1

輸入

深度渲染均為0.107 0.165 38.89 48.54 61.12 73.57 80.98 35.08 23.07 27.6 49.1 58.6,深度渲染均為0.090 0.124 40.13 51.26 64.84 76.46 83.05 35.30 23.59 58.5 58.1,顔色渲染均為0.089 0.116 40.63 51.21 65.35 76.64 82.13 17.28 37.7 58.3 67.1

表6所示。 燒蝕的研究。 利用不同的訓練投入和損失對估計的地面法線和求解的深度進行評估。 為了便于比較,在最後三行複制了main paper中的表1,作為不同輸入之間的比較。

定量結果如表7所示。 正如預期的那樣,模型在比對訓練資料源的測試資料集上工作得最好。 實際上,與ScanNet訓練的模型相比,Matterport3D訓練的模型具有更好的泛化能力,這可能是因為Matterport3D資料集具有更多樣化的錄影機視點範圍。 然而,有趣的是,當在另一個資料集上運作時,這兩個模型仍然可以很好地工作,即使它們根本沒有經過微調。 我們推測這是因為我們的表面法線預測模型隻訓練在顔色輸入上,這兩個資料集之間是相對相似的。 由于兩個資料集的深度圖像之間存在顯著差異,使用深度作為輸入的替代方法可能不能很好地推廣。

與結構傳感器[2]和Kinect[1]相比,來自in -tel RealSense的深度圖在短時間内具有更好的品質,但包含更多的缺失區域。 對于距離較遠的區域和表面有特殊材料,如光亮、黑暗等,深度信号可以完全丢失或極度稀疏。 我們從ScanNet資料集[12]中訓練了一個表面法向估計模型,并直接對SUN-RGBD資料集中Intel RealSense采集的RGBD圖像進行評估[65]。 結果如圖12所示。 從左到右依次顯示輸入彩色圖像、輸入深度圖像、使用我們的方法生成的完成深度圖像、輸入和完成深度圖的點雲可視化以及由完成深度轉換而來的表面法線。 從圖中可以看出,與Matterport3D和ScanNet相比,RealSense的深度包含了更多的缺失區域,但是我們的模型仍然生成了不錯的結果。

列車測試Rel RMSE 1.05 1.10 1.25 1.252 1.253 Matterport3D Matterport3D 0.116 40.63 51.21 65.35 76.74 82.98 ScanNet 82.04 76.04 82.64 mterport3d ScanNet

表7所示。 Cross-dataset性能。 我們分别在Matterport3D和ScanNet兩種資料集上訓練了表面法向估計模型,并對這兩種模型進行了測試。 模型在訓練它的資料集上工作得最好。 Matterport3D模型的泛化能力優于ScanNet模型。

這再次表明,我們的方法可以有效地運作在不同深度傳感器捕獲的具有顯著不同深度模式的RGBD圖像上。

B.3。 與深度繪畫方法的比較

本文的第4.2節比較了不同的畫深方法。 本節将在表8中提供該類型的進一步結果。 在本附加研究中,我們用以下方法進行了比較:

•DCT[23]:使用Matlab Central的代碼,通過離散餘弦變換求解線性系統的懲罰最小二乘,填補缺失值

4

。

•FCN[50]:使用Zhang et.al[80]的代碼,訓練具有對稱快捷連接配接的FCN,以原始深度為輸入,生成完成深度為輸出。

•CE[58]:訓練Pathak et.al的上下文編碼器,使用Github 5中的代碼來繪制深度圖像。

DCT[23]的結果與本文所提供的其他繪畫對比結果相似。 他們主要是插洞。

FCN和CE的結果表明,inpainting color的設計方法在inpainting depth上并不十分有效。 正如本文所描述的,使用FCN從深度學習深度的方法可能是懶惰的,并且隻學習複制和插值提供的深度。 然而,由于深度資料有許多不同于顔色的特征,是以問題比這更微妙。 對于初學者來說,上下文編碼器具有比我們的網絡更淺的生成器和更低的分辨率,是以生成的深度圖像比我們的更模糊。 更重要的是,地面真值深度資料可能有缺失值,這使得在上下文編碼器(CE)中對鑒别器網絡的訓練變得複雜——在一個簡單的實作中,生成器将被訓練來預測缺失值,以便欺騙鑒别器。 我們嘗試了多種方法來繞過這個問題,包括隻在未觀察到的像素上傳播梯度,

4 https: / /www.mathworks.com/matlabcentral/fileexchange/27994-inpaint-over-missing-data-in-1-d-2-d-3-d-nd-arrays

5 https: / /github.com/pathak22/context-encoder

在缺失區域填充平均深度值。 我們發現它們都不如我們的方法有效。

我們的方法以及與其他畫法的比較結果可以在本文最後的圖14、15、16中看到。 每兩行顯示一個示例,其中第二行顯示不同方法的完成深度,第一行顯示它們對應的表面法線,以便突出顯示細節和3D幾何。 對于每個例子,我們顯示輸入,ground truth,我們的結果,然後是FCN[50]的結果,joint bilateral filter[64],離散餘弦變換[23],隻有平滑的優化,和PDE[14]的結果。 可以看出,我們的方法生成了更好的大尺度平面幾何和更清晰的物體邊界。

方法Rel↓RMSE↓1.05↑1.10↑1.25↑1.252↑1.253↑光滑度0.151 0.187 32.80 42.71 57.61 72.29 80.15

雙側[64]0.118 0.152 34.39 46.50 61.92 75.26 81.84 Fast [5] 0.127 0.154 33.65 45.08 60.36 74.52 81.79 TGV [20] 0.103 0.146 37.40 48.75 62.97 75.00 81.71

Garcia et.al [23] 0.115 0.144 36.78 47.13 61.48 74.89 81.67 FCN [80] 0.167 0.241 16.43 31.13 57.62 75.63 84.01

我們的0.089 0.116 40.63 51.21 65.35 76.74 82.98

表8所示。 與基線畫法比較。 為了便于比較,我們将主論文中比較的方法複制到同一個表中。 我們的方法明顯優于基線繪畫方法。

我們還将完成的深度圖轉換為三維點雲進行可視化和比較,如圖13所示。 利用Matter-port3D資料集中提供的相機内建特性,将深度圖上的每個像素投影到三維點上,并從彩色圖像中複制顔色強度。 每一行都顯示一個例子,其中彩色圖像和點雲由地面真實值轉換而來,輸入深度(即包含大量缺失區域的傳感器原始深度),以及我們的方法FCN[50]的結果,聯合雙側濾波[64],平滑inpainting。 與其他方法相比,我們的方法保持了更好的三維幾何形狀和更少的邊界出血。

圖12。 我們在RealSense資料上的結果。 我們運作一個從ScanNet資料集訓練的模型,并在沒有finetune的情況下對Intel RealSense捕獲的RGBD圖像進行測試。 從左到右依次顯示輸入彩色圖像、輸入深度圖像、使用我們的方法生成的完成深度圖像、輸入和完成深度圖的點雲可視化以及由完成深度轉換而來的表面法線。 該方法對深度完井效果良好。

圖13。 點雲可視化方法與我們的其他方法進行比較。 我們将完成的深度轉換為點雲。 我們的模型産生了更好的三維幾何和更少的出血問題的邊界。

圖14。 更多的結果和比較inpainting方法。 每個示例都顯示在兩行中,其中第二行顯示輸入、地面真相和完成的深度,而第一行顯示第二行上每個對應深度映射的表面法線,以突出顯示細節。 我們的方法在一般作品中比其他繪畫方法要好。

圖15。 更多的結果和比較inpainting方法。 每個示例都顯示在兩行中,其中第二行顯示輸入、地面真相和完成的深度,而第一行顯示第二行上每個對應深度映射的表面法線,以突出顯示細節。 我們的方法在一般作品中比其他繪畫方法要好。

圖16。 更多的結果和比較inpainting方法。 每個示例都顯示在兩行中,其中第二行顯示輸入、地面真相和完成的深度,而第一行顯示第二行上每個對應深度映射的表面法線,以突出顯示細節。 我們的方法在一般作品中比其他繪畫方法要好。

<a class="rengong_notice-try" href="https://f.youdao.com/?vendor=fanyi-doc-result-bottom" target="_blank" rel="external nofollow" ></a>

<a class="rengong_notice-close" href="javascript:;" target="_blank" rel="external nofollow" >X</a>

</div></div>