論文題目:BlendedMVS: A Large-scale Dataset for Generalized Multi-view Stereo Networks

資料集和預訓練模型位址:在公衆号「3D視覺工坊」,背景回複「BlendedMVS」,即可直接下載下傳。

摘要:

盡管深度學習在多視圖立體比對領域取得了很大的進展,但是有限的訓練資料使得訓練模型很難泛化到看不見的場景。與其他的計算機視覺任務相比,制作大規模的MVS資料集是相對困難的,因為它需要昂貴的主動雷射掃描器和勞動密集的處理去獲得ground-truth的三維結構。本文提出一個新的大規模資料集BlendedMVS,為基于學習的MVS算法提供了足夠的訓練樣本。為了建立資料集,首先利用三維重建算法從給定的場景圖像中恢複出帶紋理的三維網格模型。然後将重建得到的三維網格模型渲染得到彩色圖像和深度圖。為了在模型訓練中引入環境的光照資訊,渲染得到的彩色圖像和原始輸入圖像進行混合,混合得到的彩色圖像作為網絡模型的訓練輸入。BlendedMVS資料集中包含超過17k的高分辨率圖像,涵蓋了各種場景,包括城市、建築、雕塑和小物體。實驗表明:和其他資料集相比,使用BlendedMVS訓練的網絡模型具有更好的泛化能力。

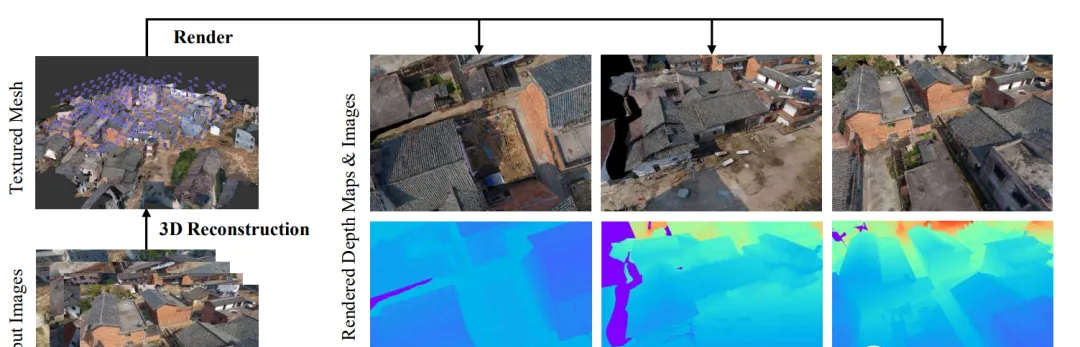

圖 1 渲染資料的生成流程,首先從輸入圖像中生成帶紋理的三維模型,然後将三維模型渲染到不同的視點下得到渲染圖像和深度圖。

一、資料集的制作:

資料集制作的流程如圖1所示,首先使用三維重建算法從輸入的圖像中生成帶紋理的三維網格模型。接下來,将三維網格模型渲染到每個相機視點下以獲得渲染的圖像和對應的深度圖。最終用于訓練的輸入圖像是渲染圖像和輸入圖像進行混合得到混合圖像。

1.1. 生成帶紋理的三維網格模型

建構合成MVS資料集的第一步是生成高品質的帶紋理的三維網格模型。給定輸入圖像,首先利用Altizure平台進行三維網格重建。該軟體會執行完整的三維重建算法,三維重建的輸出結果為帶紋理的三維網格模型和相機位姿。

如圖1所示,根據三維網格模型和輸入圖像的相機位姿,可以把三維模型渲染到各個視點下得到渲染的圖像和渲染的深度圖。渲染得到的深度圖将作為模型訓練時深度圖的ground-truth。

圖 2 混合圖像生成的流程,高通濾波器用于從渲染圖像中提取視覺線索,而低通濾波器從輸入圖像中提取環境光照資訊。

1. 2. 生成混合圖像

直覺上講,渲染得到的圖像可以直接作為網絡訓練。然而,一個潛在的問題是渲染得到的圖像不包含依賴視圖的光照。事實上,一個理想的MVS網絡訓練樣本應該滿足以下兩個條件:

① 圖像和深度圖應該一緻對齊,訓練樣本應該提供從輸入圖像到ground-truth深度圖的可靠映射。

② 圖像應該反射視點相關的光照。逼真的環境光照可以增強模型對真實場景的泛化能力。

二、場景

BlendedMVS資料集包含113個場景,涵蓋了各種不同的場景,包括建築、街景、雕塑和小型物體。每個場景包含20到1000張不等的輸入圖像,整個資料集共有17818張圖像。與DTU資料集相比,DTU資料集場景是通過一個固定的機械臂擷取的,BlendedMVS資料集中的場景包含各種不同的相機軌迹。非結構化的相機軌迹可以更好地模組化不同的圖像捕捉風格,使得網絡對真實世界的重建具有更好的泛化性能。

圖 3 BlendedMVS資料集中帶有相機軌迹的三維紋理模型,圖中藍色框表示三維空間中相機的位置。

三、實驗結果

為了驗證提出的資料集的有效性,作者在BlendedMVS資料集上訓練和評測了MVSNet、R-MVSNet和Point-MVSNet三種網絡模型。

3.1. 深度圖驗證

為了驗證BlendedMVS資料集的有效性,作者比較了在1)DTU訓練集、2)ETH3D低分辨率訓練集、3)MegaDepth資料集和4)BlendedMVS訓練集上訓練模型的效果。評測在對應資料集的驗證集上進行的。實驗中考慮的三個名額:1)終點誤差(end point error, EPE),即預測的深度圖與深度圖ground-truth的平均誤差;2)大于1像素誤差,即誤差大于1個深度像素的比例;3)大于3像素誤差。定量結果如圖4所示。

圖 4 模型訓練過程中驗證集上的深度圖誤差。使用BlendedMVS資料集(紅線)訓練的模型在DTU和ETH3D驗證集上都表現出良好的泛化性能。

3.2. 點雲評測

除了深度圖評測之外,作者還比較了在DTU、ETH3D、MegaDepth和BlendedMVS資料集訓練的模型在Tanks and Temples訓練集上的點雲重建效果。點雲評測包括三個評價名額,即精度(accuracy)、召回率(completeness)和整體來衡量重建品質。如表5所示,在DTU和MegaDepth資料集上訓練的模型取得了接近的分數,而在BlendedMVS資料集上訓練的模型在所有場景上都優于其他三個資料集上訓練的模型。将訓練資料從DTU改為BlendedMVS,從47.5%提高到53.2%.深度圖的可視化比較如圖6所示。

圖 5 Tanks and Temples資料上的點雲評測,在BlendedMVS資料上訓練的模型在所有場景上性能優于在其他資料集上訓練的模型。

圖 6 深度圖重建的可視化比較,與其他三個資料集相比,使用BlendedMVS資料集訓練的模型預測的深度圖結果更清晰。

結論: