作者:王遠東 ,重慶芝諾大資料分析有限公司大資料開發工程師。

提前說明一下,大資料的搭建環境都是在Linux系統下建構,可能針對一些沒有Linux程式設計基礎的同學來說會有一些吃力,請各位客官放心,小店夥計後期會專門有幾期來講解Linux程式設計基礎。絕對保證零基礎完成大資料環境的建構。今天大資料環境建構後會暫停其他元件(hue、flume、kafka、oozie等)的建構,後面的文章就是基于該環境講解大資料的應用。

一

安裝zookeeper

參考:大資料開發Hadoop分布式叢集環境建構(1)

二

安裝spark

2.1

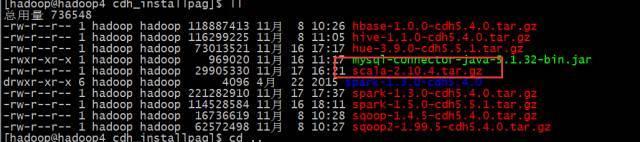

軟體準備

軟體下載下傳位址:

連結:https://pan.baidu.com/s/1boQn4y7 密碼:042h

2.2

安裝scala

spark的底層是基于scala語言編寫,對于spark的計算程式也可以通過scala語言來編寫。

并解壓scala:

tar -zxvf scala-2.10.4.tar.gz

2.3

spark安裝配置

下載下傳spark安裝包

并解壓:tar -zxvf spark-1.5.0-cdh5.5.1.tar.gz

配置spark-env.sh

内容如下:

export SPARK_CLASSPATH=/home/hadoop/hadoop/etc/hadoop:/home/hadoop/hadoop/share/hadoop/common/lib/*:/home/hadoop/hadoop/share/hadoop/common/*:/home/hadoop/hadoop/share/hadoop/hdfs:/home/hadoop/hadoop/share/hadoop/hdfs/lib/*:/home/hadoop/hadoop/share/hadoop/hdfs/*:/home/hadoop/hadoop/share/hadoop/yarn/lib/*:/home/hadoop/hadoop/share/hadoop/yarn/*:/home/hadoop/hadoop/share/hadoop/tools/lib/*:/home/hadoop/hadoop/share/hadoop/mapreduce/lib/*:/home/hadoop/hadoop/share/hadoop/mapreduce/*:/contrib/capacity-scheduler/*.jar

export SPARK_DAEMON_JAVA_OPTS="-Dspark.deploy.recoveryMode=ZOOKEEPER -Dspark.deploy.zookeeper.url=hadoop3:2181,hadoop4:2181,hadoop5:2181 -Dspark.deploy.zookeeper.dir=/spark"

export SCALA_HOME=/home/hadoop/scala

export JAVA_HOME=/home/hadoop/jdk

export HADOOP_HOME=/home/hadoop/hadoop

配置slaves

2.4

啟動叢集

./start-all.sh

結果

因為采用的是HA模式

就需要在備用機子上啟動master

至此spark HA叢集就搭建成功了

三

測試

./spark-shell

例子:

統計文字的長度

代碼:

val lines = sc.textFile("hdfs://mycluster/user/hive/warehouse/lijietest/hive_test.txt")

val lineLengths = lines.map(s => s.length)

val totalLength = lineLengths.reduce((a, b) => a + b)

運作結果:

後面會不定期的更新有關大資料、雲計算、資料挖掘等方面的知識點,歡迎大家持續關注。如果對該知識點有疑問,歡迎在留言區留言讨論。