摘要:本文提出一種基于局部特征保留的圖卷積網絡架構,與最新的對比算法相比,該方法在多個資料集上的圖分類性能得到大幅度提升,泛化性能也得到了改善。

本文分享自華為雲社群《論文解讀:基于局部特征保留的圖卷積神經網絡架構(LPD-GCN)》,原文作者:PG13 。

近些年,很多研究者開發了許多基于圖卷積網絡的方法用于圖級表示學習和分類應用。但是,目前的圖卷積網絡方法無法有效地保留圖的局部資訊,這對于圖分類任務尤其嚴重,因為圖分類目标是根據其學習的圖級表示來區分不同的圖結構。為了解決該問題,這篇文章提出了一種基于局部特征保留的圖卷積網絡架構[1]。與最新的對比算法相比,該方法在多個資料集上的圖分類性能得到大幅度提升,泛化性能也得到了改善。

1、引言

圖(網絡)結構資料可以通過圖中的節點和連接配接節點之間的邊進行模組化來捕獲實體和實體之間的豐富資訊。圖結構資料已經在諸多研究領域得到了廣泛的應用,包括生物學(蛋白質與蛋白質的互相作用網絡)、化學(分子結構/化合物結構)、社會科學(社交網絡/文獻引用網絡)和許多其他的研究領域。圖結構資料不僅能夠對結構化資訊進行高效存儲,而且在現代機器學習任務中也扮演着極其重要的角色。在諸多的機器學習任務中,圖分類是近幾年來廣泛研究的一項重要任務。圖分類的目的是将給定的圖劃分到特定的類别。例如,為了區分化學中有機分子的各種圖結構,需要對其推斷并聚合整個圖拓撲結構(在分子網絡中拓撲結構由單個原子及其直接鍵組成)以及節點特征(例如原子屬性),并使用推斷和聚合的資訊來預測圖的類别。

近年來,國際上發表了很多旨在解決圖分類問題的技術。一種傳統且流行的技術是設計一個圖核函數來計算圖與圖之間的相似度,然後輸入到基于核函數的分類器(如SVM)來進行圖分類任務。盡管基于圖核的方法是有效的,但存在計算瓶頸,而且其特征選擇的過程與後續分類過程是分開的。為了解決上述挑戰,端到端的圖神經網絡方法受到了越來越多的研究關注。而其中,圖卷積神經網絡(GCNs)又是解決圖分類問題的最熱門的一類圖神經網絡方法。

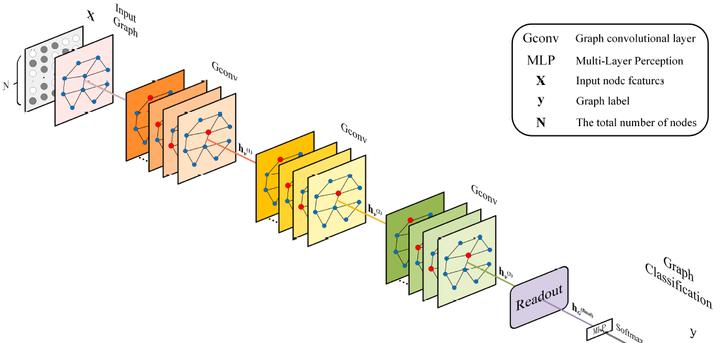

目前的圖卷積神經網絡大緻遵循消息傳遞(Message Passing Neural Network,MPNN)架構[2]。該架構由消息傳遞階段和讀出階段兩部分組成,其中消息傳遞階段是通過聚集節點的鄰域特征來更新每個節點的特征向量,而讀出階段是通過全局的池化子產品來生成整個圖級的特征。圖卷積神經網絡使用消息傳遞功能來疊代地運作圖卷積操作,使得特征資訊能夠傳播很長的距離,進而可以學習不同範圍的鄰域特征。在經過k次的圖卷積操作後,可以提取有用的節點或者邊的特征來解決許多基于節點和邊的分析任務(例如,節點分類,鍊路預測等)。為了解決圖級的任務(例如圖分類),讀出子產品需要聚合全體的節點或局部結構的資訊來生成圖級表示。下圖給出了用于圖分類任務的圖卷積神經網絡的通用架構。在現有的消息傳遞架構基礎下,很多的研究者已經開發出了具有各種消息傳遞函數,節點更新函數和讀出子產品的許多圖卷積神經網絡的變體。

但是,現有的基于圖卷積神經網絡方法的主要局限性在于,用于圖級表示學習的圖卷積神經網絡方法缺乏對局部特征資訊的有效利用。換句話說,它們過分強調區分不同圖結構的能力,而忽略了節點的局部表達能力,進而容易導緻過度平滑的問題(每個節點的特征表示趨于一緻),特别是當加深神經網絡的層數時,過平滑問題會愈趨嚴重。這是因為在局部鄰域聚合過程中沒有對鄰域的特征資訊進行有效地區分和辨識,使得學到的節點特征的局部表達能力不強,再加上過平滑的影響,進而大大限制了全局的圖級特征的表示能力。

衆所周知,圖級表示是通過聚集節點的局部特征而得到的,是以如何在優化的過程中保持局部表達能力是提高圖表示能力的關鍵前提。針對圖級表示學習目标,現有的用于保持特征局部表達能力的研究方法可以大緻分為三個派系:(1)設計不同的圖卷積操作和讀出操作,(2)設計分層聚類方法,(3)探索新的模型架構。在第一個派系中,Xu等人發現基于現有消息傳遞架構下的方法學習到的圖級别表示并不能有效地區分不同的圖結構,并且他們提出了一個圖同構網絡模型(GIN)[3]。圖同構網絡采用了一種單射聚合更新方法将不同的節點鄰居映射到不同的特征向量。這樣就能保留圖的局部結構和節點特征,使得圖神經網絡和Weisfeiler-Lehman測試一樣有效。Fan等人提出了一種類似于圖注意力網絡(GATs)[4]的結構化自注意力架構,用于圖級表示學習,其中以節點為中心的注意力機制将具有可學習權重的不同鄰居節點特征聚合在一起,并将層級注意力機制和圖級注意力機制作為模型的讀出子產品,可将來自不同節點、不同深度的重要特征聚合到模型的輸出中。在第二個派系中,也就是在層次聚類方法中,許多研究工作證明圖除了節點或圖級結構之間的二分法外,還顯示出其它豐富的層次結構。比如最近的一項前沿工作提出了DIFFPOOL[5],這是一種能夠與圖卷積聯合訓練的可微分階層化池化方法,可以用于提煉局部特征資訊。

總而言之,上述兩類用于圖分類任務的方法能夠很好地拟合大多數訓練資料集,但是其泛化能力非常有限,在測試集上的效果表現平平,難以突破現有方法的瓶頸。而在第三類派系中,也就是研究新的模型架構,一些研究人員試圖解決在訓練圖卷積神經網絡的存在的實際困難或者過度平滑問題。例如,Xu等人[6]提出了一種跳躍知識網絡(JK-Net)架構,以将網絡的最後的圖卷積層與所有先前的隐藏層連接配接起來,也就是類似于殘差網絡的結構。通過這樣的設計,使得模型最後的層可以有選擇性地利用來自前面不同層的鄰域資訊,進而可以在固定數量的圖卷積操作中很好地捕獲節點級表示。尤其是随着網絡深度的增加,殘差連接配接對模型的效果提升更加凸顯。這種跳躍結構已經被證明可以顯著提高模型在以節點相關任務上的性能,但是很少有研究人員探索它們在圖級任務上(如圖分類)的有效性。在GIN 中,Xu等人進一步提出了一種類似于JK-Net的模型架構用于學習圖級表示。該架構針對每個卷積層後面都連接配接了一個讀出層來學習不同深度的圖級表示,然後将不同深度的圖級表示形式連接配接在一起形成最終的表示。這種讀出架構考慮了所有深度的全局資訊,可以有效地改善模型的泛化能力。

2、圖卷積神經網絡(GCN)

(1)問題定義

給定一個無向圖G = { V, E},V表示節點集合,E 表示邊的集合。此外,使用Xv來表示每個節點的初始特征。圖卷積神經網絡的目标是學習任意圖執行個體的連續表示,來對節點特征以及拓撲結構進行編碼。假設給定了一組帶有M個标簽的圖G = {G1, G2, ... ,GM}以及每一個圖對應的标簽Y = {y1, y2, ... ,yM},圖分類的目标是使用它們作為訓練資料來建構分類器gθ,該分類器可以将任何新的圖輸入G配置設定給某個特定的類别yG,即yG = gθ(hG)。

(2)圖卷積神經網絡

GCNs同時考慮圖的結構資訊和圖中每個節點的特征資訊,以學習可以最好地幫助完成最終任務的節點級和/或圖級特征表示。通常來說,現有的GCN變體首先會聚

合鄰域資訊,然後将生成的鄰域表示與上一次疊代的中心節點表示進行組合。從公式上來說,GCN根據以下公式疊代地更新節點的表示形式:

其中

表示的是節點v在第k次疊代時的特征表示。AGGREGATE()和COMBINE()都是第k 個圖卷積層的可學習資訊傳遞函數。N(v)表示節點v的相鄰節點的集合。通常,在K次疊代步驟之後,可以将最終的節點表示

應用于節點标簽預測,或者前進到執行圖分類的讀出階段。讀出階段通過聚合節點特征,使用某些特定的讀出函數READOUT()為整個圖計算特征向量hG:

READOUT()函數可以是簡單的置換不變性函數,例如求和函數;也可以是圖級的池化操作,如DIFFPOOL、SORTPOOL。

3、方法介紹

為了解決現有方法的局部資訊保留能力和泛化能力不足的問題,這篇文章從損失函數和模型架構兩個方面進行了改進,提出了模型LPD-GCN。衆所周知,GCNs通過利用圖的拓撲結構和節點特征來學習整個圖的圖級表示。從損失的角度來看,為了充分利用和學習節點的特征資訊,LPD-GCN構造了額外的局部節點特征重構任務,以提高隐藏節點表示的局部表示能力并增強最終圖級表示的判别能力。也就是額外增加了一個輔助限制來保留圖的局部資訊。這個節點特征重構任務是通過設計一種簡單但有效的編碼-解碼機制來實作的,其中将堆疊的多個圖卷積層當作編碼器,然後添加一個多層感覺器(MLP)用于後續的解碼。這樣的話,就可以将輸入的節點特征通過編碼器嵌入到隐藏表示中,然後将這些向量表示再輸入到解碼器中以重構初始節點特征。從模型架構的角度來看,首先探索并設計了一個稠密連接配接的圖卷積架構來建立不同層之間的連接配接關系,以靈活充分地利用來自不同位置的鄰域的資訊。具體地說,将每個卷積層及其對應的讀出子產品與所有先前的卷積層相連。

(1)基于編碼-解碼機制的節點特征重構

傳統GCN的圖級表示能力和判别能力受限于過度精煉和全局化,忽視了對局部特征的儲存,這會導緻過平滑問題。LPD-GCN包含一個用于實作局部特征重構的簡單的編碼-解碼機制,其中編碼器由堆疊的多圖卷積層構成,而解碼器采用多層感覺器來重構局部節點特征。同時,構造了一個輔助的局部特征重構損失來輔助圖分類的目标。這樣的話,節點特征可以有效地保留在不同層上的隐藏表示中。

(2)基于DenseNet的鄰域聚合

此外,為了可以靈活地利用來自不同層的鄰域的資訊,模型從每個隐藏的卷積層到所有更高層的卷積層和讀出子產品都添加了直接的連接配接。這樣的架構大緻是DenseNets的對應結構。衆所周知,DenseNets是針對計算機視覺問題提出的。該架構允許在不同層選擇性地聚合鄰域資訊,并進一步改善層與層之間的資訊流動。在DenseNets中應用的是分層串聯的特征聚合方式。LPD-GCN采用分層累加的特征聚合方式。

(3)基于全局資訊感覺的局部節點表示

引入輔助的局部特征重構子產品後,使得每個卷積層都可以接受額外的監督,以保持局部性。但是,此類監督資訊無法通過反向傳播來訓練這些全局讀出子產品。在本章模型的架構中,在每個卷積層後面都有一個對應全局讀出子產品,來将整個圖的節點嵌入折疊為圖級别的表示。那麼,如何才能更好地利用來自局部特征重構的監督資訊呢?為了解決這個問題,添加了從每個讀出子產品到下一層卷積子產品的直接連接配接,并使用串聯的方式将節點級特征與全局圖級特征進行對齊。也就是說,使用逐點串聯,将每個節點表示和圖級表示連接配接到單個張量中。此外,又引入了一個可學習的參數ε(> 0),以自适應地在局部節點級表示和全局圖級表示之間進行權衡。

通過設計這樣的架構,除了因失去主圖級任務而産生的梯度資訊之外,還可因局部特征重構損失而使其他梯度資訊反向傳播以更新讀出的參數,進而降低了喪失局部表示能力的風險并提高了模型的泛化能力。同時,節點表示與附加的全局上下文相結合以形成全局上下文感覺的局部表示,這也可以增強節點的表示性。

(4)基于自注意力機制的全局分層聚合

現有的大部分方法是将多個圖卷積層學習的節點表示饋送到全局讀出子產品以生成圖級表示,讀出子產品通過池化或求和的方式生成全局的圖級特征。但是,随着網絡深度的增加,節點表示可能會顯得過于平滑,進而導緻圖級輸出的綜合性能較差。為了有效地提取和利用所有深度的全局資訊,本章的模型進一步采用了一種自注意力機制,以類似于GIN的方式來讀出的逐層圖級特征。這裡引入以層為中心的自注意力機制的直覺是,在生成特定任務的圖級輸出時,配置設定給每一層不同的注意力權重可以适應于特定的任務。

(5)損失函數

在訓練階段,本章的模型LPD-GCN從圖分類主任務和輔助的局部特征重構限制接收梯度資訊。從公式上來說,通過如下公式中定義的總損失(由圖分類損

失和局部特征重構損失權重得到)來訓練LPD-GCN。

其中表示

圖分類損失,

表示局部特征重構損失,權衡參數被自适應地引入在兩個損失項之間尋求平衡。

4、圖分類實驗結果

(1)測試資料集

這篇文章使用了圖神經網絡領域8個常用的圖資料集,通過執行10倍交叉驗證來評估性能,并報告測試準确度的均值和标準差。

(2)在測試集上的效果

在多個資料集上的分類性能上有了明顯的提升,且泛化能力得到了改善。

5、參考文獻

[1] WENFENG LIU, MAOGUO GONG, ZEDONG TANG A. K. QIN. Locality Preserving Dense Graph Convolutional Networks with Graph Context-Aware Node Representations. https://arxiv.org/abs/2010.05404

[2] GILMER J, SCHOENHOLZ S S, RILEY P F, et al. Neural message passing for quantum chemistry[C] // Proceedings of the 34th International Conference on Machine Learning : Vol 70. 2017 : 1263 – 1272.

[3] XU K, HU W, LESKOVEC J, et al. How powerful are graph neural networks?[C] // Proceedings of the 7th International Conference on Learning Representations. 2019.

[4] VELI ˇ CKOVI´C P, CUCURULL G, CASANOVA A, et al. Graph attention networks[C] // Proceedings of the 6th International Conference on Learning Representations. 2018.

[5] YING Z, YOU J, MORRIS C, et al. Hierarchical graph representation learning with differentiable pooling[C] // Advances in Neural Information Processing Systems. 2018 : 4800 – 4810.

[6] XU K, LI C, TIAN Y, et al. Representation learning on graphs with jumping knowledge networks[C] // Proceeding of the 35th International Conference on Machine Learning. 2018 : 5449 – 5458.

點選關注,第一時間了解華為雲新鮮技術~