對CSV檔案進行預處理生成無标題文本檔案,将爬蟲大作業産生的csv檔案上傳到HDFS

首先,我們需要在本地中建立一個/usr/local/bigdatacase/dataset檔案夾,具體的步驟為:

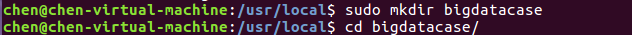

① cd /usr/local

② sudo mkdir bigdatacase

③ cd bigdatacase/

④ sudo mkdir dataset

⑤ cd dataset/

如下圖所示:

其次,我們把lagoupy.csv檔案放到下載下傳這個檔案夾中,并使用指令把lagoupy.csv檔案拷貝到我們剛剛所建立的檔案夾中,具體步驟如下:

① sudo cp /home/chen/下載下傳/lagoupy.csv /usr/local/bigdatacase/dataset/ #把lagoupy.csv檔案拷到剛剛所建立的檔案夾中

② head -5 small_test.csv #檢視這個檔案的前五行

對CSV檔案進行預處理生成無标題文本檔案,步驟如下:

① sudo sed -i '1d' lagoupy.csv #删除第一行記錄

② head -5 small_test.csv #檢視前五行記錄

接着,啟動hadoop,步驟如下:

① start-all.sh #啟動hadoop

② jps #檢視hadoop是否啟動成功

最後,我們把本地的檔案上傳至HDFS中,步驟如下:

① hdfs dfs -mkdir -p /bigdatacase/dataset #在hdfs上建立/bigdatacase/dataset

② hdfs dfs -ls /

③ hdfs dfs -put ./lagoupy.csv /bigdatacase/dataset #把本地檔案small_test.csv上傳至hdfs中

④ hdfs dfs -ls /bigdatacase/dataset #檢視

⑤ hdfs dfs -cat /bigdatacase/dataset/small_test.csv | head -5 #檢視hdfs中small_test.csv的前五行

把hdfs中的文本檔案最終導入到資料倉庫Hive中

首先,啟動hive,步驟如下:

① service mysql start #啟動mysql資料庫

② cd /usr/local/hive

③ ./bin/hive #啟動hive

① create database db; -- 建立資料庫dbpy

② use db;

③ create external table labling

④ select * from labling limit 10; -- 檢視lagou_py中前10行的資料

查詢條數統計分析

用聚合函數count()計算出表内有多少條行資料 hive> select count(*) from labling;

美國國籍的球員數:

美國國籍的球員:

查詢老鷹的球員:

查詢老鷹的球員數:

查詢球員2015年以後進入NBA的人數:

查詢2015年以後進入NBA球員的名字