(1)深度殘差網絡的回顧

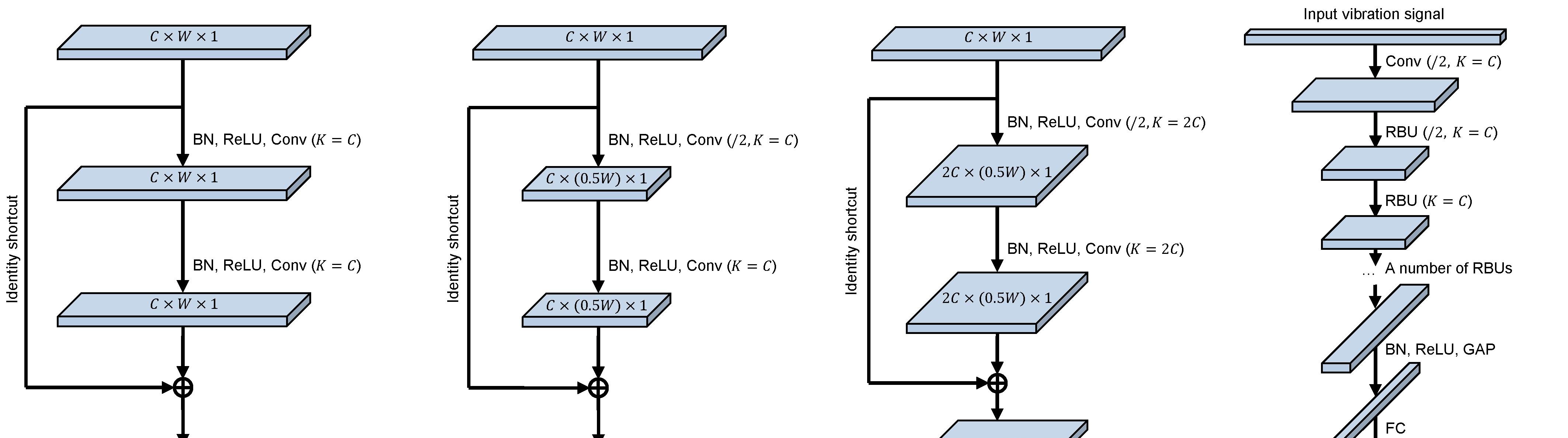

在下圖中,(a)-(c)分别是三種殘差子產品,(d)是深度殘差網絡的整體示意圖。BN指的是批标準化(Batch Normalization),ReLU指的是整流線性單元激活函數(Rectifier Linear Unit),Conv指的是卷積層(Convolutional layer),Identity shortcut指的是跨層的恒等映射,RBU指的是殘差子產品(Residual Building Unit),GAP是全局均值池化(Global Average Pooling),FC是全連接配接層(Fully Connected Layer)。

C表示特征圖的通道數,W表示特征圖的寬度,1表示特征圖的高度始終為1(這是因為這篇文章以一維的振動信号作為輸入)。

在Conv後的括号中,K表示卷積層中卷積核的個數。當K=C時,輸出特征圖的通道數為C。當K=2C時,輸出特征圖的通道數為2C。/2表示的是卷積核每次移動的步長為2,進而使得輸出特征圖的寬度減半。

我們可以看到,在圖(a)中,輸入特征圖的尺寸為C×W×1,輸出特征圖的尺寸也是C×W×1,也就是說,特征圖的尺寸保持不變。在圖(b)中,輸出特征圖的尺寸減小為C×(0.5W)×1,換言之,寬度減小為原先的一半。在圖(c)中,輸出特征圖的尺寸變為2C×(0.5W)×1,即不僅寬度減小為原先的一半,而且通道數增加了一倍。

(2)深度殘差收縮網絡的網絡結構

在該論文中,提出了兩種深度殘差收縮網絡(Deep Residual Shrinkage Networks,簡稱DRSN)。第一種是“通道之間共享門檻值的深度殘差收縮網絡(Deep Residual Shrinkage Networks with Channel-shared Thresholds,簡稱DRSN-CS)”,第二種是“逐通道不同門檻值的深度殘差收縮網絡(Deep Residual Shrinkage Networks with Channel-wise Thresholds,簡稱DRSN-CW)”。

在下圖中,(a)表示一種改進後的殘差子產品,名為“殘差收縮子產品-通道之間共享門檻值(Residual Shrinkage Building Unit with Channel-shared thresholds,簡稱RSBU-CS)”;(b)表示的是DRSN-CS的整體結構示意圖;(c)表示另一種改進後的殘差子產品,名為“殘差收縮子產品-逐通道不同門檻值(Residual Shrinkage Building Unit with Channel-wise thresholds,簡稱RSBU-CW)”;(d)表示的是DRSN-CW的整體結構示意圖。

其中,M表示的是全連接配接層神經元的個數。M=C表示神經元的個數與之前特征圖的通道數相等,M=1表示神經元的個數為1。Absolute表示對特征圖中的每個元素取絕對值,Average表示求特征圖内所有元素的平均值。

可以看出,深度殘差收縮網絡的整體結構,和傳統的深度殘差網絡,沒有差別。其差別在于殘差子產品的不同。在改進後的殘差子產品中,不僅有一個軟門檻值化函數作為非線性層,而且嵌入了一個子網絡,用于自動地設定軟門檻值化所需要的門檻值。

轉載網址:

深度殘差收縮網絡:(一)背景知識

https://www.cnblogs.com/yc-9527/p/11598844.html深度殘差收縮網絡:(二)整體思路

https://www.cnblogs.com/yc-9527/p/11601322.html深度殘差收縮網絡:(三)網絡結構

https://www.cnblogs.com/yc-9527/p/11603320.html深度殘差收縮網絡:(四)注意力機制下的門檻值設定

https://www.cnblogs.com/yc-9527/p/11604082.html深度殘差收縮網絡:(五)實驗驗證

https://www.cnblogs.com/yc-9527/p/11610073.html論文網址:

M. Zhao, S. Zhong, X. Fu, B. Tang, and M. Pecht, “Deep Residual Shrinkage Networks for Fault Diagnosis,” IEEE Transactions on Industrial Informatics, 2019, DOI: 10.1109/TII.2019.2943898

https://ieeexplore.ieee.org/document/8850096