Hanlp作為一款重要的中文分詞工具,在GitHub的使用者量已經非常之高,應該可以看得出來大家對于hanlp這款分詞工具還是很認可的。本篇繼續分享一篇關于hanlp的使用執行個體即Python調用hanlp進行中文實體識别。

想要在python中調用hanlp進行中文實體識别,Ubuntu 16.04的系統環境

1.安裝jpype1,在cmd視窗輸入

pip install jpype1

2.下載下傳hanlp的安裝包

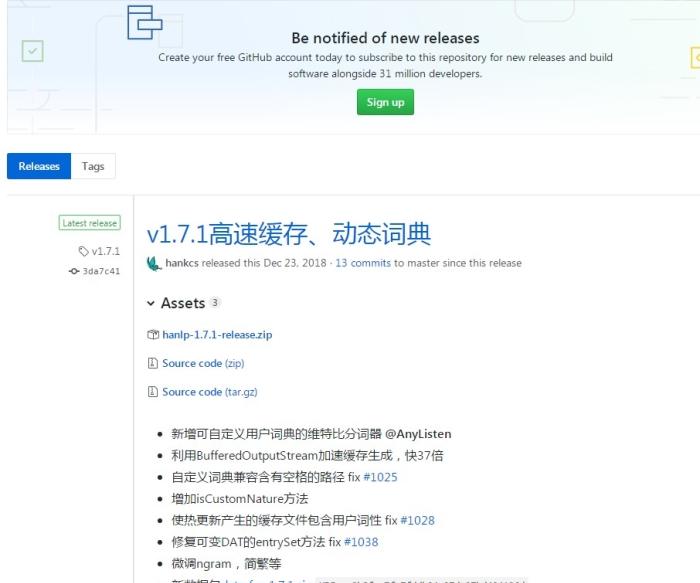

在github.com/hankcs/HanLP/releases

(1)下載下傳新的 hanlp-1.7.1-release.zip檔案,裡面包含hanlp-1.7.1.jar , hanlp-1.7.1-sources.jar , hanlp.properties

(2)點選data-for-1.7.1.zip下載下傳。(底下第8條)

注:如果你在hanlp.linrunsoft.com/services.html點選下載下傳hanlp.jar,下載下傳下來的是hanlp-1.2.8.jar。之後在使用過程中可能會出現“字元類型對應表加載失敗”的錯誤,檢視相應路徑下也沒有CharType.dat.yes檔案。原因可能是hanlp-1.2.8版本過低,使用新版本應該不會出現這個問題。

3.建立一個檔案夾Hanlp,放檔案hanlp-1.7.1.jar和hanlp.properties檔案

建立一個檔案夾hanlp,放data-for-1.7.1.zip解壓後的檔案

配置hanlp.properties中的第一行的root為hanlp檔案夾的位置,也就是data-for-1.7.1.zip解壓後的檔案放的位置。

4.寫py檔案調用hanlp進行中文分析。

用法可參考這個部落格 blog.csdn.net/u011961856/article/details/77167546。

另,檢視HanLP關于實體識别的文檔hanlp.linrunsoft.com/doc.html

裡面介紹說中文人名标注為“nr”,地名标注為“ns”,機構名标注為“nt”,是以使用用法參考連結裡的NLPTokenizer.segment就可以标注出中文句子中的人名,地名和機構名。

比較使用jieba進行詞性标注時,也可以标注出中文句子中的人名,地名和機構名。jieba分詞的詞性說明: