【Hadoop】

1.首先,準備好Hadoop安裝包和JDK的安裝與配置

2.建立各個機器之間的ssh信任關系,即互信

3.修改hadoop配置檔案

【core、hdfs、yarn、mapred】

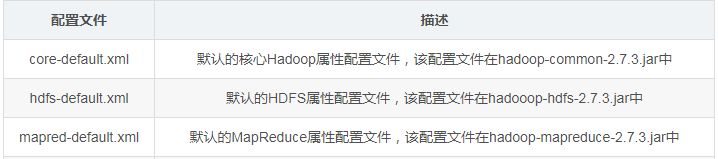

預設配置檔案:core-default.xml、hdfs-default.xml、mapred-default.xml、yarn-default.xml

特定配置檔案:core-site.xml、hdfs-site.xml、mapred-site.xml、yarn-site.xml

特定配置檔案會覆寫預設的配置項

【core-site.xml】

是整個Hadoop通用的配置,叢集的每個主機都存在。

分布式檔案系統名字、臨時目錄以及其他與網絡配置相關的參數

【hdfs-site.xml】

配置HDFS系統的運作時屬性和各個資料節點上檔案的實體存儲相關的屬性

主-輔節點存放中繼資料檔案表(fsimage檔案)的目錄

主-輔節點存儲中繼資料事務處理檔案(edits檔案)的目錄

預設資料塊大小

資料塊備份數量

名稱節點和資料節點通信的伺服器線程數,預設為10

【mapred-site.xml】

保護了與CPU、記憶體、磁盤I/O和網絡相關的參數

任務是本地作業執行器還是送出到yarn叢集

運作Map或Reduce任務的JVM堆大小

運作Map和Reduce任務的容器的記憶體大小

存儲中間資料檔案的本地目錄

作業跟蹤器(YARN)的伺服器程序數量

任務重試的最大次數

【yarn-site.xml】

配置由YARN架構提供的通用服務守護程序的屬性,比如資料總管和節點管理器

運作資料總管的主機名以及端口号

啟動容器的最大最小記憶體量和虛拟CPU核心數

【Spark】

在有JDK和Hadoop的基礎上,安裝Scala

修改配置檔案

【spark屬性、環境變量、日志配置】

屬性可以直接在sparkconf上配置給sparkcontext

spark shell和spark-submit工具支援兩種方式動态加載配置,第一種是指令行選項,第二種運作./bin/spark-submit實作

當然spark-submit也會在conf/spark-defaults.conf中讀取配置選項

driver程式運作時需要的cpu核心數和記憶體數

每個executor程序使用的記憶體數