繼上一篇kvm虛拟化管理平台WebVirtMgr部署-完整記錄(1),接下來說說WebVirtMgr的日常配置:添加主控端,建立虛機,磁盤擴容,快照等

具體操作記錄如下:

一、配置主控端

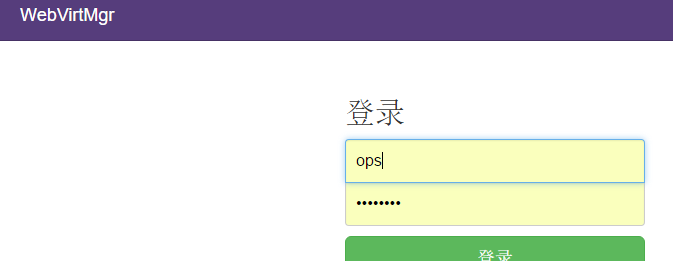

1、登入WebVirtMgr管理平台

2、添加主控端

選擇首頁的WebVirtMgr -->Addd Connection

選擇“TCP連結“,設定Label,IP,使用者,密碼

注意:Label與IP要相同

二、虛機部署

1、建立存儲池

點選前面建立的主控端,進入虛拟機部署界面

點選“存儲池”按鈕,建立存儲池(即建立磁盤鏡像存放的位置)

注意:

建立存儲池時,首先要在主控端上建立一個目錄,然後在”路徑“設定欄中添加該目錄

例:mkdir /home/kvm/kvmstorage -p

[把提前下載下傳好的centos鏡像拷貝到上面建立的存儲池目錄/home/kvm/kvmstorage下;這裡可以放不同版本的系統鏡像(windows也可以),以便在下面安裝過程中選擇不同鏡像安裝系統]

下面“Metadata”前的小方框一定不能勾選(預設是勾選的,要去掉!)

這裡添加的“鏡像”就是所建立虛拟機的硬碟空間(我測試環境給了150G)

虛拟機所占用的空間就是這個“鏡像”所在的主控端下路徑所在的分區空間(也就是/home/kvm/kvmstorage/,即主控端的home分區)

注意下面的“裝置”一項要填寫橋接的實體網卡(即br0對應的那個網卡,這裡填的是主控端之前的内網卡em3)

網關位址也一定要填寫正确,不然虛拟機和主控端同網段機器則會網絡不通。(如下這一步其實就是建立橋接的網卡配置,也可以在伺服器上手動建立)

7、啟動虛機

點選“啟動”按鈕後,打開虛機電源。

8、虛機IP位址設定

當虛機安裝完成後,登陸虛拟機,給虛機設定靜态IP位址

[root@vmserver001~]# cd /etc/sysconfig/network-scripts/

[root@localhost network-scripts]# cat ifcfg-eth0

DEVICE=eth0

HWADDR=52:54:00:8C:6A:E1

TYPE=Ethernet

UUID=4f57c69c-a0f3-44e2-b75e-c37eb130f5b1

ONBOOT=yes

NM_CONTROLLED=no #讓eth0不受networkmanager的控制

BOOTPROTO=static

IPADDR=192.168.1.99

NETMASK=255.255.255.0

GATEWAY=192.168.1.1

---------------------------------------------------溫馨提示-----------------------------------------

以上的做法裡虛拟機配置的都是私網ip位址(主控端要有私網網關位址),通過橋接模式上網。

如果主控端上有公網網關位址的話,完全可以将虛拟機配置成公網ip,這樣虛拟機就可以正常聯網。

比如主控端的ip位址是110.117.18.19,公網網關位址是110.117.18.1

那麼需要将上面操作中所有192.168.1.17的配置改成110.117.18.19。

并且需要将110.117.18.19所在的公網網卡做成br0.

這樣虛拟機的配置如下:

[root@vmserver001~]# cat /etc/sysconfig/network-scripts/ifcfg-eth0

DEVICE=eth0

HWADDR=52:54:00:AF:F3:84

TYPE=Ethernet

UUID=cd66dc1e-60ae-43a0-b252-1244ad92dce7

ONBOOT=yes

NM_CONTROLLED=no

BOOTPROTO=static

IPADDR=110.117.18.30

NETMASK=255.255.255.192 //跟主控端的NETMASK配置一樣

GATEWAY=110.117.18.1 //跟主控端的GATEWAY配置一樣

[root@vmserver001~]# /etc/init.d/network restart

[root@vmserver001~]# cat /etc/resolv.conf

nameserver 8.8.8.8

nameserver 8.8.4.4

[root@vmserver001~]# ping www.baidu.com

PING www.a.shifen.com (220.181.111.188) 56(84) bytes of data.

64 bytes from 220.181.111.188: icmp_seq=1 ttl=55 time=1.65 ms

64 bytes from 220.181.111.188: icmp_seq=2 ttl=55 time=1.40 ms

64 bytes from 220.181.111.188: icmp_seq=3 ttl=55 time=1.53 ms --------------------------------------------------------------------------------------------------------------

如何删除之前建立的存儲池kvm01?

操作記錄如下:

[root@openstack qemu]# virsh pool-list --all

Name State Autostart

-----------------------------------------

kvm01 active yes

vm1 active yes

首先取消存儲池kvm01的激活

[root@openstack qemu]# virsh pool-destroy kvm01

Pool kvm01 destroyed

然後登陸webvirtmgr界面,在“存儲池”裡找到“kvm01”,先停止,再删除。

再次檢視,就删除了存儲池kvm01了

vm1 active yes

三、webvirtmgr克隆虛機操作

1、關閉正在運作的虛機

2、進入虛機配置界面,在克隆配置項,為新的虛機的“名字”,“MAC位址”,“磁盤鏡像”進行設定

==================================================================================

或者:(和上面的克隆效果是一樣的)

直接克隆之前所建立虛拟機鏡像(這個虛拟機必須是已經建立了的),然後用這個新克隆的鏡像去建立新的虛拟機,這也是克隆虛拟機做法。

然後建立虛拟機,建立中選用上面新克隆的硬碟鏡像

---------------------------------------------------------------------------------------------------

3、webvirtmgr界面裡啟動克隆的新虛拟機,vnc進入系統,對/etc/udev/rules.d/70-persistent-net.rules 檔案做如下修改

修改後

4、編輯/etc/sysconfig/network-scripts/ifcfg-eth0 修改虛機的網卡配置,為虛機配置設定新的IP位址

5、重新開機系統 使網卡重新注冊,讓配置生效

#reboot

--------------------------------------------------------------------------------------------

以上是centos系統的虛拟機克隆後的做法,如果克隆的虛拟機是ubuntu系統,

那麼會發現沒有這個/etc/udev/rules.d/70-persistent-net.rules檔案

這時隻需要修改克隆後的ubuntu虛拟機的ip,然後重新開機網卡,最後reboot機器即可。

四、webvirtmgr虛機磁盤擴容(新增磁盤)

1 關閉虛機

2 對虛機的xml檔案的disk域添加如下代碼:

場景一:新增一塊磁盤

<disk type='file' device='disk'>

<driver name='qemu' type='qcow2' cache='none'/> ---添加改行代碼找到新增磁盤格式

<source file='/home/kvm/teststorage/entd01.img'/> --指定新增磁盤路徑

<target dev='vda' bus='virtio'/> --指定磁盤裝置名稱,和傳輸總線類型

</disk>

場景二:新增多塊磁盤

已新增兩塊盤為例:

<disk type='file' device='disk'>

<driver name='qemu' type='qcow2' cache='none'/>

<source file='/home/kvm/teststorage/entd01.img'/>

<target dev='vda' bus='virtio'/>

</disk>

<disk type='file' device='disk'>

<source file='/home/kvm/vm/waq02-clone.qcow2'/>

<target dev='vdb' bus='virtio'/>

3 啟動虛機,然後在虛機系統内部對磁盤進行格式化,分區等操作。

五、Webvirtmgr虛拟機快照

1.首先需要将做快照的vm關機

2.到快照池裡建立快照

如果此虛拟機遇到故障,那麼就可以根據它的快照進行恢複了,快照恢複後,再次開機就ok了,就能恢複到快照制作時的機器狀态。

虛拟機記憶體和CPU擴容

要想對虛拟機的記憶體和CPU進行擴容,需要先關閉此虛拟機,然後在“設定”裡面重置,最後重新開機伺服器即可。

----------------------------------------------------------------------------------------------------

關閉和删除br0

[root@openstack ~]# virsh net-list

Name State Autostart Persistent

--------------------------------------------------

br0 active yes yes

[root@openstack ~]# virsh net-undefine br0

error: Failed to undefine network br0

error: Requested operation is not valid: network is still active

[root@openstack ~]# virsh net-destroy br0

Network br0 destroyed

記一次webvirtmgr中出現"Oops!500伺服器内部報錯“的處理過程,如下:

出現上面的報錯,是由于webvirtmgr伺服器上的不當操作或配置錯誤引起的(要從報錯出現後最近的操作着手排查),比如:

1)在利用克隆的磁盤鏡像建立新的虛拟機後,沒有來得及修改克隆後的虛拟機資訊就去通路webvirtmgr界面,于是就有這個報錯。

需要修改克隆後新虛拟機的配置資訊(上面已提到)後,再次通路就ok了。

2)在webvirtmgr通路頁面裡添加一個虛拟機後,再次通路也出現了這個報錯。原因是這個虛拟機沒有被正确建立。

解決辦法:登陸到伺服器發現這個建立失敗的虛拟機,然後強制删除即可!

[root@kvm-server ~]# virsh list

Id Name State

----------------------------------------------------

5 centos7-test5 running

6 centos7-test6 running

7 ubutun-test1 running

8 ubuntu-test2 running

9 ubuntu-test3 running

10 centos6-node1 running

11 centos6-node2 running

12 centos6-node3 running

13 centos7-test4 running

[root@kvm-server ~]# virsh list --all

Id Name State

----------------------------------------------------

5 centos7-test5 running

6 centos7-test6 running

7 ubutun-test1 running

8 ubuntu-test2 running

9 ubuntu-test3 running

10 centos6-node1 running

11 centos6-node2 running

12 centos6-node3 running

13 centos7-test4 running

- centos7-test1 shut off #就是這個虛拟機建立失敗,将其删除即可

解決辦法:

[root@kvm-server ~]# virsh undefine centos7-test1 #強制删除

Domain centos7-test1 has been undefined

[root@kvm-server ~]# virsh list --all

Id Name State

----------------------------------------------------

5 centos7-test5 running

6 centos7-test6 running

7 ubutun-test1 running

8 ubuntu-test2 running

9 ubuntu-test3 running

10 centos6-node1 running

11 centos6-node2 running

12 centos6-node3 running

13 centos7-test4 running *************** 當你發現自己的才華撐不起野心時,就請安靜下來學習吧!***************