機器之心報道

編輯:澤南、小舟

「深度神經網絡非常難以訓練,我們提出的殘差網絡架構使得神經網絡的訓練變得容易很多。」文章摘要的開頭如今已被無數研究者們細細讀過。

這是一篇計算機視覺領域的經典論文。李沐曾經說過,假設你在使用卷積神經網絡,有一半的可能性就是在使用 ResNet 或它的變種。

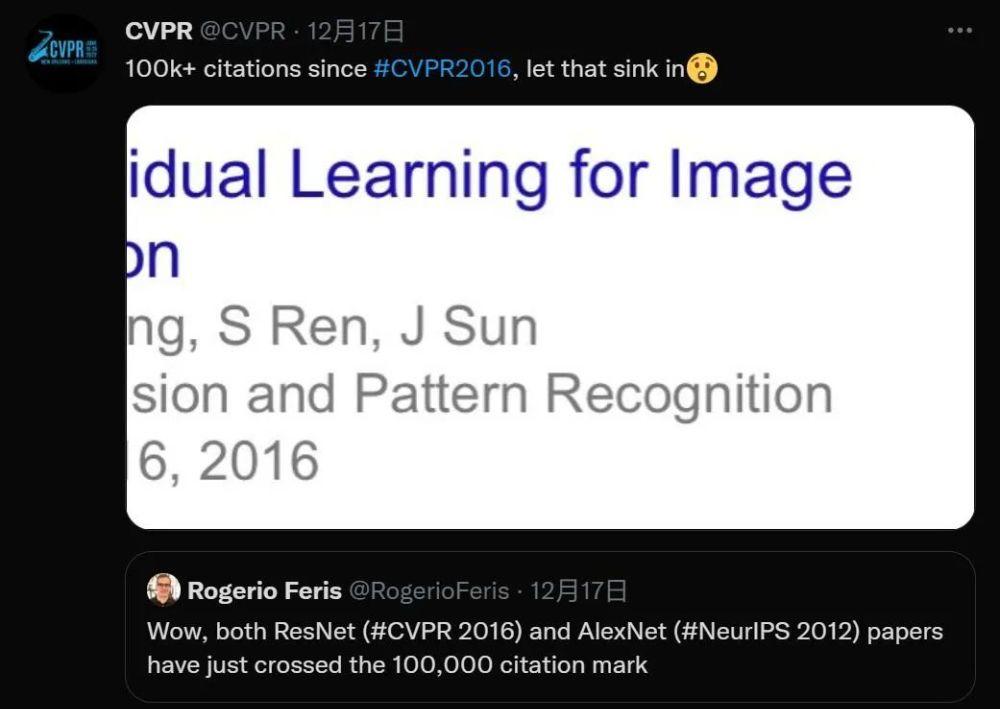

前幾天,人們發現 ResNet 論文被引用數量悄然突破了 10 萬加,距離論文的送出剛過去六年。

《Deep Residual Learning for Image Recognition》在 2016 年拿下了計算機視覺頂級會議 CVPR 的最佳論文獎,相比 NeurIPS 最高熱度論文《Attention is All You Need》,ResNet 的被引數多出了幾倍。這一工作的熱度如此之高,不僅是因為 ResNet 本身的久經考驗,也驗證了 AI 領域,特别是計算機視覺如今的火熱程度。

論文連結:https://www.cv-foundation.org/openaccess/content_cvpr_2016/papers/He_Deep_Residual_Learning_CVPR_2016_paper.pdf

該論文的四位作者何恺明、張祥雨、任少卿和孫劍如今在人工智能領域裡都是響當當的名字,當時他們都是微軟亞研的一員。微軟亞研是業内為數不多的,能夠獲得科技巨頭持續高投入的純粹學術機構。

說道論文本身,殘差網絡是為了解決深度神經網絡(DNN)隐藏層過多時的網絡退化問題而提出。退化(degradation)問題是指:當網絡隐藏層變多時,網絡的準确度達到飽和然後急劇退化,而且這個退化不是由于過拟合引起的。

假設一個網絡 A,訓練誤差為 x。在 A 的頂部添加幾個層建構網絡 B,這些層的參數對于 A 的輸出沒有影響,我們稱這些層為 C。這意味着新網絡 B 的訓練誤差也是 x。網絡 B 的訓練誤差不應高于 A,如果出現 B 的訓練誤差高于 A 的情況,則使用添加的層 C 學習恒等映射(對輸入沒有影響)并不是一個平凡問題。

為了解決這個問題,上圖中的子產品在輸入和輸出之間添加了一個直連路徑,以直接執行映射。這時,C 隻需要學習已有的輸入特征就可以了。由于 C 隻學習殘差,該子產品叫作殘差子產品。

此外,和當年幾乎同時推出的 GoogLeNet 類似,它也在分類層之後連接配接了一個全局平均池化層。通過這些變化,ResNet 可以學習 152 個層的深層網絡。它可以獲得比 VGGNet 和 GoogLeNet 更高的準确率,同時計算效率比 VGGNet 更高。ResNet-152 可以取得 95.51% 的 top-5 準确率。

ResNet 網絡的架構和 VGGNet 類似,主要包括 3x3 的卷積核。是以可以在 VGGNet 的基礎上在層之間添加捷徑連接配接以建構一個殘差網絡。下圖展示了從 VGG-19 的部分早期層合成殘差網絡的過程。

ResNet 的部分結構。很多人說,何恺明的論文非常易懂,光看插圖就能讀懂思想。

ResNet 因其強大的表征能力,除圖像分類以外,包括目标檢測和人臉識别在内的許多計算機視覺應用都得到了性能提升。自 2015 年 問世以後,領域内許多研究者都試圖對該模型做出一些改進,以衍生出一些更适合特定任務的變體。這也是 ResNet 超高引用量的重要原因之一。

在 ResNet 引用突破十萬大關時,另一篇經典論文,2012 年的 AlexNet 被引量也突破了十萬。

AlexNet 是 2012 年 ImageNet 競賽冠軍獲得者 Alex Krizhevsky 設計的卷積神經網絡,最初是與 CUDA 一起使用 GPU 支援運作的。該網絡的錯誤率與前一屆冠軍相比減小了 10% 以上,比亞軍高出 10.8 個百分點。圖靈獎獲得者 Geoffrey Hinton 也是 AlexNet 的作者之一,多倫多大學 SuperVision 組的 Ilya Sutskever 是第二作者。

論文連結:https://papers.nips.cc/paper/2012/file/c399862d3b9d6b76c8436e924a68c45b-Paper.pdf

Alexnet 網絡包含 6000 萬個參數和 65000 萬個神經元,8 層結構中包含 5 層卷積層和 3 層全連接配接層。Alexnet 首次在卷積神經網絡中成功應用了 ReLU、Dropout 和 LRN 等 Trick。

一篇 CVPR 2016 的文章,和一篇 NeurIPS 2012 的文章雙雙突破 10 萬引用,凸顯了 AI 領域近年來的火熱。另外值得一提的是,AlexNet 是 2012 年 ImageNet 圖像識别競賽的冠軍,而 ResNet 是 2015 年的冠軍。

根據 Google Scholar 的統計,ResNet 第一作者何恺明(Kaiming He)一共發表了 69 篇論文,H Index 資料為 59。

何恺明是我們耳熟能詳的 AI 領域研究者。2003 年他以标準分 900 分獲得廣東省聯考總分第一,被清華大學實體系基礎科學班錄取。在清華實體系基礎科學班畢業後,他進入香港中文大學多媒體實驗室攻讀博士學位,師從湯曉鷗。何恺明曾于 2007 年進入微軟亞洲研究院視覺計算組實習,實習導師為孫劍。2011 年博士畢業後,他加入微軟亞洲研究院工作,任研究員。2016 年,何恺明加入 Facebook 人工智能實驗室,任研究科學家至今。

何恺明的研究曾數次得獎,他曾于 2009 年拿到國際計算機視覺頂會 CVPR 的 Best Paper,2016 年再獲 Best Paper 獎,2021 年有一篇論文是最佳論文的候選。何恺明還因為 Mask R-CNN 獲得過 ICCV 2017 的最佳論文(Marr Prize),同時也參與了當年最佳學生論文的研究。

他最近一次被人們關注的研究是 11 月份的《Masked Autoencoders Are Scalable Vision Learners》,提出了一種泛化性能良好的計算機視覺識别模型,有望為 CV 的大模型帶來新方向。