压力测试是用来检测系统承载能力的有效手段。在系统规模较小的时候,在一台空闲的服务器上使用[ab],[wrk],[siege]等工具发起一定量的并发请求即可得到一个初步的测试结果。但在系统复杂度逐步提高,特别是引入了负载均衡,微服务等架构后,单机的压力测试方案不再可用,企业需要搭建分布式测试集群或者付费使用外部供应商提供的压力测试服务。

不管是采取自主搭建或是采用外购的手段,都会面临系统使用率不高以及成本的问题。基于kubernetes的动态资源调度功能,以及kubernetes集群的动态伸缩特性,我们可以充分利用集群内的闲置计算资源,在需要进行压力测试时启动测试节点,在测试结束后释放资源给其他业务,甚至通过集群扩容和缩容临时为压力测试提供更多的计算资源。

支持分布式部署的压力测试工具有多款,今天我们将介绍在kubernetes集群中使用tsung进行压力测试的方法。

[tsung]是一款使用[erlang]开发的分布式压力测试系统,它支持http,jabber,mysql等多种协议,可以用于不同场景的压力测试。与传统的针对单一测试目标重复请求的压测系统不同,tsung更侧重于模拟真实使用场景。测试人员指定新用户到访频率,并设定一系列的模拟操作请求。所有的slave节点将在master节点的统一调度下,按照到访频率创建虚拟用户,并发送操作请求。

所有请求的耗时以及错误信息将传回master节点用于统计和报表。

选择tsung主要有三方面的考虑:

性能优越。erlang语言天生就是为高并发网络系统设计的。合理配置的tsung集群可以实现100w以上的并发流量。

描述式的配置方法。不论简单还是复杂,tsung均统一使用xml文件描述整个测试步骤以及各种参数。这样可以在集群架构保持不变时完成各种测试。

模拟真实用户的测试理念。在真实场景中,用户会访问系统的各项功能。只有支持模拟真实用户的压力测试系统才能比较准确的反应系统各个部分在压力下的状态,找到瓶颈环节。

由于tsung采取的工作模式是在配置中注明slave地址,然后由master连上slave完成测试,传统的部署方法是启动多台物理机或者虚拟机,分别配置它们。在这种工作模式下,会产生大量的运维工作,同时这些计算资源在不进行测试时处于闲置状态,降低了硬件使用率。

利用kubernetes强大的调度能力,我们可以将tsung运行在容器当中,动态的启动和删除。当需要提高测试规模时,我们仅需要使用[archon]等已有的工具对集群进行扩容,就可以很方便的一键扩容slave的数量,几乎没有带来任何的运维负担。

以下是具体的操作流程:

这里不能使用<code>deployment</code>,只有使用<code>statefulset</code>才能在为每一个<code>pod</code>分配独立的内部域名,供master连接。

将以下文件保存为<code>tsung-slave-svc.yaml</code>

将以下文件保存为<code>tsung-slave.yaml</code>

在kubernetes中创建相应的资源

这里我们设置了<code>statefulset</code>的<code>servicename</code>字段,这样启动的<code>pod</code>在集群内部就可以通过<code>tsung-slave-0.tsung-slave.tsung.svc.cluster.local</code>

这个域名访问到。

与slave类似,master节点也要求可以在集群内部通过域名访问。所以我们依然需要使用<code>statefulset</code>来运行。

将以下文件保存为<code>tsung-config.yaml</code>

将以下文件保存为<code>tsung-master-svc.yaml</code>

将以下文件保存为<code>tsung-master.yaml</code>

当tsung master的容器被启动后,它会自动开始运行压力测试。在上面的列子中,tsung将向<code>http://target:8000</code>发起为期1分钟的压力测试,在测试期间,每秒钟产生100个模拟用户,每个用户访问10次目标地址。

我们将tsung的配置文件用<code>configmap</code>注入到了master容器当中,这样用户仅需要修改<code>tsung-config.yaml</code>的内容,就可以方便的定义符合自己要求的测试。在实际使用过程中,用户可以自主调整测试持续时间,虚拟用户产生速度,目标地址等参数。用户还可以通过修改<code>tsung-slave.yaml</code>中<code>replicas</code>的数值,并将更多的slave地址加入到<code>tsung-config.yaml</code>当中,来获得更多的测试资源,进一步增加负载量。

在master的运行参数中,我们使用的<code>-k</code>参数将使得master在测试完成后仍处于运行状态,这样用户可以通过<code>8091</code>端口访问到测试结果。

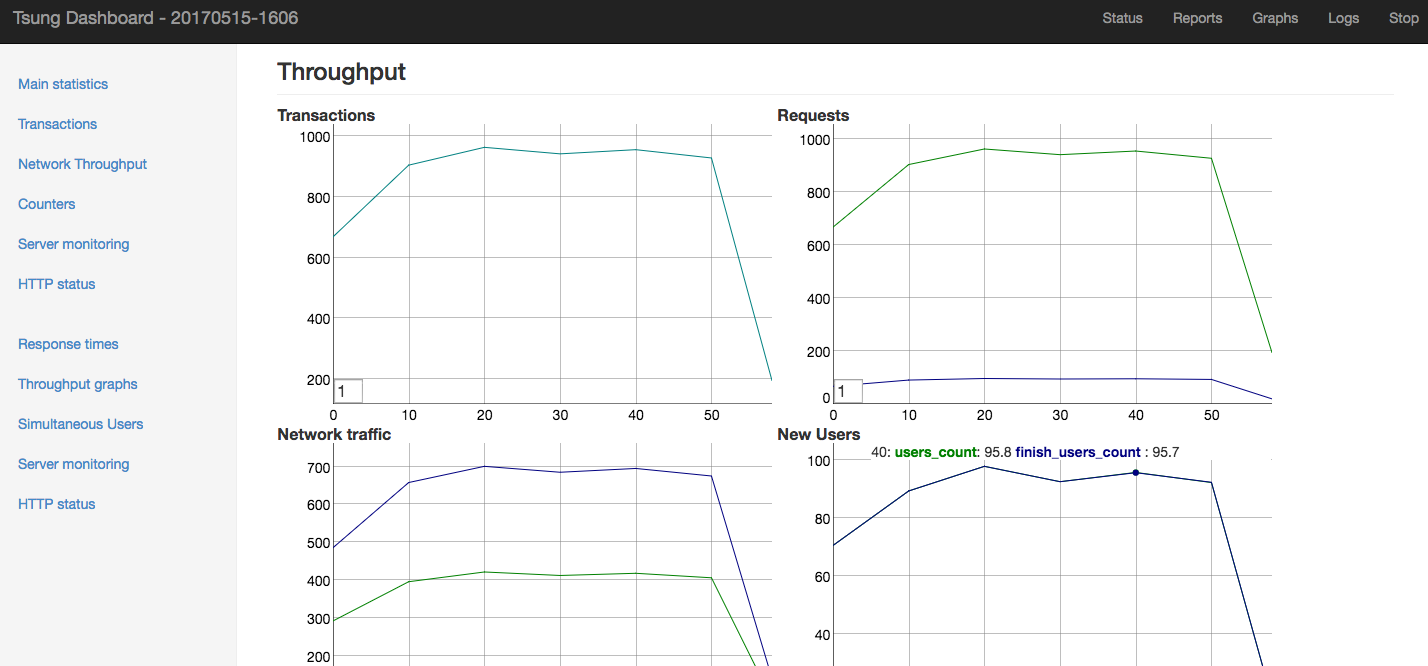

之后在本地通过浏览器访问<code>http://localhost:8091</code>即可打开tsung内置的报表界面。如下图所示:

另外<code>-f</code>参数让master使用<code>fqdn</code>地址访问slave节点,这项参数非常关键,缺少它将导致master无法正常连接上slave。

测试结束后,用户可以使用报表界面查看和保存结果。当所有结果被保存下来之后,可以直接删除<code>namespace</code>完成资源回收。

这样所有的tsung相关配置和容器均会被删除。当下次需要测试时,可以从一个全新的状态开始新一次测试。

本文主要介绍了在kubernetes中部署tsung这款分布式压力测试系统的方法。其中使用<code>statefulset</code>配合<code>-f</code>参数的方法,使得master和slave可以顺利的使用域名找到对方,成功的解决了在容器中运行tsung会遇到的访问问题。

原本需要专业的运维工程师投入不少时间才能搭建起来的tsung测试集群,在kubernetes中几乎可以毫不费力的启动起来,完成测试。这种使用调度器充分利用集群空闲资源,使用后及时释放供其他系统使用的方法,也充分体现了kubernetes的优越性。

在下一篇分享中,我们将使用本文所描述的测试系统,对主流的python wsgi服务器进行压力测试,用以对比各个服务器的性能指标。希望通过这种实战演示的方式,帮助大家深入了解tsung以及kubernetes。敬请期待。