以下内容根据演讲ppt以及现场分享整理而成。

主要内容提纲

一、docker网络分析

二、docker网络插件开发

三、蚂蚁金服的网络插件实践

主要介绍三种docker网络,bridge网络、docker原生的overlay网络以及weave网络,在这里主要分享一下这些网络的架构或者说是结构。

docker bridge网络

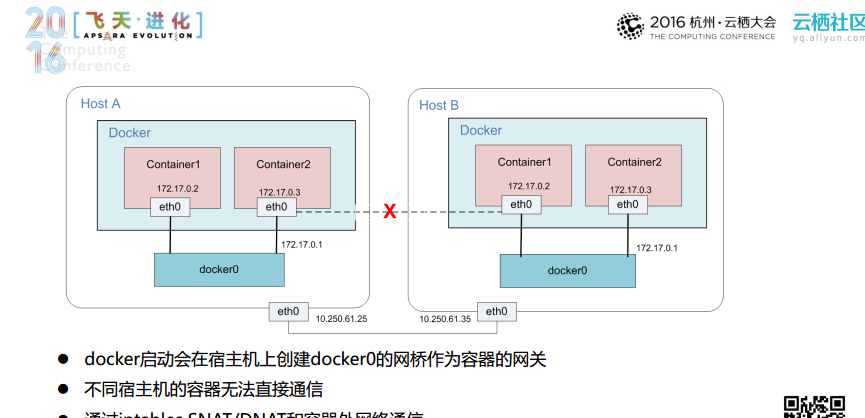

bridge网络可能是大家最熟悉的网络,如下图所示,hosta和hostb是两个宿主机,docker运行起来就将在宿主机上创建docker0的网桥作为容器的开关。

在网桥建立完成之后,同一个宿主机上的不同容器之间就可以通过网桥的转发功能进行通信,但是位于不同宿主机器上的容器无法直接进行通信,他们可以通过iptables snat/dnat和容器外网络进行通信。bridge网络结构比较简单,但是缺点是不同宿主机之间的容器其实并不在一个共同的网络中,不同宿主机之间的容器无法进行直接的通信。

docker overlay网络

对于应用而言,如果要部署在docker中,基本上都需要面对跨主机互联的问题,docker提供了原生的overlay网络,对docker具有良好的支持性。

这里简单提一下vxlan协议,下图中的inner enthernet frame是由容器发出的报文,在经过报文一层层封装以后,最后以udp的方式发送出去。

在overlay网络中,每个容器会有两张网卡,其中一张网卡用于与外部网络进行通信,向外部网络传输的数据会经由eth1网卡,并通过docker_gwbridge发送出去。如果是不同宿主机之间的容器想要通信的话,数据将会通过eth0发送出去。每个overlay网络有独立namespace和br0网桥,在节点组件集群进行通讯时,采用的使用gossip协议来管理节点成员关系、并且通过广播l3miss处理二层arp的交互。而不同网桥上的vxlan设备的作用就是帮助不同宿主机的容器通过vxlan隧道直接通信。

docker weave网络

weave网络的易用性比较高,所以更容易上手,而且目前而言,weave网络的产品系也是比较完善的。weave网络有两种实现方式,一种是用户动态的封装实现,另外一种是内核态的封装实现,这里主要介绍内核态的封装实现。

在下图中weave router中有这样的一个插件,这个插件主要实现了两个功能,一个是帮助与其他的宿主机建立gossip协议的链接,从而建立集群的拓扑关系。另外一点就是帮助跨宿主机的容器通过datapath和vxlan隧道进行通信。

小结

这三种网路有一些共同点,首先需求是共同的,都要满足容器的跨主机通信的需求,同时arp的广播会增加网络负担,阿里云自己的产品上这一点就被解决了,这三种网络使用的gossip协议的运维复杂度,而且无法适应多种docker网络环境,难以满足高性能的网络业务。

二、docker网络插件架构和开发

在介绍阿里云的插件构建之前,先给简单大家介绍docker网络插件架构和开发通用的cnm模型。如下图所示,这里有三个docker容器,这里主要有三个概念sandbox、endpoint和network。sandbox可以理解为docker内部运行的namespace,也就是隔离的网络配置环境;endpoint其实是虚拟的网卡,它隶属于某一个network的通讯端口,多个endpoint也可以在一个sandbox中共存;而network就是所有接在节点里面的endpoint,也就是一个唯一的、可识别的endpoint组。在同一个network中的endpoint可以相互通讯,而且你可以创建一个frontend和backendnetwork,然后这两个network是完全隔离的。

在理解这三个概念之后,我们看一下这些概念是如何在流程中串联起来的。docker在启动起来时会起到controller这样的角色,当创建network的时候,就会调用newcontroller函数,之后再调用newsandbox创建namespace,之后还会调用newendpoint,使得插件自己处理如何去创建endpoint,最后将调用join的方法,建立sandbox和endpoint的关系,这时候就相当于容器中有了网卡。

目前docker已经提供了开发“利器”,也就是docker官方提供的开发框架。大家在开发时只需要导入几个包,当容器运行起来,整个插件的服务也就开始运行了,后面需要实现的就是几个接口了。也就是相当于大家不用从零开始造轮子了。

docker和plugin是如何通信有三种方式:.sock/.spec/.json。一般大家使用的都是sock的方式。目前蚂蚁金服使用的都是容器的方式,这样的方式既可以很方便地对它进行升级,也可以很方便地进行管理。

三、蚂蚁金服网络插件

vlan driver

vlan driver其实是最接近于现有物理网络的驱动插件。在这样的方案中,宿主机的管控流量和容器的流量被隔离在两个不同的vlan中,采用了ovs bridge,并且将容器接入到这个ovs bridge中。为了避免arp广播风暴并且缓解交换机pps的巨大压力,采用了arp带回的策略和大二层的策略,也避免了容器mac地址表象对于交换机的影响。目前在大部分的企业都选择了vlan的方式,因为它最适配现有物理网络,对业务影响最小。

sriov driver

sriov driver本质上也是vlan网络,但是目前没有采用ovs。因为有一些像db这样的业务对于网络的延迟有更高的要求,才产生了sriov driver。具体的做法就是将vf虚化出来,直接塞到容器里面去,沿用现实场景中的bonding模式,使用双活的bonding模式使得pf和vf两边都可以结合起来。

vpc driver

业务上云会有两种选择,一个是经典的云环境,另外就是vpc的环境。如果大家使用的是vpc环境,就可以采用我们的这种vpc driver。其主要实现方式就是阿里云提供了自定义路由的方式,可以自定义vrouter上的路由,也就是自定义数据到达vrouter之后下一跳的路径,如果是利用专线就可以实现和用户中心的docker互联。vpc driver非常适用于在阿里云的vpc上使用docker。

vxlan driver

vxlan driver适用于在阿里云经典云环境上面进行构建应用的场景。这个方案是比较完善的,它将slb,以及对内和对外的因素都考虑进去了。vxlan driver具有独立的ipam,支持subnet,进行了macnat和arp带回,所以在容器里面看到的所有容器的mac地址都是一样的。比较适用于在阿里云经典vm中运行多docker。

smart nic driver

之前提到的方式都是在linux内核中完成的,所以消耗的是linux主机的能力,在千兆网络环境下大家可能觉得不是问题,但是在万兆网络中,就会感觉到无法发挥出万兆网络真正的能力。由于没有sriov网络隔离,容器之间网络的影响还是比较大的,另外在各种业务整合的时候,需要做流量管控的时候又将是性能消耗点。

高性能网络其实要做的就是类似一张智能网卡,用网卡对于协议报文进行加解封装,然后将协议报文直接送到容器里面,宿主机性能没有任何消耗,而且这样对于智能网卡功能的扩展也非常容易,也不会影响宿主机。实现了无论网卡如何,保证容器底层的网络最优。