论文解读

这次分享的论文是:

http://hlt.suda.edu.cn/~zhli/papers/liying_ijcai19_dp.pdf

是由SUDA-HLT实验室LA组的博士二年级学生李英发表在2019IJCAI上的一篇文章。

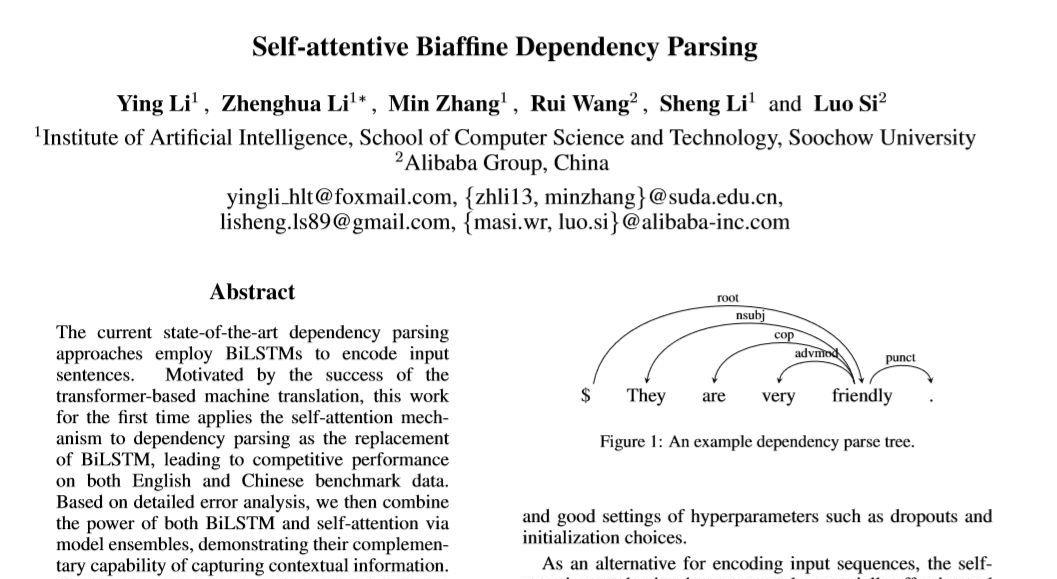

根据这个题目Self-attentive Biaffine Dependency Parsing你可能会想到经典的biaffine parser(不了解的点这个链接):

https://arxiv.org/pdf/1611.01734.pdf

和Transformer的Encoder:

https://papers.nips.cc/paper/7181-attention-is-all-you-need.pdf

对,就是这样的,可以说是强强联合,将目前的parser SOTA模型(biaffine parser based bilstm)的提取特征层(bilstm)替换成self-attention(Transformer的Encoder层)来提取特征。效果和用bilstm的效果几乎是一样的:

LAS基本一样,但是这篇文章新颖的点在哪里呢?

1.第一次将self-attention使用在parser里

2.获得了和SOTA模型几乎一样的性能

3.同样相似的效果但不同类型的encoder(bilstm和self-attention)ensemble起来效果会更好

4.验证了最新的预训练数据(ELMo和BERT)能够提高parser的性能。

5.速度上,并行的self-attention肯定比bilstm要快。

总结

做个总结吧,ijcai是一类顶会,宏观角度看这篇文章

1. 很前沿:

- 李英师姐用了目前最火的self-attention(Transformer的encoder)替换了我们一直使用的SOTA模型biaffine parser based bilstm 的 bilstm

- 使用了最新的预训练模型ELMo和BERT于自己提出的模型上,有效果。

2. 很认真(苦力):

- 我问了师姐,模型写的很快,但是调出理想的参数大概就用了2-3个月。

发顶会应该就这两点:前沿+认真!

加油,希望我和你也能来一篇。

推荐阅读:

【一分钟论文】 NAACL2019-使用感知句法词表示的句法增强神经机器翻译

【一分钟论文】Semi-supervised Sequence Learning半监督序列学习

详解Transition-based Dependency parser基于转移的依存句法解析器

经验 | 初入NLP领域的一些小建议

学术 | 如何写一篇合格的NLP论文

干货 | 那些高产的学者都是怎样工作的?

一个简单有效的联合模型

近年来NLP在法律领域的相关研究工作