其實對于節能,傳統技術也是做了“十二分”的努力。但是在技術不斷演進的情況下,傳統節能技術還是存在問題,如何破?

摘要:其實對于節能,傳統技術也是做了“十二分”的努力。但是在技術不斷演進的情況下,傳統節能技術還是存在問題,如何破?

本文分享自華為雲社群《資料中心節能?來試試華為NAIE資料中心節能技術!》,原文作者:啟明 。

一、3 年電費消耗,可再建造一個資料中心!

1.1 科技驅動,推動資料中心市場持續高速發展

國際慣例,先介(bai)紹(du)一(bai)下(ke)“資料中心”:資料中心是全球協作的特定裝置網絡,用來在 internet 網絡基礎設施上傳遞、加速、展示、計算、存儲資料資訊。一個資料中心的主要目的是運作應用來處理商業和運作的組織的資料。

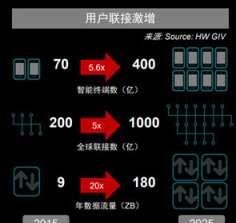

現如今,我們已經處在一個全聯接的世界。從 2015 年到 2025 年,根據華為 GIV 的資料預測,全球智能終端聯接數将從 70 億激增到 400 億,全球聯接數也将從 200 億激增到 1000 億。而在硬體數和聯接數激增的背後,是資料流量的爆發式增長:年資料流量将從 9ZB 以 20 倍的速度湧至 180ZB(見圖 1)。

圖 1:資料來源于 HW GIV

資料流量的極速增長,加上政府對各新興産業的大力扶持,資料中心的發展建設将迎來高速發展時期,根據 MarketsAndMarkets 的資料統計預估,全球資料中心的價值将從 2017 年的 130.7 億美元增長到 2022 年 465.0 億美元(見圖 2),這其中的 CAGR(Compound Annual GrowthRate,複合年均增長率)高達 28.9%。其市場規模及市場價值,不言而喻。

圖 2:資料來源于 MarketsAndMarkets

1.2 高電力消耗,資料中心産業“背後的陰影”

“陽光背後總有陰影”。高産業價值的背後,是高電力消耗。作為“資料中心”,可以想象:一個大型機房,裡面密密麻麻地布滿了各式各樣的機櫃、伺服器等。資料中心的前期基礎建設和投資,将會是一筆巨額數字。而一旦啟動使用,這其中的電費,又将是一個天文數字。我們可以用一個大型資料中心 10 年的營運成本情況來看看這其中的電力使用情況:

從上面的表格可以看到,該資料中心每年電費将近 3600 萬,其中有 70%都用于電費,而 70%的電費中,又有 19%用于制冷上。且據 2017 年統計,全球資料中心用電量占全球用電量的 3%,年增長率超過 6%,相當于 30 個核電站;僅中國的資料中心用電量每年就有 1200 億千瓦時,超過三峽電站 2017 年全年發電量(1000 億千瓦時)。計算下來,資料中心 3 年的電費可以再造一個資料中心!

1.3 外部政策+營運挑戰,資料中心産業節能成必然趨勢

資料中心背後的電費資料如此觸目驚心,以至于在國家層面都有相關的政策對能效名額提出了嚴格的要求:如,工業和資訊化部在《綠色資料中心指導意見》中要求建立的資料中心的 PUE 要小于 1.4;對于北京、上海、深圳等地也對 PUE 有規劃的要求,特别是深圳市發改委鼓勵建立的資料中心的 PUE 要小于 1.25,這其實是一個很有挑戰的數字。當然,歐盟和美國對 PUE 也有相應的自己的規範。畢竟,節能,就意味着降低成本,進而增加利潤。

要解決能耗問題,我們需要先把能耗問題列成一個公式,進而通過降低或增加公式的某個值來達到降低能耗的目的。這個公式就是我們前面說的 PUE 的計算方法。

PUE,即 Power UsageEffectiveness,電能使用效率。PUE=資料中心總能耗/IT 裝置能耗,其中資料中心總能耗包括 IT 裝置能耗和制冷、配電等系統的能耗。PUE 的值,必然是大于 1 的。舉個例子,如果 PUE=2,那就意味着,IT 裝置每消耗 1 瓦特的電量,就需要額外再消耗 1 瓦特的電量對它進行配電和冷卻。當然,如果在理想情況下,如果所有的電力全都消耗在 IT 裝置上,也就是說所有的電力全用于生産,那麼這時候的 PUE 就是等于 1。

下圖為一個資料中心的能耗單元詳情:

可以看到,一個資料中心的能耗單元包括冷水機組,水泵,IT 裝置,風扇,新風照明等等,這些單元的能耗處于分子的位置。PUE 越接近 1,則使用效能越高,越省電,越省錢。那麼要節電,很自然的,我們會從分子入手,即非 IT 能耗(主要為制冷功能)。

1.4 找到原理,資料中心如何制冷

在想解決辦法之前,我們先看看資料中心的制冷原理(下圖為制冷簡圖)。

整個系統可以分為冷凍站和末端機房兩部分,這邊虛線的左側是冷凍站,它包括冷卻塔,制冷機組,各種功能的水泵以及儲存冷水使用的蓄冷罐;虛線右側則是我們的 IT 裝置機房,裡面除了伺服器機櫃外,還要用來吹出冷風的空調。空調的冷源即來自于左側的冷凍站。

簡單來說,整個系統制冷系統就是把 IT 裝置裡伺服器散發出來的熱量給搬移到室外去,制冷系統的耗電單元也很直覺,就是圖上的冷卻塔,冷卻泵,冷機以及空調等。

當然,上圖隻是一個簡單的原理圖,實際中的制冷圖會遠比上圖複雜的多。那麼複雜的系統我們該如何節能呢?

1.5 技術演進下,傳統節能技術的局限

其實對于節能,傳統技術也是做了“十二分”的努力。但是在技術不斷演進的情況下,傳統節能技術還是存在以下問題:

- 産品級節能技術應用已接近天花闆;

- 系統複雜、裝置多、各裝置間能耗影響關系錯綜複雜,難以用傳統工程學公式模拟,傳統控制方式各自為政,專家經驗作用已達極限;

- 每個資料中心都是獨特的環境和架構,雖然許多工程實踐和經驗法則可以全面應用,但一個系統運作的定制模型并不能保證另一個系統的成功。

二、NAIE 資料中心節能技術如何助力節能

2.1 業界共識,AI 助力資料中心節能

如前面所說,傳統節能技術已經無法滿足資料中心節能的需求。大家開始尋求新的方式。

現如今,業界的共識是使用 AI 來調節整個制冷系統,讓各個裝置運作狀态互相比對,進而達到最佳狀态。根據 Gartner 的使用者調研顯示,截止 2020 年,30%未做好人工智能準備的資料中心,其業務将不再具有經濟性。同時,調研還列舉了人工智能改善資料中心日常營運的三種方式:

- 利用預測分析優化工作負載配置設定,實施優化存儲和計算負載平衡;

- 機器學習算法以最佳方式處理事務,用人工智能來優化資料中心能耗;

- 人工智能可緩解人員短缺,自動執行系統更新、安全更新檔。

“使用 AI 來調節制冷系統”,最有名的是 Jim Gao 和 DeepMind 團隊的合作。他們使用神經網絡分别預測了 PUE、資料中心的溫度、負載壓力,來控制大概 120 個資料中心的變量,進而實作 PUE 的降低。

業界對于 AI 技術進行資料中心節能已經有非常成功的應用,接下來,我們看看 NAIE 資料中心是如何助力節能的吧!

2.2 華為 NAIE 資料中心節能技術

就“節能”而言,其實是一個非常大的話題,而 NAIE 資料中心節能,也是包含了很多方面,我們今天的介紹,以“制冷系統節能”為主。針對“制冷系統節能”,NAIE 資料中心節能有以下 4 個“手段”:

2.2.1 原始資料特征工程

對于資料中心的制冷系統,一般都有着複雜的管路布局、安裝的制冷機組(水泵,水塔等裝置),并且除了這些裝置之外,還有數不清的傳感器。同時,不同的資料中心,根據選址的不同也會有各方面的差異,最終導緻管路和裝置都是不一樣的。

針對這些資料差異,我們可以通過 AI 算法屏蔽:通過特征工程去處理一些複雜的結構,比如說單管、母管、環管等;根據不同的管制,我們想辦法提取統一的特征,然後針對不同的裝置,如冷塔、冷機、熱交換機、水泵、空調等,綜合提取比較接近的特征;最後,對資料進行校驗,對缺失的資料給予補齊,對錯誤的資料機進行糾正,對異常的樣本進行删除。

是以,通過特征工程,我們可以将局點采集到的資料加工成一個比較統一的形式,提供給後面的 AI 算法。

2.2.2 能耗預測和安全保障模型

要節能,首先需要有一個能耗預測模型。建立一個好的模型,是預測如何調節制冷系統節能的一個良好開端。但面向工業控制領域的預測模型,與預測股票走勢,或者是地鐵人流量的模型有一個比較大的差別:對安全的控制。畢竟安全生産是第一位的,省電省錢才是第二位的。

是以 NAIE 資料中心節能預測模型不是一個簡單的、獨立的模型,而是一套模型:不僅要預測在調節之後的能耗,還要預測各個智能系統的狀态。要保證在所有系統狀态正常的基礎上,再去節能。

2.2.3 控制參數尋優

前面兩個“手段”的介紹,已經為節能算法打下了良好的基礎。到了第三個“手段”,就要出“成績”了。我們搜尋到的控制參數是不是“優秀”,完全是由第三個“手段”的品質來決定的。“能耗預測和安全保證模型”提供了一個很好的能耗和狀态預測的模型,可以把這個模型想象成一個超曲面圖形(如下圖)。當然,它的形狀是畫不出來也很難想象的,因為我們解決的是一個高維空間的問題,并且在這個超曲面上還有很多的空洞,這些空洞表示不安全的控制參數。那麼我們第三個“手段”的目的就是為了又快又好的找到其中更優或者最優的控制參數,下發給裝置來執行。

2.2.4 NAIE 雲地協同

雲地協同,即是打通了雲端和地端,實作資料采集上雲,模型日常評估,重(chóng)訓練,模型更新全流程的自動化的服務。

簡單說明一下:資料采集,即新的樣本;模型的日常評估,即決定什麼時候更新;重訓練,即重新訓練的流程,最後達到模型更新全自動化的目的。(具體架構圖見下)

NAIE 的雲地協同,在雲上有 NAIE 的資料湖、資料中心 PUE 優化模型生成服務,以及 AI 市場(AI 市場用來管理生成的模型包);在客戶網絡的地端,有網絡 AI 架構(運作模型生成服務生成的模型的平台)。地端的網絡 AI 架構負責樣本采集及管理,同時還負責運用新的樣本不斷地對生成的模型進行評估。如果發現采集的樣本的分布發生了明顯的變化,或者說是模型精度老是不達标的時候,就會觸發去重模組化型。

同時,網絡 AI 架構通過華為的 Cloud Opera Neteco 系統與資料中心的實際控制系統進行了對接。如此一來,由模型生成的控制參數可以直接下發到實際的群控系統裡面。

2.3NAIE 助力資料中心節能,所向披靡

華為的某資料中心,在 NAIE 的加持下,全年的 PUE 經過優化之後,對比使用 AI 前,PUE 降低了 0.12,換算成電力,也就是每個采樣周期可以降低 328.6 千瓦的耗電。這樣算下來,一年可以省掉 580 萬元的電費,一個相當可觀的數字。

- NAIE 模型生成服務

不同的資料中心,在制冷模式(水冷、風冷、AHU 等)、管路類型(母管、單管、混合管)等方面很可能存在差異,我們該如何入手呢?

這裡就要用到我們前面說的“特征工程”。如我們前面所說,“特征工程”的用處就是能夠屏蔽 AI 算法的諸多差異,能夠盡量形成統一的特征。

普通的模組化(如下圖),針對開發人員:從節能模組化到模型應用,需要開發人員 4 個,曆時 6 個月。

而 NAIE 在“特征工程”與“老專家”的技術加持下,已經為大家準備好了前序條件,我們來看看 NAIE 的幾大亮點與優勢:

1. 零編碼高效模組化:基于華為的資料中心拓撲模闆、AI 模型訓練平台和 PUE 特征/算法庫,能源工程師隻需提供基礎設施運作資料和制冷裝置工藝參數,無需任何編碼,即可線上得到比對其資料中心的 AI 模型,模型開發時間從 8 人*6 月降低到 1 人*1 月,整個模型的開發投入降低 95%以上;

2. 參數配置靈活可視:基于華為在資料中心領域可視化的參數配置,通過調整參數,即可生成不同拓撲模闆下資料中心的 PUE 模型;

3. 控制政策全面:通過導入資料中心基礎設施 PUE 相關全量參數,模型能推理出全套制冷裝置的控制政策,如冷水機組、冷卻泵、冷卻塔、冷凍泵、闆換等,幫助能源工程師靈活精準地調控制冷系統,以達到最佳能耗狀态;

4. 優化效果好:通過專業的特征識别及處理,模型拟合效果好。 在數量品質保證前提下,PUE 預測準确率達到 95%。

通過資料中心 PUE 優化模型生成服務官網(https://console.huaweicloud.com/naie/products/dpo),可以快速體驗服務:點選“功能示範”:

進入服務介紹頁面,根據指導一步步往下走,即快速便捷體驗資料中心 PUE 優化模型生成服務。

資料中心 PUE 優化模型生成服務結合 AI 技術與資料中心工程經驗,提供自動化模組化工具(如資料中心拓撲模闆、PUE 特征/算法庫、模型訓練平台),幫助資料中心領域工程師 0 基礎 0 編碼,隻需輸入資料中心基礎設施的運作資料,即可線上得到有效的 PUE 優化模型,一起來試試?

點選關注,第一時間了解華為雲新鮮技術~