- 介紹一個完整的機器學習項目流程?

- 數學抽象:根據資料明确任務目标,是分類、還是回歸或者是聚類。

- 資料擷取:資料決定了機器學習結果的上限,而算法隻是逼近這個上限。資料要有代表性,不然肯定過拟合。對于分類問題,資料偏斜不能太嚴重,差距不宜過大。對于資料的量級有一個評估,多少個樣本,多少個特征。根據記憶體估算需求。

- 預處理與特征選擇:預處理、資料清洗。歸一化、離散化、因子化、缺失值處理,去除共性等。篩選有效特征。

- 模型訓練與調優:算法訓練與調優。

- 模型診斷:對模型的實際表現進行診斷:包括過拟合、欠拟合等。常見的例如交叉驗證以及繪制學習曲線等等。過拟合的基本思路是增加資料量、減少模型參數,降低模型複雜度。欠拟合就是提高特征數量和品質,增加模型複雜度。誤差分析是指:參數的問題還是算法選擇的問題,是特征的問題還是資料本身的問題。診斷之後需要進行調優,調優後的模型需要重新診斷,這是一個反複疊代逼近的過程,需要不斷的嘗試達到最優狀态。6. 模型融合:工程上一般是在前端也就是資料清洗以及預處理上面與後端融合友善下功夫。因為比較标準簡單容易複制,直接調參的工作不會很多,畢竟訓練起來太慢了,而且效果難以保證。

- 上線運作:主要包括模型的運作速度(時間複雜度),資源消耗程度(空間複雜度)以及最後的穩定性如何。

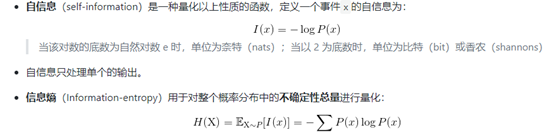

- 資訊熵與自資訊:

自資訊時一個事件承載的資訊量。資訊熵是對整個機率分布的不确定性的總體進行量化。

KL散度:

在離散型變量的情況下,KL散度衡量的是:當我們使用一種被設計成能夠使得機率分布Q産生消息的長度最小的編碼,發送包含由機率分布P産生的符号資訊時,所需要的額外資訊量。

性質:-----非負:KL散度為0當且僅當P與Q在離散型變量的情況下是相同的分布,或者在連續型變量下處處相同。

-----不對稱。

交叉熵:

交叉熵本質上可以看成,用一個猜測的分布的編碼方式去編碼其真實的分布,得到的平均編碼長度或者資訊量。一般用于最後的損失函數。

互資訊:(資訊增益)

一個聯合分布中的兩個資訊的糾纏程度或者叫做互相影響的那部分資訊量。

比較典型的就是決策樹的分支标準:使用的就是資訊增益的方式互資訊。

邏輯回歸:

關鍵點:

定義:

損失函數:極大似然估計;

多分類回歸模型:

支援向量機:

-

簡單描述:

二分類模型:定義在特征空間上間隔最大的線性分類器,間隔最大使其有别與感覺機。包括核技巧,使其成為非線性分類器。

學習政策:間隔最大化。求解凸二次規劃的問題。

求解凸函數二次規劃的最優化算法。

- 支援向量:訓練集中與分離超平面距離最近的樣本點的執行個體叫做支援向量。

機器學習小結與面經19_2_22 -

分類:

訓練資料線性可分:-----硬間隔最大化;線性可分SVM;

資料接近線性可分-------軟間隔最大化;

資料線性不可分---------使用核技巧以及軟間隔最大化。

-

核函數:

将輸入從輸入空間映射到特征空間後得到的特征向量之間的内積。

線性可分SVM:

a. 根據間隔最大化的目标導出标準SVM問題。

b. 使用拉格朗日乘子對偶問題的求解過程。

決策樹:

特征選擇;樹的生成以及剪枝。

ID3與C4.5之間的差別:

前者使用資訊增益進行特征選擇後者使用資訊增益比。

回歸樹:

Cart算法假設決策樹是二叉樹,内部取值節點為是或者否。

Cart樹既可以用于分類也可以用于回歸。

對回歸的情況,算法使用平方誤差最小化政策選擇特征,對分類樹使用基尼系數最小化準則選擇特征。