雲栖号資訊:【 點選檢視更多行業資訊】

在這裡您可以找到不同行業的第一手的上雲資訊,還在等什麼,快來!

科技行者 5月11日 北京消息:半導體是數字時代的一項基礎技術。美國矽谷的名字正是源自于此。過去半個世紀以來,計算技術的革命改變着社會的方方面面,而半導體技術正是這場革命的核心。

自英特爾1971年推出全球第一個微處理器以來,計算能力一直以令人驚歎的步伐發展演進着。根據摩爾定律,目前的計算機晶片比50年前的晶片在功能上強大數百萬倍。

盡管數十年來處理能力飛速增長,但直到現在,計算機晶片的基本體系結構仍然沒有太大改變。很大程度上說,晶片的創新,需要進一步縮小半導體的體積,讓內建電路可以容納更多半導體。數十年來,英特爾和AMD等廠商通過提高CPU性能而取得了長足的發展,被Clayton Christensen視為“持續的創新”。

今天,這種情況正在發生着巨大的變化。人工智能(AI)引發了半導體創新的“新黃金時代”——機器學習帶來獨特的市場需求和無限的機會,第一次激發了企業家們,去重新思考晶片架構的基本原則。

他們的目标,是設計一種專為AI設計的新型晶片,為下一代計算提供動力,這也是目前所有硬體領域最大的市場機遇之一。

新的計算範式

在計算技術發展的曆史中,主流的晶片架構一直是CPU。如今,CPU無處不在,它為筆記本電腦、移動裝置和大多數資料中心提供動力。

1945年,傳奇人物約翰·馮·諾伊曼(John von Neumann)構思了CPU的基本架構。值得注意的是,此後他的這一設計基本沒有太大變化,今天,大多數計算機仍是基于馮·諾依曼理論的機器。

CPU的靈活性使得它有各種各樣的用途:CPU是通用的,能夠有效執行軟體所需的任何計算。不過盡管CPU的主要優勢是多功能性,然而如今領先的AI技術需要的,是一種非常特殊且密集的計算。

深度學習需要疊代執行數百萬甚至是數十億個相對簡單的乘法和加法步驟。深度學習以線性代數為基礎,在根本上是基于試錯法的:對參數進行調整,對矩陣進行乘法運算,随着模型自身的不斷優化,在整個神經網絡中反複進行數字求和。

這種重複性的、計算量巨大的工作流程,對于硬體體系結構有很重要的要求。「并行化」變得至關重要,「并行」指的是:處理器能夠同時、而不是一個接一個地執行多個計算的能力。與之緊密相關的是,深度學習涉及大量資料的連續轉換,是以讓晶片記憶體和計算核心盡可能靠近資料所在的位置,可以減少資料移動,進而大幅提升速度和效率。

CPU尚不足以支援機器學習的獨特需求。CPU是按順序而非并行地處理計算任務,CPU的計算核心和記憶體通常位于單獨的子產品上,通過帶寬受限的通信系統(總線)進行連接配接。這就造成了資料移動的瓶頸,稱為“馮·諾依曼瓶頸”,導緻的結果就是,在CPU上訓練神經網絡的效率非常低。

随着機器學習正在日益普及,傳統晶片已經無法應對現代AI算法的要求,這一點正變得愈加突出。正如AI專家Yann LeCun最近所說的:“如果你能穿越到未來五年或者十年,看看計算機大部分時間都在做些什麼的話,我認為很可能是機器學習之類的事情。”

這時候,就需要GPU來推動AI的繁榮發展了。GPU架構是由英偉達(Nvidia)在1990年代後期為遊戲應用開發的。當時GPU被專門用于連續處理大量資料,以高幀速率渲染計算機遊戲畫面。與CPU不同的是,GPU可以并行地運作數千個計算任務。

在2010年代初,AI領域開始意識到,Nvidia的遊戲晶片實際上非常适合處理機器學習算法所需的工作負載,于是,GPU幸運地找到了新的目标市場。Nvidia抓住了這個機遇,将自己定位為“AI硬體市場領先提供商”,結果收獲了驚人的收益——從2013年到2018年,Nvidia的市值增長了20倍。

然而,正如Gartner分析師Mark Hung所說,“大家知道GPU并非針對AI工作負載進行了優化。”雖然GPU已經被AI領域廣泛采用,但它并非為AI而生。

近些年來,有一大批企業家和技術人員開始重新構想計算機晶片,從頭開始對其進行優化,以釋放AI的無限潛力。Alan Kay的一段話令人難忘:“真正認真對待軟體的人,應該自己制造硬體。”

過去兩年中,有5個晶片獨角獸湧現,很多初創公司的估值令人瞠目結舌。傳統CPU巨頭英特爾為了避免被颠覆,是以進行了兩項重大收購:2016年4月以4.08億美元收購了Nervana Systems,2019年12月以20億美元收購了Habana Labs。未來幾年,這場競賽将繼續進行下去,争奪這個規模數千億美元的市場。

誰會是下一個英特爾?

巨大的市場機會,再加上巨大的技術挑戰,激發了一大批驚人的創意,意圖打造出一款理想的AI晶片。

新一代AI晶片初創企業中,最引人注目之一的是Cerebras Systems公司。簡單地說,大膽的Cerebras開發了有史以來最大的晶片。最近,Cerebras的市值達到了17億美元,已經從Benchmark和Sequoia等頂級投資方那裡獲得了2億美元。

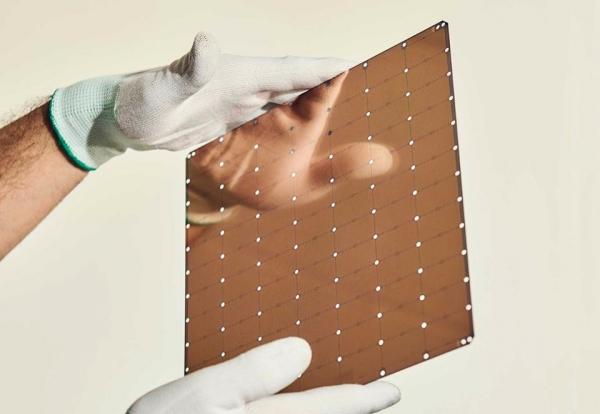

Cerebras晶片的規格令人難以置信,要比典型的微處理器大60倍,是史上第一個可以容納超過1萬億個半導體(準确地說是1.2萬億個)的晶片。它的片上記憶體為18 GB,也是有史以來最高的。

将所有計算能力打包到單個晶片上,好處是非常誘人的:資料傳輸效率大大提升,記憶體與處理并置,可以做大規模的并行處理;但是,工程上的挑戰也是極大的,幾十年來,制造晶圓級晶片一直是半導體夢寐以求的,但從未實作。

Cerebras首席執行官Andrew Feldman表示:“每個規則、每個工具和每個制造器件,都是為巧克力曲奇大小的正常尺寸晶片設計的,而我們打造的晶片是曲奇盤子那麼大。是以每個步驟我們都要進行全新設計。”

Cerebras的AI晶片已經投入商用:上周,阿貢國家實驗室(Argonne National Laboratory)宣布,将使用Cerebras的晶片來對抗新型冠狀病毒。

另外一家采用了全新晶片設計方法的公司,是位于美國灣區的Groq。與Cerebras相比,Groq的晶片專注于推理,而不是模型訓練。Groq的創始團隊擁有世界一流的領域專業知識:作為最早也是迄今為止最成功的AI晶片之一,Google TPU項目的十個原始成員中,有八個人加入了Groq團隊。

Groq颠覆了業界的傳統觀念,正在打造批量為“1”的晶片,也就是說,一次性處理1個樣本。據Groq稱,這種架構幾乎可以實作瞬時推理,而無需犧牲性能,這對于自動駕駛汽車等時間敏感型應用是至關重要的。Groq的晶片主要是軟體定義的,具有獨特的靈活性,是面向未來的。

Groq最近宣布,它的晶片實作了每秒1萬億次運算的速度。如果這是真的話,将成為有史以來速度最快的單模片晶片。

還有另一家公司,沒有哪家公司比它具有更出色的技術願景了,這就是Lightmatter。Lightmatter是由幾位光子學專家創立的,總部位于美國波士頓。Lightmatter正在打造一種AI微處理器,但不是由電信号驅動,而是由光束驅動的。目前,Lightmatter已經從GV、Spark Capital和Matrix Partners等投資方那裡籌集了3300萬美元,以實作這一願景。據Lightmatter稱,這種獨特的光技術讓晶片的性能比現有解決方案高10倍。

這個領域還有其他公司值得關注。兩家中國公司——地平線機器人(Horizon Robotics)和寒武紀科技(Cambricon Technologies),分别獲得了更多的融資和更高的市值。

位于美國帕洛阿爾托的SambaNova Systems公司也得到了豐厚的資金,且技術精湛,盡管有關SambaNova的細節仍然很少,但它的技術似乎特别适合自然語言處理。

其他值得注意的初創公司還包括:Graphcore、Wave Computing、Blaize、Mythic和Kneron。

不僅如此,很多科技巨頭也已經開始自主開發專用的AI晶片,例如上述的谷歌TPU。谷歌從2015年開始研發TPU,領先于技術曲線的發展;去年12月,亞馬遜大張旗鼓地公布了Inferentia AI;與此同時,特斯拉、Facebook和阿裡巴巴以及其他科技巨頭也都行動起來了,開始内部研發AI晶片。

總結

眼下,一場為即将而來的AI時代開發所需的硬體競争正在上演。如今,半導體行業的創新之多,是自矽谷創立之初以來從未有過的,巨量資金不斷地投入其中。

未來幾年,下一代晶片将塑造人工智能領域的雛形和軌迹。用Yann LeCun的話來說:“硬體能力...激勵但卻限制了AI研究人員想象并追求的想法。各種我們可以使用的工具正在不斷重新整理我們的想法,這一點我們不得不承認。”

【雲栖号線上課堂】每天都有産品技術專家分享!

課程位址:

https://yqh.aliyun.com/live立即加入社群,與專家面對面,及時了解課程最新動态!

【雲栖号線上課堂 社群】

https://c.tb.cn/F3.Z8gvnK

原文釋出時間:2020-05-11

本文來自:“

科技行者”,了解相關資訊可以關注“

”