作者:言楓、虞晖華、蔣溢軒、蒽竹、水德、千訣

對話管理模型背景

從人工智能研究的初期開始,人們就緻力于開發高度智能化的人機對話系統。艾倫·圖靈在1950年提出圖靈測試[1],認為如果人類無法區分和他對話交談的是機器還是人類,那麼就可以說機器通過了圖靈測試,擁有高度的智能。第一代對話系統主要是基于規則的對話系統,例如1966年MIT開發的ELIZA系統[2]是一個利用模版比對方法的心理醫療聊天機器人,再如1970年代開始流行的基于流程圖的對話系統,采用有限狀态自動機模型模組化對話流中的狀态轉移。它們的優點是内部邏輯透明,易于分析調試,但是高度依賴專家的人工幹預,靈活性和可拓展性很差。

随着大資料技術的興起,出現了基于統計學方法的資料驅動的第二代對話系統(以下簡稱統計對話系統)。在這個階段,增強學習也開始被廣泛研究運用,其中最具代表性的是劍橋大學Steve Young教授于2005年提出的基于部分可見馬爾可夫決策過程(Partially Observable Markov Decision Process , POMDP)的統計對話系統[3]。該系統在魯棒性上顯著地優于基于規則的對話系統,它通過對觀測到的語音識别結果進行貝葉斯推斷,維護每輪對話狀态,再根據對話狀态進行對話政策的選擇,進而生成自然語言回複。POMDP-based 對話系統采用了增強學習的架構,通過不斷和使用者模拟器或者真實使用者進行互動試錯,得到獎勵得分來優化對話政策。統計對話系統是一個子產品化系統,它避免了對專家的高度依賴,但是缺點是模型難以維護,可拓展性也比較受限。

近些年,伴随着深度學習在圖像、語音及文本領域的重大突破,出現了以運用深度學習為主要方法的第三代對話系統,該系統依然延續了統計對話系統的架構,但各個子產品都采用了神經網絡模型。由于神經網絡模型表征能力強,語言分類或生成的能力大幅提高,是以一個重要的變化趨勢是自然語言了解的模型從之前的産生式模型(如貝葉斯網絡)演變成為深度鑒别式模型(如CNN、DNN、RNN)[5],對話狀态的擷取不再是利用貝葉斯後驗判決得到,而是直接計算最大條件機率。在對話政策的優化上大家也開始采用深度增強學習模型[6]。另一方面,由于端到端序列到序列技術在機器翻譯任務上的成功,使得設計端到端對話系統成為可能,Facebook研究者提出了基于記憶網絡的任務對話系統[4],為研究第三代對話系統中的端到端任務導向型對話系統提出了新的方向。總的來說,第三代對話系統效果優于第二代系統,但是需要大量帶标注資料才能進行有效訓練,是以提升模型的跨領域的遷移拓展能力成為熱門的研究方向。

常見的對話系統可分為三類:聊天型,任務導向型和問答型。聊天型對話的目标是要産生有趣且富有資訊量的自然回複使得人機對話可以持續進行下去[7]。問答型對話多指一問一答,使用者提出一個問題,系統通過對問題進行解析和知識庫查找以傳回正确答案[8]。任務導向型對話(以下簡稱任務型對話)則是指由任務驅動的多輪對話,機器需要通過了解、主動詢問、澄清等方式來确定使用者的目标,調用相應的API查詢後,傳回正确結果,完成使用者需求。通常,任務型對話可以被了解為一個序列決策過程,機器需要在對話過程中,通過了解使用者語句更新維護内部的對話狀态,再根據目前的對話狀态選擇下一步的最優動作(例如确認需求,詢問限制條件,提供結果等等),進而完成任務。

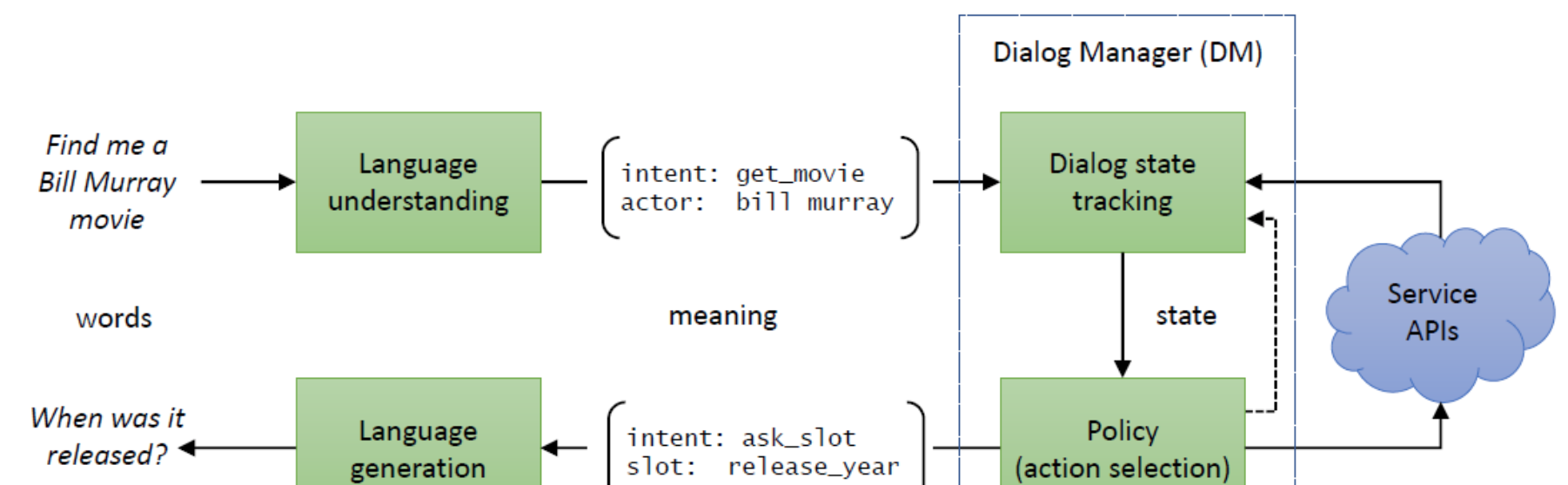

任務型對話系統從結構上可分成兩類,一類是 pipeline系統,采用子產品化結構[5](如圖 1),一般包括四個關鍵子產品:

- 自然語言了解(Natural Language Understanding, NLU):對使用者的文本輸入進行識别解析,得到槽值和意圖等計算機可了解的語義标簽。

- 對話狀态跟蹤(Dialog State Tracking, DST):根據對話曆史,維護目前對話狀态,對話狀态是對整個對話曆史的累積語義表示,一般就是槽值對(slot-value pairs)。

- 對話政策(Dialog Policy):根據目前對話狀态輸出下一步系統動作。一般對話狀态跟蹤子產品和對話政策子產品統稱為對話管理子產品(Dialog manager, DM)。

- 自然語言生成(Natural Language Generation, NLG):将系統動作轉換成自然語言輸出。

這種子產品化的系統結構的可解釋性強,易于落地,大部分業界的實用性任務型對話系統都采用的此結構。但是其缺點是不夠靈活,各個子產品之間相對獨立,難以聯合調優,适應變化的應用場景。并且由于子產品之間的誤差會層層累積,單一子產品的更新也可能需要整個系統一起調整。

圖 1. 任務導向型對話系統的子產品化結構[41]

任務型對話系統的另一種實作是端到端系統,也是近年來學界比較熱門的方向9[11](如圖 2),這類結構希望訓練一個從使用者端自然語言輸入到機器端自然語言輸出的整體映射關系,具有靈活性強、可拓展性高的特點,減少了設計過程中的人工成本,打破了傳統子產品之間的隔離。然而,端到端模型對資料的數量和品質要求很高,并且對于填槽、API調用等過程的模組化不夠明确,現階段業界應用效果有限,仍處在探索中。

圖 2. 任務導向型對話系統的端到端結構[41]

随着使用者對産品體驗的要求逐漸提高,實際對話場景更加複雜,對話管理子產品也需要更多的改進和創新。傳統的對話管理模型通常是建立在一個明确的話術體系内(即先查找再問詢最後結束),一般會預定義好系統動作空間、使用者意圖空間和對話本體,但是實際中使用者的行為變化難測,系統的應答能力十分有限,這就會導緻傳統對話系統可拓性差的問題(難以處理預定義之外的情況)。另外,在很多的真實業界場景,存在大量的冷啟動問題,缺少足量的标注對話資料,資料的清洗标注成本代價高昂。而在模型訓練上,基于深度增強學習的對話管理模型一般都需要大量的資料,大部分論文的實驗都表明,訓練好一個對話模型通常需要幾百個完整的對話session,這樣低下的訓練效率阻礙了實際中對話系統的快速開發和疊代。

綜上,針對傳統對話管理模型的諸多局限,近幾年學界和業界的研究者們都開始将焦點放在如何加強對話管理模型的實用性上,具體來說有三大問題:

1. 可拓展性差

2. 标注資料少

3. 訓練效率低

我們将按照這三個方向,為大家介紹近期最新的研究成果。

對話管理模型研究前沿介紹

對話管理模型痛點一 --- 可拓展性差

如前文所述,對話管理器由兩部分組成:對話狀态跟蹤器(DST)和對話政策(dialog policy)。傳統的DST研究中,最具代表的是劍橋大學的學者們在2017年提出的神經信度跟蹤模型(neural belief tracker, NBT)[12],利用神經網絡來解決單領域複雜對話的對話狀态跟蹤問題。NBT 通過表征學習(representation learning)來編碼上輪系統動作、本輪使用者語句和候選槽值對,在高維空間中計算語義的相似性,進而檢測出本輪使用者提到的槽值。是以NBT可以不依賴于人工建構語義詞典,隻需借助槽值對的詞向量表示就能識别出訓練集未見但語義上相似的槽值,實作槽值的可拓展。後續地,劍橋學者們對NBT進一步改進13,将輸入的槽值對改成領域-槽-值三元組,每輪識别的結果采用模型學習而非人工規則的方法進行累積,所有資料采用同一個模型訓練,進而實作不同領域間的知識共享,模型的總參數也不随領域數目的增加而增加。在傳統的Dialogue Policy研究領域中,最具代表性的是劍橋學者們6提出的基于ACER方法的政策優化。通過結合 Experience replay 技巧,作者分别嘗試了trust region actor-critic 模型和episodic natural actor-critic 模型,驗證了AC系列的深度增強學習算法在樣本利用效率、算法收斂性和對話成功率上都達到了當時最好的表現。

然而傳統的對話管理模型在可拓展性方面仍需改進,具體在三個方面:1)如何處理變化的使用者意圖,2)如何變化的槽位和槽值,3)如何處理變化的系統動作。

變化的使用者意圖

在實際應用場景中,時常會出現由于使用者意圖未被考慮到,使得對話系統給出不合理回答的情況。如圖 3所示的例子,使用者的“confirm”意圖未被考慮,這時就需要加入新的話術來幫助系統處理這樣的情況。

圖 3. 出現新意圖的對話執行個體[15]

一旦出現訓練集未見的新使用者意圖時,傳統模型由于輸出的是表示舊意圖類别的固定one-hot向量,若要包含新的意圖類别,向量就需要進行改變,對應的新模型也需要進行完全的重訓練,這種情況會降低模型的可維護性和可拓展性。論文[15]提出了一種“老師-學生”的學習架構來緩解這一問題,他們将舊模型和針對新使用者意圖的邏輯規則作為“老師”,新模型作為“學生”,構成一個“老師-學生”訓練架構。該架構使用了知識蒸餾技術,具體做法是:對于舊的意圖集合,舊模型的機率輸出直接指導訓練新模型;對于新增的意圖,對應的邏輯規則作為新的标注資料來訓練新模型。這樣就使得在新模型不再需要與環境進行新的互動重新訓練了。論文在DSTC2資料集上進行實驗,首先選擇故意去掉 confirm 這個意圖,然後再将它作為新意圖加入對話本體中,依次驗證新模型是否具有很好的适應能力。圖 4 是實驗結果,論文新模型(即Extended System)、直接在包含所有意圖的資料訓練的模型(即 Contrast System)和舊模型進行比較,實驗證明新模型對新意圖的識别正确率在不同噪聲情況下都不錯的擴充識别新意圖的能力。

圖 4. 不同噪聲設定下各種模型的比較

當然這種架構仍然需要對系統進行一定的訓練,[16] 提出一種語義相似性比對的模型CDSSM能夠在不依賴于标注資料以及模型重新訓練的前提下,解決使用者意圖拓展的問題。CDSSM先利用訓練集資料中使用者意圖的自然描述直接學習出一個意圖向量(intent embedding)的編碼器,将任意意圖的描述嵌入到一個高維語義空間中,這樣在測試時模型可以直接根據新意圖的自然描述生成對應的意圖向量,進而再做意圖識别。在後面的内容我們可以看到,有很多提高可拓展性的模型均采用了類似的思想,将标簽從模型的輸出端移到輸入端,利用神經網絡對标簽 (标簽命名本身或者标簽的自然描述) 進行語義編碼得到某種語義向量再進行語義相似性的比對。

[43]則給出了另外一種思路,它通過人機協同的方式,将人工客服的角色引入到系統線上運作的階段來解決訓練集未見的使用者意圖的問題。模型利用一個額外的神經判決器根據目前模型提取出來的對話狀态向量來判斷是否請求人工,如果請求則将目前對話分發給線上人工客服來回答,如果不請求則由模型自身進行預測。由于通過資料學習出的判決器有能力對目前對話是否包含新意圖作一定的判斷,同時人工的回複預設是正确的,這種人機協同的方式十分巧妙地解決了線上測試出現未見使用者行為的問題,并可以保持比較高對話準确率。

變化的槽位和槽值

在多領域或複雜領域的對話狀态跟蹤問題中,如何處理槽位與槽值的變化一直是一個難題。對于有的槽位而言,槽值可能是不可枚舉的(這裡指槽值沒有限制,或可取值過多),例如時間、地點和人名;甚至槽值集合是動态變化的,例如航班、電影院上映的電影。在傳統的對話狀态跟蹤問題中,通常預設槽位和槽值的集合固定不變,這樣就大大降低了系統的可拓展性。

針對槽值不可枚舉的問題,谷歌研究者[17]提出了一個候選集(candidate set)的思路。對每個槽位,都維護一個有總量上限的候選集,它包含了對話截止目前最多k個可能的槽值,并賦于每個槽值一個分數以表示使用者在目前對話中對該槽值的偏好程度。系統先利用雙向RNN模型找出本輪使用者語句包含的中某個槽位的槽值,再将它和候選集中已有的槽值進行重新打分排序,這樣每輪的DST就隻需在一個有限的槽值集合上進行判決,進而解決不可枚舉槽值的跟蹤問題。針對未見槽值的跟蹤問題,一般可以采用序列标注的模型[18],或者選擇神經信度跟蹤器[12]這樣的語義相似比對模型。

以上是槽值不固定的情況,如果對話本體中槽位也變化呢?論文[19]采用了槽位描述編碼器(slot description encoder),對任何槽(已見的、未見的)的自然語言描述進行編碼,得到表示該槽的語義向量,和使用者語句一起作為輸入送入Bi-LSTM模型中,采用序列标注的方式輸出識别到的槽值,見圖 5。該論文做了一個可接受的假設,即任何槽的自然語言描述是很容易得到的,是以設計了一個在多個領域具有普适性的概念标注器(Concept Tagger)結構,槽描述編碼器的實作是簡單的詞向量之和。實驗表明,該模型能迅速适應新的槽位,相較于傳統方法,該方法的可拓展性有很大的提升。

圖 5. 概念标注器結構

随着近幾年序列到序列技術的發展,直接利用端到端神經網絡模型将DST的結果作為一個序列生成出來也是一個很熱門的方向,常見的技巧如注意力機制(attention mechanism)、拷貝機制(copy mechanism)均可以用來提高生成效果。在著名的多領域對話MultiWOZ資料集上,來自港科大的Pascale Fung 教授團隊利用了拷貝網絡,顯著提高了不可枚舉槽的識别精度 [20]。他們提出的TRADE 模型如圖 6所示,每次檢測槽值時,模型會将領域和槽位的不同結合進行語義編碼作為RNN解碼器的初始位置輸入,解碼器通過拷貝網絡,直接将對應的槽值生成出來。通過生成的方式,無論是不可枚舉的槽值,還是變化的槽位的槽值,都能使用同一個模型完成,這可以做到領域間槽值資訊的共享,也大大地提高了模型的泛化能力。

圖 6. TRADE模型架構

最近一個明顯的趨勢是将多領域DST看作一個機器閱讀了解的任務,将TRADE這種生成式模型改進成鑒别式模型45。不可枚舉槽的追蹤利用類似SQuAD的機器閱讀了解任務[46],從對話曆史和提問中找到對應的 text span作為槽值,而可枚舉槽的追蹤則轉化成一個多項選擇的機器閱讀了解任務,從候選值中選擇正确的值作為預測出的槽值。通過結合ELMO,BERT等深度上下文詞表示,這些新提出的模型最終在MultiWOZ資料集上取得目前最好結果。

變化的系統動作

可拓展性問題的最後一個方面在于系統動作空間難以預定義。如圖 7所示,在設計一個電子産品推薦系統時,也許一開始并不會考慮到使用者會問到如何更新産品作業系統這樣的問題,但現實的情況是你無法限定使用者隻問系統能解決的問題。如果系統動作空間事先框定,在使用者提出新問題時就會導緻一連串的答非所問,導緻極差的使用者體驗。

圖 7. 對話系統遇到未考慮的系統動作時的對話案例[22]

對此,我們需要考慮的是,如何設計更好的對話政策網絡,使得系統能夠快速的擴充新的動作。首先的嘗試來自微軟[21],他們試圖通過改變經典的DQN結構來實作系統在不受限動作空間上的增強學習。論文的對話任務是一個文字遊戲闖關任務,每輪的動作是一句話,動作數目不定,選擇不同的動作故事情節就會有不同的發展。作者提出了新的模型Deep Reinforcement Relevance Network (DRRN),通過語義相似性比對的方式将目前的對話狀态和各個可選的系統動作一一比對得到Q函數。具體來看:某輪對話時,每個長度不定的動作文本會經過神經網絡編碼得到固定長度的系統動作向量,故事背景文本經過另一個神經網絡也得到固定長度的的對話狀态向量,兩個向量通過互動函數(如點積)生成最後的Q值。圖 8是論文設計模型結構。實驗表明,在“Saving John”和“Machine of Death”兩個文字遊戲上DRRN比傳統DQN(使用padding技巧)的表現更加優異。

圖 8. DRRN模型。t輪有兩個候選動作,t+1輪有三個候選動作。

論文[22]則希望從對話系統整體的角度來解決這個問題,作者提出了增量學習對話系統(Incremental Dialogue System, IDS),如圖 9所示。首先系統通過Dialogue Embedding 子產品對對話曆史編碼得到上下文向量,再利用一個基于VAE的Uncertainty Estimation子產品根據上下文向量對目前系統能否給出正确回答進行一個置信度的評估。類似于主動學習的方式,若置信度高于門檻值,則由對話管理器對目前所有可選動作一一打分,經過softmax函數預測出機率分布,若置信度低于門檻值,則請求标注人員對本輪的回複進行标注(選擇正确回複或建立新的回複),得到了新資料并入資料池裡一起線上更新模型。通過這種人類教學(human-teaching)的方式,IDS系統不僅解決了不受限動作空間的學習問題,還可以快速地收集高品質的資料,十分貼近實際生産應用。

圖 9. IDS的對話系統整體架構圖

對話管理模型痛點二 --- 标注資料少

随着對話系統應用領域的多樣化,對資料的需求也更加多樣化,若想訓好一個任務型對話系統,通常都需要盡可能多的該領域的資料,但一般來說,想要擷取高品質的有标注資料的成本很高。為此學者們進行了各種研究嘗試,主要可分為三種思路:1) 用機器自動标注資料,降低資料标注的成本;2) 對話結構挖掘,盡可能高效利用無标注資料;3) 加強資料采集政策,高效擷取優質的資料。

機器自動标注

由于人工标注資料的代價大、效率低,學者們希望通過機器輔助人工來标注資料,方法大緻可分為兩大類:有監督方法和無監督方法。論文[23]提出一種架構auto-dialabel,用層次聚類的無監督學習方法将對話資料中的意圖和槽位自動分組,進而實作對話資料的自動标注(類别的具體标簽需要人工來定)。該方法是基于一個假設:相同意圖的表達可能會共享相似的背景特征。模型提取的初始特征包括詞向量、POS 标注、名詞詞簇和LDA 四種特征。各個特征經由自編碼器轉成相同次元的向量後進行拼接,再采用RBF(radial bias function)函數計算類間距離進行動态的層次聚類。距離最近的類将會自動合并,直到類間距離大于預設的門檻值停止。模型架構如圖 10所示。

圖 10. Auto-dialabel 模型

論文[24]則采用有監督聚類的方法來實作機器标注。作者将每條對話資料看作是一個個圖節點,将聚類的過程看作是找出最小生成森林的過程。模型首先采用SVM在問答資料集上有監督訓練出節點和節點之間的距離得分模型,再結合結構化模型和最小子樹生成算法來将對話資料對應的類别資訊作為隐變量推斷出來,進而輸出最佳的聚類結構表示使用者意圖類别。

對話結構挖掘

由于訓練對話系統的高品質帶标注資料稀缺,如何充分地挖掘無标注對話資料中隐含的對話結構或資訊也成為了當今的研究熱點之一,隐含的對話結構或資訊在一定程度上有助于對話政策的設計和對話模型的訓練。

論文[25]提出了一種用變分循環神經網絡(variational RNN, VRNN)的無監督方法自動學習對話資料中的隐藏結構。作者給出兩種模型來擷取對話中的動态資訊:Discrete-VRNN和Direct-Discrete-VRNN。如圖 11所示,$x_t$是第t輪對話,$h_t$表示對話曆史隐變量,$z_t$表示對話結構隐變量(一維one-hot離散變量)。兩種模型的差别在于:對于D-VRNN,隐變量$z_t$取決于$h_{t-1}$;而對于DD-VRNN,隐變量$z_t$取決于$z_{t-1}$。VRNN通過最大整個對話的似然值,利用VAE的一些常用技巧,估計出隐變量$z_t$的後驗機率分布。

圖 11. Discrete-VRNN(D-VRNN)與Direct-Discrete-VRNN(DD-VRNN)的示意圖

論文實驗表明VRNN 要優于傳統的HMM的方法,同時将對話結構的資訊加入到獎勵函數中,也有助于增強學習模型更快地收斂。圖 12 是經過D-VRNN 挖掘出的餐館領域的隐變量z_t轉移機率的可視化圖。

圖 12. D-VRNN 對餐館領域的對話資料挖掘出的對話流結構

CMU學者[26]也嘗試利用VAE的方法,将系統動作作為隐變量推斷出來直接用于對話政策的選擇,這樣就能減輕預定義系統動作不夠全面帶來的問題。如圖 13所示,為了簡便起見,論文采用端到端的對話系統架構,基線模型是字級别的增強學習模型(即對話動作是詞表中的詞),通過encoder将對話曆史編碼,再利用decoder解碼生成對話回複,獎勵函數直接通過比對生成的對話回複語句和真實對話回複語句得到。作者提出的隐動作模型和基線模型的差別是encoder到decoder之間多了離散隐變量的後驗推理,對話動作由離散隐變量表示,沒有任何人為的幹預定義。最終實驗證明,基于隐動作的端到端增強學習模型在語句生成的多樣性和任務完成率上均超過了基線模型。

圖 13. 基線模型和隐動作模型

資料采集政策

最近,谷歌研究者們提出了一種快速收集對話資料的方法[27](見圖 14):首先利用兩個基于規則的模拟器互動生成對話的outline,即用語義标簽表示的對話流骨架;然後利用模闆将語義标簽轉寫為自然語言對話;最後利用衆包對自然語句進行改寫,使得對話資料的語言表達更加豐富多樣。這種反向收集資料方法不僅收集效率高,而且資料标注完整、可用性強,避免了收集領域資料的成本花費和大量的人工處理。

圖 14. 對話outline,模闆生成對話以及衆包重寫對話的示例

上述方法屬于機器-機器(machine-to-machine, M2M)的資料收集政策:先生成覆寫面廣的對話資料語義标簽,再衆包生成大量對話語料。其缺點在于,生成的對話相對局限,不能涵蓋真實場景的所有可能性,并且效果依賴于模拟器的好壞。

學界還有另外兩種常用于對話系統資料收集的方法:人-機對話(human-to-machine, H2M)和人-人對話(human-to-human, H2H)。H2H 方法要求使用者(由衆包人員扮演)和客服(由另一衆包人員扮演)進行多輪對話,使用者負責基于某些指定的對話目标(例如買機票)提需求,客服負責标注對話标簽和建立對話回複。這種模式被稱為 Wizard-of-Oz 架構,對話研究的諸多資料集如 WOZ[5], MultiWOZ[28]均采用此方式收集。H2H 方法可以得到最貼近實際業務場景的對話資料,但是需要為了不同的任務需要設計不一樣的互動界面,而且需要耗費大量人力清理錯誤的标注,成本相當昂貴。H2M 的資料收集政策則是讓使用者和訓練到一定程度的機器直接進行對話線上收集資料,并且利用增強學習不斷改進對話管理模型,著名的 DSTC2&3 資料集就是通過這種方法收集得到。H2M 方法的效果總體比較依賴于對話管理模型的初始效果,并且線上收集的資料噪聲較大,清理成本也會較高,影響模型優化的效率。

對話管理模型痛點三 --- 訓練效率低

随着深度增強學習在遊戲圍棋領域的大獲成功,該方法在任務導向型對話領域也有廣泛應用。例如論文[6]的ACER對話管理方法,使用了model-free 深度增強學習,通過結合Experience Replay、信度域限制、預訓練等技巧,大大提高了增強學習算法在任務型對話領域的訓練效率和穩定性。

然而,簡單地套用增強學習算法并不能滿足對話系統的實際應用。這主要是因為對話領域不像遊戲圍棋那樣有清晰的規則、獎勵函數,動作空間簡單明确,還有完美的環境模拟器可以生成數以億計的高品質互動資料。對話任務中,一般包括了多樣變化的槽位槽值和動作意圖,這使得對話系統的動作空間急劇增大且難以預定義。傳統扁平的增強學習(flat reinforcement learning)方法由于對所有的系統動作進行one-hot編碼,會存在次元災難,是以不再适用于處理動作空間非常大的複雜對話問題,為此學者們進行了諸多研究嘗試,包括model-free RL、model-based RL和human-in-the-loop三個方向。

Model-free 增強學習–分層增強學習

分層增強學習(Hierarchical Reinforcement Learning, HRL)基于“分而治之”的理念,将複雜任務分解成多個子任務(sub-task),解決了傳統扁平的增強學習的次元災難。論文[29]首次将分層增強學習(HRL)應用到任務導向型對話領域,作者利用專家知識把複雜的對話任務在時序次元上拆分成多個子任務,例如一個複雜的旅行問題可以分解為訂機票、訂酒店、租車等子問題。根據這個拆分,他們設計了兩個層次的對話政策網絡,一個層次負責選擇和安排所有的子任務,另一個層次負責具體子任務的執行。

他們提出的對話管理模型(如圖 15 所示)包括:1)頂層政策(top-level policy),用于根據對話狀态選擇子任務;2)底層政策(low-level policy),用于完成子任務的具體的某個對話動作;3)全局對話狀态追蹤,記錄整體對話狀态。整個對話任務完成之後,頂層政策會收到外部獎勵(external reward)。除此以外,模型還新增了内部評定子產品(internal critic),用于根據對話狀态估計子任務完成的可能性(子任務的填槽程度),底層政策會根據子任務完成程度收到内部評定子產品的一個内部獎勵(intrinsic reward)。

圖 15. 任務型對話系統的分層增強學習架構

面對複雜的對話問題,傳統的增強學習的每一步決策都在選擇基本系統動作,比如詢問槽值或者确認限制,而分層增強學習的先通過頂層政策選擇一大類基本動作的集合,再通過底層政策選擇目前集合的基本動作,流程如圖 16所示。這種對動作空間的層次劃分,能夠考慮到不同子任務之間的時序限制關系,有助于完成複合對話任務(composite task)。并且論文通過加入内部獎勵的方式,有效緩解了獎勵稀疏的問題,加快了增強學習的訓練,也在一定程度上避免了對話在不同子任務之間頻繁切換,提高了動作預測準确率。當然動作的分層設計比較依賴專家知識,需要通過專家來确定子任務的種類,近期相應地出現了一些對話子任務自動發現的工作30,通過無監督的方法,對整個對話曆史的對話狀态序列進行自動切分,進而避免人工建構對話子任務結構。

圖 16. 分層增強學習的政策選擇流程示意圖

Model-free 增強學習–封疆增強學習

封疆增強學習(Feudal Reinforcement Learning, FRL)是另一種适用于大次元問題的增強學習方法。分層增強學習是把對話政策按照時間次元上的不同任務階段劃分成子政策,進而降低政策學習的複雜度;而封疆增強學習(FRL)是在空間次元上把政策進行劃分,限制子政策負責的動作範圍,劃分了“管轄疆域”,進而降低子政策的複雜度。封疆增強學習(FRL)不劃分子任務,而是應用了狀态空間的抽象化函數,從對話狀态中提取有用的特征。這種抽象化有利于封疆增強學習(FRL)在大型問題中的應用以及在不同領域之間的遷移,具有較強的擴充性。

劍橋學者們首次将封疆增強學習[32]運用到任務導向對話系統領域,将動作空間按照是否和槽位相關來進行劃分,這樣隻利用了動作空間的自然結構而不需要額外的專家知識。他們提出了如圖 17所示的封疆政策結構,該結構的決策過程分兩步:1)決定下一步動作是否需要槽位作為參數;2)根據第一步的決策,以及對應的不同槽位采用不同的底層政策選擇下一步動作。

圖 17. 封疆增強學習在任務導向型對話系統上的應用

總的來說,分層增強學習(HRL)與封疆增強學習(HRL)都是将高次元的複雜動作空間進行不同方式的拆分,以解決傳統 RL 動作空間次元大導緻訓練效率低的問題。分層增強學習(HRL)對任務的分割合理,比較符合人類的了解,但是需要專家知識來拆分子任務。封疆增強學習(FRL)對複雜問題的拆分則直接考慮其動作本身的邏輯結構,不考慮不同子任務之間的互相限制。

Model-based 增強學習

以上讨論的屬于無模型(model-free)增強學習,它是通過和環境互動試錯得到大量弱監督資料,再去訓練一個價值網絡或者政策網絡,而不關心環境本身。與之相對的是基于模型的(model-based)增強學習,它的學習過程如圖 18。其特點是對環境直接進行模組化,利用和環境互動得到的資料學習出一個狀态和獎勵的機率轉移函數,即環境模型,然後系統可以和環境模型互動産生更多的訓練資料,是以model-based增強學習一般比model-free增強學習的訓練效率要高,尤其是在和環境互動代價昂貴的場景。但其效果取決于環境模組化的好壞。

圖 18. model-based的增強學習的流程

采用 model-based 增強學習來提高訓練效率是最近研究熱點,微軟首先将經典的 Deep Dyna-Q(DDQ)算法應用到對話中[33],如圖 19c 所示,DDQ 訓練開始之前,先利用少量已有的對話資料對政策模型和環境模型(world model)進行預訓練,之後 DDQ的訓練不斷循環三個步驟:1)直接增強學習 --- 通過和真實使用者線上對話互動,更新政策模型并且儲存對話資料;2)訓練環境模型 --- 利用收集到的真實對話資料更新環境模型;3)規劃(planning)--- 利用和環境模型互動得到的對話資料來訓練政策模型。其中環境模型(如圖 20)是一個神經網絡,對環境的狀态轉換和獎勵進行機率模組化,輸入是目前對話狀态以及系統動作,輸出是下一輪使用者動作、環境獎勵和對話終止變量。環境模型使得 DDQ 降低了線上增強學習(如圖 19a)對人機互動資料量的需求,也避免了和使用者模拟器互動(如圖 19b)品質不高的問題。

圖 19. 三種不同增強學習架構

圖 20. 環境模型的結構

環境模型與對話領域中的使用者模拟器比較相似,它們都可以用于模拟真實使用者的動作并和系統的對話管理子產品互動。但兩者不同之處在于使用者模拟器本質是系統的外部環境,用于模拟真實使用者,環境模型是系統的一部分,屬于系統内部模型。

在DDQ的工作基礎上,微軟研究者們做了更多的擴充:為了提高環境模型産生的對話資料的真實性,他們提出[34]采用對抗訓練的思想提高對話資料的生成品質;針對何時使用和真實環境互動的資料,何時使用和環境模型互動的資料,論文[35]探讨了可行方案;為了将真人互動也納入進來,論文[36]給出了一個統一的對話架構。這種人類教學(human-teaching)的思想也是目前業界建構對話管理模型的關注熱點,我們在下小節給出更多闡述。

Human-in-the-loop

我們希望能充分引入人的知識經驗來生成高品質資料,提高模型訓練效率。Human-in-the-loop增強學習[37]就是一種将人類引入機器人訓練過程的方法,通過設計好的人機互動方式,人類可以高效地指導訓練增強學習模型。為了進一步提升任務導向對話系統的訓練效率,針對對話問題的特性設計有效的human-in-the-loop方式成為了研究人員新的探索方向。

圖 21. 監督式預訓練、模仿學習和線上增強學習結合的複合式學習

谷歌研究者提出了一種人類教學和增強學習結合的複合學習方法[37](如圖 21),在有監督預訓練和線上增強學習之間增加一個人類教學階段,讓人介入進來打标簽,避免了有監督預訓練導緻的covariate shift 問題[42]。亞馬遜研究者也提出一種類似的人類教學架構[37]:每輪對話中,系統都推薦4條回複供客服專家選擇;然後客服專家決定是選擇4條回複中的一條,還是另外編輯新的回複;最後由客服專家把選擇好或者編輯好的回複發給使用者。利用這種方式,開發人員可以快速地更新對話系統能力,适合落地。

以上是系統被動地接受人對資料進行标注,但是好的系統也應該學會主動提問、尋求人的幫助。論文[40]提出了陪伴式學習(companion learning)的架構(如圖 22),在傳統的增強學習架構中加入老師的角色(即人),老師可以糾正對話系統(即學生)的回複(圖左側開關),也能以内部reward的形式對學生的回複進行評價(圖右側開關)。對于主動學習的實作,作者提出了對話決策确信度(decision certainty)的概念,通過dropout技巧對學生政策網絡進行多次采樣,得到可取動作的最大機率近似估計,再通過計算該最大機率的若幹對話輪次的滑動平均值作為學生政策網絡的決策确信度。确信度若低于目标值,則根據确信度與目标值的差距,決定老師是否參與進來糾正錯誤和提供獎勵函數,确信度高于目标值,則停止向老師學習,系統自行進行判決。

圖 22. 老師糾正學生的回複(左側開關)或者對學生的回複做出評價(右側開關)

主動學習的關鍵在于估計出對話系統對自身決策的确信程度,除了上述對政策網絡進行dropout的方法,還有以隐變量為條件變量,計算政策網絡分布Jensen-Shannon散度的方法[22]、根據目前系統對話成功率做判斷的方法[36]。

小蜜Conversational AI團隊的對話管理架構

為了保證穩定性和可解釋性,目前業界對話管理子產品多采用基于規則的方法。阿裡巴巴-達摩院-小蜜Conversational AI團隊在去年就開始嘗試對話管理模型化的工作,并進行了深入地探索。在真實的對話系統建設中,我們需要解決兩個問題:1)如何獲得特定場景的大量對話資料,2)怎麼利用算法充分發揮資料的價值?

對于整個模型化的架構設計,目前我們規劃成四步走的路線(如圖 23所示):

圖 23. 對話管理模型化四步走路線

第一步,先利用小蜜Conversational AI團隊自主研發的對話工廠(dialog studio)快速建構一個基于規則對話流的對話引擎(稱為TaskFlow),同時用類似的對話流去建構一個使用者模拟器。在建構好使用者模拟器和對話引擎之後,兩者采用M2M方式持續互動沉澱出大量的對話資料。

第二步,有了一定量的對話資料後,我們再利用有監督學習訓練一個神經網絡,建構和規則對話引擎能力基本相當的對話管理模型,實作對話管理的初步模型化。模型的設計采用語義相似比對和端到端生成兩種方法結合來實作可拓展性,對于動作空間較大的對話任務采用HRL進行動作劃分。

第三步,有了初步的對話管理模型,在開發階段,我們讓系統和改進的使用者模拟器或人工智能訓練師進行互動,通過off-policy ACER增強學習算法讓系統的對話能力持續地增強。

第四步,人機對話體驗達到初步實用之後,就可以上線運作,引入人的因素,收集使用者真實互動資料,同時通過一些UI設計友善地引入使用者的回報,持續不斷地更新強化模型。沉澱出大量人機對話資料也會進一步進行做資料分析和挖掘,用于客戶洞察。

目前,我們打造的基于增強學習的對話管理模型,在訂會議室這種中等複雜規模的對話任務上,和使用者模拟器互動的對話完成率可達80%,如圖24所示。

圖 24. 小蜜Conversational AI團隊的對話管理模型架構和評價結果

總結

本綜述圍繞對話管理(Dialog Management, DM)模型的最新前沿研究做了一個詳細的介紹,針對傳統對話管理的痛點劃分了三個大的方向:1)可拓展性差 2)标注資料少 3)訓練效率低。在可拓展性方面,我們介紹了處理變化的使用者意圖、對話本體、系統動作空間的常用方法,主要有語義相似比對方法、知識蒸餾方法和序列生成方法;對于标注資料稀缺問題,我們介紹了機器自動标注、對話結構有效挖掘和資料高效收集政策三部分内容;而針對傳統DM中RL模型訓練效率低下的問題,學界有嘗試引入HRL、FRL等方法對動作空間進行層次劃分,也有利用model-based RL對環境進行模組化提高訓練效率,将human-in-the-loop引入對話系統訓練架構亦是當下十分活躍的研究方向。最後我們對阿裡巴巴-達摩院-小蜜Conversational AI團隊目前在DM模型化的進展做了一個比較詳細的彙報介紹,希望本綜述能為大家的對話管理研究提供一些啟發和思考。

參考文獻

[1]. TURING A M. I.—COMPUTING MACHINERY AND INTELLIGENCE[J]. Mind, 1950, 59(236): 433-460.

[2]. Weizenbaum J. ELIZA---a computer program for the study of natural language communication between man and machine[J]. Communications of the ACM, 1966, 9(1): 36-45.

[3]. Young S, Gašić M, Thomson B, et al. Pomdp-based statistical spoken dialog systems: A review[J]. Proceedings of the IEEE, 2013, 101(5): 1160-1179.

[4]. Bordes A, Boureau Y L, Weston J. Learning end-to-end goal-oriented dialog[J]. arXiv preprint arXiv:1605.07683, 2016.

[5]. Wen T H, Vandyke D, Mrksic N, et al. A network-based end-to-end trainable task-oriented dialogue system[J]. arXiv preprint arXiv:1604.04562, 2016.

[6]. Su P H, Budzianowski P, Ultes S, et al. Sample-efficient actor-critic reinforcement learning with supervised data for dialogue management[J]. arXiv preprint arXiv:1707.00130, 2017.

[7]. Serban I V, Sordoni A, Lowe R, et al. A hierarchical latent variable encoder-decoder model for generating dialogues[C]//Thirty-First AAAI Conference on Artificial Intelligence. 2017.

[8]. Berant J, Chou A, Frostig R, et al. Semantic parsing on freebase from question-answer pairs[C]//Proceedings of the 2013 Conference on Empirical Methods in Natural Language Processing. 2013: 1533-1544.

[9]. Dhingra B, Li L, Li X, et al. Towards end-to-end reinforcement learning of dialogue agents for information access[J]. arXiv preprint arXiv:1609.00777, 2016.

[10]. Lei W, Jin X, Kan M Y, et al. Sequicity: Simplifying task-oriented dialogue systems with single sequence-to-sequence architectures[C]//Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). 2018: 1437-1447.

[11]. Madotto A, Wu C S, Fung P. Mem2seq: Effectively incorporating knowledge bases into end-to-end task-oriented dialog systems[J]. arXiv preprint arXiv:1804.08217, 2018.

[12]. Mrkšić N, Séaghdha D O, Wen T H, et al. Neural belief tracker: Data-driven dialogue state tracking[J]. arXiv preprint arXiv:1606.03777, 2016.

[13]. ¬Ramadan O, Budzianowski P, Gašić M. Large-scale multi-domain belief tracking with knowledge sharing[J]. arXiv preprint arXiv:1807.06517, 2018.

[14]. Weisz G, Budzianowski P, Su P H, et al. Sample efficient deep reinforcement learning for dialogue systems with large action spaces[J]. IEEE/ACM Transactions on Audio, Speech and Language Processing (TASLP), 2018, 26(11): 2083-2097.

[15]. Wang W, Zhang J, Zhang H, et al. A Teacher-Student Framework for Maintainable Dialog Manager[C]//Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing. 2018: 3803-3812.

[16]. Yun-Nung Chen, Dilek Hakkani-Tur, and Xiaodong He, "Zero-Shot Learning of Intent Embeddings for Expansion by Convolutional Deep Structured Semantic Models," in Proceedings of The 41st IEEE International Conference on Acoustics, Speech, and Signal Processing (ICASSP 2016), Shanghai, China, March 20-25, 2016. IEEE.

[17]. Rastogi A, Hakkani-Tür D, Heck L. Scalable multi-domain dialogue state tracking[C]//2017 IEEE Automatic Speech Recognition and Understanding Workshop (ASRU). IEEE, 2017: 561-568.

[18]. Mesnil G, He X, Deng L, et al. Investigation of recurrent-neural-network architectures and learning methods for spoken language understanding[C]//Interspeech. 2013: 3771-3775.

[19]. Bapna A, Tur G, Hakkani-Tur D, et al. Towards zero-shot frame semantic parsing for domain scaling[J]. arXiv preprint arXiv:1707.02363, 2017.

[20]. Wu C S, Madotto A, Hosseini-Asl E, et al. Transferable Multi-Domain State Generator for Task-Oriented Dialogue Systems[J]. arXiv preprint arXiv:1905.08743, 2019.

[21]. He J, Chen J, He X, et al. Deep reinforcement learning with a natural language action space[J]. arXiv preprint arXiv:1511.04636, 2015.

[22]. Wang W, Zhang J, Li Q, et al. Incremental Learning from Scratch for Task-Oriented Dialogue Systems[J]. arXiv preprint arXiv:1906.04991, 2019.

[23]. Shi C, Chen Q, Sha L, et al. Auto-Dialabel: Labeling Dialogue Data with Unsupervised Learning[C]//Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing. 2018: 684-689.

[24]. Haponchyk I, Uva A, Yu S, et al. Supervised clustering of questions into intents for dialog system applications[C]//Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing. 2018: 2310-2321.

[25]. Shi W, Zhao T, Yu Z. Unsupervised Dialog Structure Learning[J]. arXiv preprint arXiv:1904.03736, 2019.

[26]. Zhao T, Xie K, Eskenazi M. Rethinking action spaces for reinforcement learning in end-to-end dialog agents with latent variable models[J]. arXiv preprint arXiv:1902.08858, 2019.

[27]. Shah P, Hakkani-Tur D, Liu B, et al. Bootstrapping a neural conversational agent with dialogue self-play, crowdsourcing and on-line reinforcement learning[C]//Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 3 (Industry Papers). 2018: 41-51.

[28]. Budzianowski P, Wen T H, Tseng B H, et al. Multiwoz-a large-scale multi-domain wizard-of-oz dataset for task-oriented dialogue modelling[J]. arXiv preprint arXiv:1810.00278, 2018.

[29]. Peng B, Li X, Li L, et al. Composite task-completion dialogue policy learning via hierarchical deep reinforcement learning[J]. arXiv preprint arXiv:1704.03084, 2017.

[30]. Kristianto G Y, Zhang H, Tong B, et al. Autonomous Sub-domain Modeling for Dialogue Policy with Hierarchical Deep Reinforcement Learning[C]//Proceedings of the 2018 EMNLP Workshop SCAI: The 2nd International Workshop on Search-Oriented Conversational AI. 2018: 9-16.

[31]. Tang D, Li X, Gao J, et al. Subgoal discovery for hierarchical dialogue policy learning[J]. arXiv preprint arXiv:1804.07855, 2018.

[32]. Casanueva I, Budzianowski P, Su P H, et al. Feudal reinforcement learning for dialogue management in large domains[J]. arXiv preprint arXiv:1803.03232, 2018.

[33]. Peng B, Li X, Gao J, et al. Deep dyna-q: Integrating planning for task-completion dialogue policy learning[J]. ACL 2018.

[34]. Su S Y, Li X, Gao J, et al. Discriminative deep dyna-q: Robust planning for dialogue policy learning.EMNLP, 2018.

[35]. Wu Y, Li X, Liu J, et al. Switch-based active deep dyna-q: Efficient adaptive planning for task-completion dialogue policy learning.AAAI, 2019.

[36]. Zhang Z, Li X, Gao J, et al. Budgeted Policy Learning for Task-Oriented Dialogue Systems. ACL, 2019.

[37]. Abel D, Salvatier J, Stuhlmüller A, et al. Agent-agnostic human-in-the-loop reinforcement learning[J]. arXiv preprint arXiv:1701.04079, 2017.

[38]. Liu B, Tur G, Hakkani-Tur D, et al. Dialogue learning with human teaching and feedback in end-to-end trainable task-oriented dialogue systems[J]. arXiv preprint arXiv:1804.06512, 2018.

[39]. Lu Y, Srivastava M, Kramer J, et al. Goal-Oriented End-to-End Conversational Models with Profile Features in a Real-World Setting[C]//Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 2 (Industry Papers). 2019: 48-55.

[40]. Chen L, Zhou X, Chang C, et al. Agent-aware dropout dqn for safe and efficient on-line dialogue policy learning[C]//Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing. 2017: 2454-2464.

[41]. Gao J, Galley M, Li L. Neural approaches to conversational AI[J]. Foundations and Trends® in Information Retrieval, 2019, 13(2-3): 127-298.

[42]. Ross S, Gordon G, Bagnell D. A reduction of imitation learning and structured prediction to no-regret online learning[C]//Proceedings of the fourteenth international conference on artificial intelligence and statistics. 2011: 627-635.

[43]. Rajendran J, Ganhotra J, Polymenakos L C. Learning End-to-End Goal-Oriented Dialog with Maximal User Task Success and Minimal Human Agent Use[J]. Transactions of the Association for Computational Linguistics, 2019, 7: 375-386.

[44]. Mrkšić N, Vulić I. Fully Statistical Neural Belief Tracking[C]//Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics (Volume 2: Short Papers). 2018: 108-113.

[45]. Zhou L, Small K. Multi-domain Dialogue State Tracking as Dynamic Knowledge Graph Enhanced Question Answering[J]. arXiv preprint arXiv:1911.06192, 2019.

[46]. Rajpurkar P, Jia R, Liang P. Know What You Don't Know: Unanswerable Questions for SQuAD[J]. arXiv preprint arXiv:1806.03822, 2018.

[47]. Zhang J G, Hashimoto K, Wu C S, et al. Find or Classify? Dual Strategy for Slot-Value Predictions on Multi-Domain Dialog State Tracking[J]. arXiv preprint arXiv:1910.03544, 2019.