維基百科對智能有如下定義:

智能是一種能夠感覺或推斷資訊,并将其作為知識留存下來,自适應地用于某種環境或上下文的能力。

人工智能(Artificial Intelligence)

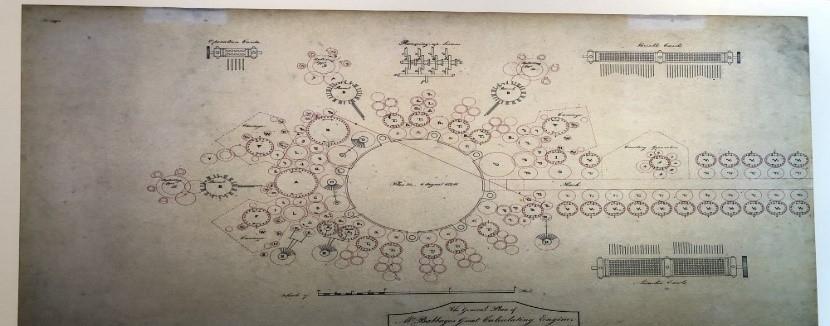

雖然我們很難對人工智能做一個确切的解釋,但可以從查爾斯巴貝奇的分析機講起。它雖然沒有任何特殊的“自适應”能力,但卻非常靈活。遺憾的是,理論上雖然完美,但卻沒有得以實作。

巴貝奇分析機早圖靈機50年左右出現。從理論上講,它能夠将任何可計算的函數作為輸入,并在完全機械的情況下産生輸出。

複雜性理論(complexity theory)由此得以發展,同時人們也意識到建構通用計算機其實相對簡單。此外,算法的實作也越發多樣。盡管還存在一些技術上的挑戰,但在過去的70年中,相同價格可購買到的計算量大約每兩年翻一番。

也就是說,建構計算力強大的人工智能系統越發容易。然而,這受到了所提供或輸入的資料,以及處理時間的限制。可以做如下思考:如果每台計算機的能力都受到資料和時間的限制,我們還能稱之為智能計算機麼?

下面我們簡單回顧一下人工智能的發展史。人類的智能主要包括歸納總結和邏輯演繹,對應着人工智能中的聯結主義(如人工神經網絡)和符号主義(如吳文俊方法)。符号主義認為智能是基于邏輯規則的符号操作;聯結主義認為智能是由神經元構成的資訊處理系統。其發展軌迹如下圖所示:

聯結主義,即“橙色陣營”在一開始處于領先地位,得益于其與神經科學和人類大腦之間的關系。人類大腦被視為“強AI(Strong Artificial Intelligence)”和“通用人工智能(Artificial General Intelligence,AGI)”唯一的成功應用。然而,第一代神經網絡在處理實際問題時屢屢受挫。因為神經網絡多數是線性的,并且能力十分有限,深受外界質疑。與此同時,符号主義,即“藍色陣營”利用嚴謹的數學理論創造出了更多有用的東西。

随着手工知識的積累,輸入或輸出資料量急速增長,系統的性能無法适應需求,聯結主義逐漸衰敗。就好比法律,專家制定出再完備的規則都有可能互相沖突,此時便需要越來越多的“法官”來解決這些問題。這減緩了聯結主義的發展。

後來,“橙色陣營”擷取了足夠的标簽資料和計算資源,能夠在可接受的時間内對網絡進行“訓練”,世界各地的研究學者開始進行大量試驗。盡管如此,聯結主義仍花費了大量的時間使大衆重新信任神經網絡,開發人員也花了較長才适應了模糊邏輯和統計的概念。

在對人工神經網絡進行詳細讨論前,本文将先介紹一些其它方法:決策樹、機率模型、進化算法。

決策樹(Decision Tree)是最簡單有效的算法之一。其“學習”是通過順序地周遊資料的每個屬性并找到對特定輸出具有最大預測能力的屬性來執行的。像随機森林這樣的進階變體使用了更複雜的學習技術,并在同一個模型中組合多個樹,它們的輸出是通過“投票”得到的,這與人類的“直覺”類似。

機率模型(Probabilistic models)是統計方法的代表。機率模型與神經網絡常共享架構、學習/優化過程甚至符号。但是機率模型大多受機率邏輯(通常是貝葉斯)的限制,而神經網絡則無此限制。

進化算法(Evolutionary computation)最初是受到生物進化的啟發,且以随機突變和适應度為主。由于修改通常是随機的,其限制噪聲的效果突出。進化算法是一種引導式搜尋,許多方面與退火過程類似。

上述方法有一個共同點:它們從較差的政策開始,逐漸對其改善,以期在某種性能評估方法中取得更好的分數。

如今,機器學習技術,尤其是深度學習正在主導人工智能的發展。與大多數使用1到2個中間抽象層(所謂的淺模型)機器學習方法不同,深度學習可能包含數百甚至數千個堆疊的可訓練層。

研究學者認為對這樣的深度網絡進行訓練,需要全新的優化程式。事實證明,使用梯度下降的逆向傳播(即鍊式法則)即可很好的進行訓練,也可使用Adam或RMSProp。

神經網絡訓練流程如下:

1、 擷取輸入

2、 計算輸出

3、 評估性能

4、 調節參數

5、 重複訓練,至性能最優

梯度下降法隻需調整參數使誤差最小。但該方法容易使網絡陷入局部最優,而沒有獲得最優性能。然而,最新研究表明許多神經網絡已經能夠擷取全局最優解。

深度學習實作了訓練的并行化,即分布式學習。能在同一時間跨多台機器訓練相同的體系結構,同時實作梯度交換,加速超過1000倍。

此外,經過訓練的網絡可以處理相似的任務,即遷移學習,這也是人工神經網絡廣泛流行的重要原因。例如,經過圖像分類訓練的網絡可以用于其他計算機視覺任務,自然語言處理和其他領域。更重要的是,同一個網絡還可以用來解決不同模式的問題。

強化學習(Reinforcement Learning,RL)則将它們結合在了一起。RL的最初想法來自行為心理學,科研人員探究了在行為心理學中獎勵如何影響學習和塑造動物的行為。

RL并不需要出現正确的輸入/輸出對,也不需要精确校正次優化的行為。舉個例子,我們并不需要教會機器人如何精确移動,隻需根據它走多遠或多快對其進行獎勵,它會自己找出正确的路線。然而,這種訓練模式在實踐中也是最具挑戰性的,即使是相對簡單的任務,通常也需要付出大量的努力才能正确設定。

在實際問題中,通常很難在環境中指定獎勵,研究人員目前更多地關注内部獎勵模型。

與RL并行的是逆向強化學習(Inverse Reinforcement Learning):當完成複雜的任務時,強化學習的回報函數很難指定,我們希望有一種方法能夠找到高效且可靠的回報函數,這種方法就是逆向強化學習。

通用人工智能中一些架構來自于嚴格的數學理論,一些受神經元回路的啟發,還有一些基于心理模型。本文将以HTM、AIXI、ACT-R和SOAR為例進行介紹。

層級實時記憶算法 (Hierarchical Temporal Memory,HTM),HTM算法旨在模拟新大腦皮層的工作原理,将複雜的問題轉化為模式比對與預測。它強調對“神經元”進行分層級,以及資訊模式的空間特性與時間特性。

稀疏分布表示(Sparse Distributed Representation, SDR)是HTM算法中的一個重要概念。實際上,它隻是擁有幾千個元素的位數組。就像大腦中的資訊總是通過億萬神經細胞中的小部分活躍細胞來表示一樣,HTM使用稀疏分布表示語義相關的輸入。

HTM算法中的抑制(Inhibition)類似于批規範化和其他一些正則化技術,提升(Boosting)在機器學習中已經是一個相對較老的概念,層次結構(Hierarchical Structure)并沒有真正的大腦皮層的結構靈活。HTM對物體間關系的重視程度低,甚至連稀疏分布表示也可以用普通神經網絡建構。總體來說,HTM需要進行大量調整才能擷取與其它機器學習算法相當的性能。

接下來介紹AIXI,它是一個對通用人工智能的理論上的數學形式化表示。然而,它有一個顯著的缺點——無法計算。事實上,許多機器學習算法均不能精确計算,隻能做近似處理。AIXI表示如下:

AIXI的核心是一個強化學習智能體,在諸多方面與Schmidhuber開發的Godel Machine類似。然而,它們都是AGI的描述性模型,複雜程度高,無法執行,但不可否認,它們都是人工智能研究人員的靈感源泉。

相反,ACT-R,即理性思維的自适應控制系統 (AdaptiveControl of Thought—Rational),它不僅是一種理論,而且是一種用LISP編寫的軟體架構。

ACT-R主要關注不同類型的記憶體,較少關注其中資料的轉換。該理論試圖了解人類如何獲得群組織知識以及如何産生智力活動,其研究進展基于神經生物學研究成果并從中得以驗證,且已成功地為許多不同認知現象建立起合理的模型。然而,它在實際應用中并未取得成功,最終隻作為研究人員的工具。SOAR與ACT-R有着相似的根源和基本假設,但它更關注于實作AGI,而不是建立人類認知的模型。

ACT-R和SOAR是人工智能符号主義的經典代表,在認知科學的發展中起到了重要作用,但是應用它們相比現代聯結主義需要更多的配置和先驗知識。此外,神經影像和其他用于心智研究的工具越發詳細和準确,而且ACT-R和SOAR在某一定程度上過于僵化,無法保持相關性。

作者資訊

Egor Dezhic

本文由阿裡雲雲栖社群組織翻譯。

文章原标題《What is Intelligence?》,譯者:Elaine,審校:袁虎。

文章簡譯,更為詳細的内容,請檢視

原文。