對于技術人員而言,每年的雙11都是一次技術盛宴,是對系統性能的極緻挑戰,對系統穩定性的終極考驗。從2009到2018這十年間,交易額達到今天的2135億,每秒訂單建立的峰值也是屢創新高,對于攻城獅來說,這不僅僅是數字的飛躍和世界記錄的重新整理。今天這個超級數字的背後,是交易、搜尋,到中間件、存儲、資料庫等等這些龐大分布式系統的計算和IO能力的飛躍。而支撐這些系統能力高速不間斷運轉的,則是底層網絡技術。

資料中心網絡作為這些大型分布式系統内部的高速公路,越來越多的承載着計算和存儲系統IO延伸的作用,網絡即IO。更高的帶寬、更低延時才能給業務系統帶來更加極緻的性能表現。

2018年雙11,阿裡巴巴資料中心網絡的主角,是阿裡巴巴全新一代網絡架構5.1,架構的項目代号為HAIL(1.0版本,後續還有region級别的架構演進HAIL2.0)。

HAIL代表“High Availability、Intelligence, and Low latency”,是5.1網絡架構設計核心思想和目标的最直白展現。其中,RDMA、去堆疊、流量可視化 等是HAIL 5.1網絡架構的核心關鍵詞。

High Intelligence依托于network telemetry技術和自動化平台的能力建構了整個5.1資料中心網絡架構自動化和智能化基石。關于這些方面,HAIL 5.1架構中有很多業界首創性的嘗試,由于各種原因不在本文中介紹。

High Availability的關鍵設計——去堆疊 高可用是基礎網絡永恒的使命,而這個目标看起來簡單直接,卻并不是那麼容易做到。5.1網絡架構的雙上聯去堆疊設計,為高可用的目标增加了強有力的支撐。堆疊為我們帶來了什麼,為什麼去堆疊?

為了支援業務的高可用,阿裡巴巴網絡架構曆來都是采用雙上行接入的方式,從Server的接入link到TOR的層面都實作了雙活備份,使得一條link的故障,或者一台TOR的故障對于業務系統的可用性影響降到最低,會出現高水位時性能的損失但是不會出現服務不可用。

傳統的雙活接入的方式,業界通用的方法都是通過兩台TOR交換機實作vpc/mlag/堆疊這類技術來實作,而這種雙活技術要求兩台交換機之間通過協定互動轉發表項資訊,甚至堆疊技術要求兩台TOR在管理和轉發層面都merge成為一台裝置,這在無形中增加了技術複雜度和出問題的機率。實際運作過程中也展現了這一點,兩台TOR由于堆疊系統的軟硬體bug原因導緻同時當機的情況屢見不鮮,對業務系統的穩定性形成了很大的挑戰。

去堆疊設計

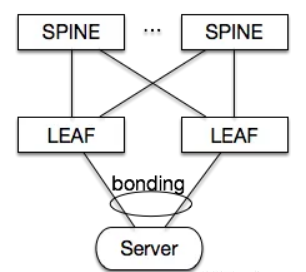

5.1網絡架構中,我們創新性的實作了伺服器雙活接入+TOR去堆疊(如下圖),在保證伺服器雙活接入的可用性前提下,解決了堆疊系統本身穩定性所帶來的問題。支撐2018年雙11的所有5.1網絡叢集和數以萬計的伺服器,都是運作在阿裡自主設計開發的去堆疊技術之上, 使得5.1架構在雙11的流量壓力和高可用要求下,更加從容應對。

網絡去堆疊設計的基本原則:在網絡裝置上通過feature實作,使所有業務通路均走三層轉發,利用三層轉發的路由傳遞能力覆寫所有failover場景,同時保持伺服器的bond接入生态,在主機側做最小的改動。

網絡側

· arp轉換為host路由。所有ASW上學習到的arp都轉換為/32主機路由(host-route);

· LACP sysID可設定。可以對兩台ASW進行LACP sysID設定以達到兩台ASW與下聯Server的兩條鍊路完成LACP協商;

· arp proxy。ASW使用自身mac位址代答所有主機或者虛拟主機的arp,使所有主機間的互訪在網絡裝置上進行三層轉發。

主機側

· 我們在伺服器上實作arp封包在bond slave端口TX方向上的broadcast。如下圖所示

這個子產品實作對arp封包在多個bond slave上的broadcast,可以協助兩台交換機來同步arp。

Low latency —— RDMA技術第一次大規模應用考驗業務系統有兩個非常關鍵的業務名額,即Throughput(吞吐量,機關時間内可以處理的請求數或執行的任務數)和Latency(時延,系統在處理一個請求或一個任務時的延遲)。當然不同的業務場景中,對于Throughput和Latency的訴求也會不盡相同,側重點也會有所不同。然而無論如何,Low Latency是永恒的追求,Latency越小,在同等系統資源條件下,就能獲得更大的Throughput。

5.1網絡架構在Low latency方面有兩個方面的設計實作。

1. scale out設計中,PSW裝置改為單晶片裝置,從轉發路徑上減小了PSW層面轉發的晶片數進而減小了轉發節點數,降低了一個pod内部互動的轉發時延。而以往架構采用框式裝置,一個PSW節點的轉發需要經過三跳。

2. HAIL 5.1網絡架構以POD為機關支援RDMA,給業務提供了目前業界最強的高性能低延時網絡技術方案。(當然,1.中對PSW的單晶片設計也大大簡化了RDMA部署的複雜度,這兩個設計相輔相成)

近幾年,當我們讨論Low latency時, RDMA是繞不開的話題。大家都在讨論IB、iWrap、RoCE的優劣和取舍的時候,實際上阿裡巴巴已經實作了業界最大規模的RDMA 部署,同時也經受了當今世界最嚴苛的技術考驗——天貓雙11.

目前運作在5.1RDMA平台上的業務包括集團DB、阿裡雲ESSD、阿裡雲PolarDB、大資料PAI、高性能計算等,2018年雙11更是RDMA大顯身手的舞台,100% 大促DB業務,和100% 大促ESSD存儲都運作在RDMA上,網絡為業務系統的極緻性能提供了最強的賽道!

5.1架構以POD為機關支援RDMA,使用了RoCEv2協定規範,以及DCQCN+Lossless網絡的流控方案,目前已經在集團的存儲、DB、高性能計算、機器學習等業務場景中大規模使用。

HAIL5.1網絡架構不僅僅實作了RDMA技術能力的落地,同時建立了RDMA業務支撐平台和RDMA營運生态,這是RDMA作為一個落地生産的技術架構非常重要的部分。

· 向上層業務,我們提供了RDMA-Service的平台化RDMA支撐子產品,友善業務快速部署和使用RDMA,同時子產品中內建了rdma關鍵參數的監控和校驗能力;

· RDMA自身的閉環運維能力。監控系統通過gRPC/erspan等通道從實體網絡擷取實時的RDMA運作狀态,包括pfc/cnp/nak/buffer-usage/queue-drop/mmu-err/link-flap/crc/…,通過這些資料我們可以實時監控RDMA網絡的運作狀态;自動化系統對監控資料進行分析,對監控事件進行響應,來實作快速的故障發現和定位,實作基于pfc拓撲的mmu異常點定位和隔離,基于nak/cnp來快速判斷網絡丢包。

接下來,阿裡巴巴資料中心網絡架構還将進行region級别的HAIL架構演進(架構代号HAIL2.0),實作更大範圍内的“高可用、智能化、低延遲”網絡,我們将在自研機、可視化和RDMA領域持續發力,上線由自主研發的DC交換機組成的資料中心新一代架構,運作自主研發的RDMA流控方案和定制協定的智能網卡,繼續引領新一代網絡可視化技術的發展和落地。阿裡巴巴資料中心網絡架構HAIL2.0,我們明年雙11見!

原文釋出時間為:2018-11-21

本文作者:網絡研發

本文來自雲栖社群合作夥伴“

AlibabaInfrastructure”,了解相關資訊可以關注“

”。