論文:Rethinking Spatial Dimensions of Vision Transformers

代碼:https://github.com/naver-ai/pit

擷取:在CV技術指南背景回複“0006”

點個關注,專注于計算機視覺的技術總結、最新技術跟蹤、經典論文解讀。

前言:

由于基于transformers的架構在計算機視覺模組化方面具有創新性,是以對有效架構的設計約定的研究還較少。從 CNN 的成功設計原則出發,我們研究了空間次元轉換的作用及其對基于transformers的架構的有效性。

我們特别關注CNNs的降維原理;随着深度的增加,傳統的 CNN 會增加通道次元并減少空間次元。我們憑經驗表明,這種空間降維也有利于transformers架構,并在原始 ViT 模型上提出了一種新型的基于池化的視覺transformers (Pooling-based Vision Transformer--PiT)。

我們表明 PiT 實作了針對 ViT 的改進模型能力和泛化性能。在廣泛的實驗中,我們進一步表明 PiT 在圖像分類、目标檢測和魯棒性評估等多項任務上優于baseline。

出發點

1. CNN 限制了空間互動,ViT 允許圖像中的所有位置通過transformers層互動。

2. 雖然ViT 是一種創新架構,并且已經證明了其強大的圖像識别能力,但它沿用了NLP中的 Transformer 架構,沒有任何變化。

3. CNN 的一些基本設計原則在過去十年中已被證明在計算機視覺領域有效,但并未得到充分反映。

是以,我們重新審視了 CNN 架構的設計原則,并研究了它們在應用于 ViT 架構時的功效。

創新思路

CNN 以大空間尺寸和小通道尺寸的特征開始,并逐漸增加通道尺寸,同時減小空間尺寸。由于稱為空間池化的層,這種次元轉換是必不可少的。現代 CNN 架構,包括 AlexNet、ResNet和 EfficientNet,都遵循這一設計原則。

池化層與每一層的感受野大小密切相關。 一些研究表明,池化層有助于網絡的表現力和泛化性能。 然而,與 CNN 不同的是,ViT 不使用池化層,而是在所有層中使用相同大小的空間。

首先,我們驗證了 CNN 上池化層的優勢。我們的實驗表明,池化層證明了 ResNet 的模型能力和泛化性能。為了将池化層的優勢擴充到 ViT,我們提出了一種基于池化的視覺transformers (PiT)。

PiT 是一種與池化層相結合的轉換器架構。它可以像在 ResNet 中一樣減少 ViT 結構中的空間大小。我們還研究了 PiT 與 ViT 相比的優勢,并确認池化層也提高了 ViT 的性能。

最後,為了分析 ViT 中池化層的效果,我們測量了 ViT 的空間互動比,類似于卷積架構的感受野大小。我們展示了池化層具有控制自注意力層中發生的空間互動大小的作用,這類似于卷積架構的感受野控制。

Methods

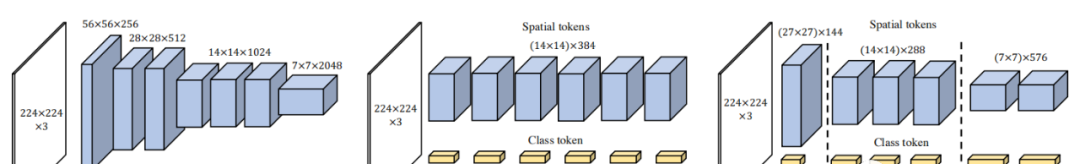

網絡架構次元配置的示意圖

我們将 ResNet50 、Vision Transformer (ViT) 和基于池化的 Vision Transformer (PiT) 可視化;(a) ResNet50 從輸入到輸出逐漸下采樣特征;(b) ViT 不使用池化層,是以所有層都保持特征次元;(c) PiT 涉及将層彙集到 ViT 中。

Pooling-based Vision Transformer(PiT)

PiT 架構的池化層

PiT 使用基于深度卷積的池化層,以小參數實作通道乘法和空間縮減。

Effects of the pooling layer in vision transformer (ViT)

我們在網絡架構的各個方面将我們的基于池化的視覺transformer (PiT) 與原始 ViT 進行了比較。PiT 在容量、泛化性能和模型性能方面優于 ViT。

Spatial interactio

self-attention層在互動token數量上也有限制,是以互動區域是根據空間大小來确定的。

我們使用 ImageNet 上的預訓練模型測量了 ViT 和 PiT 的空間互動區域。空間互動的标準是基于注意力矩陣的 soft-max 之後的分數。我們使用 1% 和 10% 作為門檻值,計算超過門檻值的互動發生的空間位置的數量,并通過将互動位置的數量除以空間标記的總大小來計算空間互動比率。

在 ViT 的情況下,互動作用平均在 20%-40% 之間,并且由于沒有池化層,是以數值不會因層而有顯着變化。PiT 減少了token的數量,同時通過池化增加了頭部。

是以,如圖 5 (a) 所示,早期層的互動率很小,但後一層顯示出接近 100% 的互動率。為了與 ResNet 進行比較,我們将門檻值更改為 10%,結果如圖 5 (b) 所示。

在 ResNet 的情況下,3x3 卷積意味着 3x3 空間互動。是以,我們将 3x3 除以空間大小,并将其作為近似值與注意力的互動率進行比較。雖然 ViT 的互動率在各層中是相似的,但 ResNet 和 PiT 的互動率随着它通過池化層而增加。

Architecture

該表顯示了 ViT 和 PiT 的spatial sizes, number of blocks, number of heads, channel size, 和FLOPs。PiT 的結構設計為盡可能與 ViT 相似,并具有更少的 GPU 延遲。

Conclusion

我們驗證了 PiT 在各種任務上提高了 ViT 的性能。在 ImageNet 分類中,PiT 和在各種規模和訓練環境下都優于 ViT。此外,我們還比較了 PiT 與各種卷積架構的性能,并指定了 Transformer 架構優于 CNN 的規模。

我們使用檢測頭進一步測量 PiT 在目标檢測方面的性能。 基于 ViT 和 PiT 的 DETR在 COCO 2017 資料集上進行訓練,結果表明 PiT 作為主幹架構甚至比 ViT 更适合圖像分類以外的任務。最後,我們通過穩健性基準驗證了 PiT 在各種環境中的性能。

本文來源于公衆号 CV技術指南 的論文分享系列。

歡迎關注公衆号 CV技術指南 ,專注于計算機視覺的技術總結、最新技術跟蹤、經典論文解讀。

在公衆号中回複關鍵字 “入門指南“可擷取計算機視覺入門所有必備資料。

其它文章

ML2021 | PatrickStar:通過基于塊的記憶體管理實作預訓練模型的并行訓練

ICCV2021 | PnP-DETR:用Transformer進行高效的視覺分析

ICCV2021 | 醫學影像等小資料集的非自然圖像領域能否用transformer?

ICCV2021 | Vision Transformer中相對位置編碼的反思與改進

ICCV2021 | TransFER:使用Transformer學習關系感覺的面部表情表征

2021-視訊監控中的多目标跟蹤綜述

統一視角了解目标檢測算法:最新進展分析與總結

全面了解目标檢測中的anchor | 姿态估計綜述

目标檢測中回歸損失函數總結 | 小目标檢測常用方法總結

視覺Transformer綜述 | 2021年小目标檢測最新研究綜述

Siamese network綜述 | 小目标檢測的一些問題,思路和方案

視訊了解綜述:動作識别、時序動作定位、視訊Embedding

從CVPR 2021的論文看計算機視覺的現狀

ICCV2021 | MicroNet:以極低的 FLOPs 改進圖像識别

ICCV2021 | 重新思考視覺transformers的空間次元

CVPR2021 | TransCenter: transformer用于多目标跟蹤算法

CVPR2021 | 開放世界的目标檢測

CVPR2021 | TimeSformer-視訊了解的時空注意模型

CVPR2021 | 一個高效的金字塔切分注意力子產品PSA

CVPR2021 | 特征金字塔的新方式YOLOF

經典論文系列 | 重新思考在ImageNet上的預訓練

經典論文系列 | Group Normalization & BN的缺陷

經典論文系列 | 目标檢測--CornerNet & anchor boxes的缺陷

經典論文系列 | 縮小Anchor-based和Anchor-free檢測之間差距的方法:自适應訓練樣本選擇

CV方向的高效閱讀英文文獻方法總結

CNN可視化技術總結(一)-特征圖可視化

CNN可視化技術總結(二)--卷積核可視化

CNN可視化技術總結(三)--類可視化

CNN可視化技術總結(四)--可視化工具與項目

池化技術總結 | NMS總結 | 注意力機制總結

特征金字塔總結 | 資料增強方法總結

計算機視覺專業術語總結(一)建構計算機視覺的知識體系

欠拟合與過拟合技術總結 | 損失函數技術總結

CNN可視化技術總結

CNN結構演變總結—經典模型

CNN結構演變總結—輕量化模型

CNN結構演變總結—設計原則

論文創新的常見思路總結

在公衆号《CV技術指南》中回複“技術總結”可擷取以上所有總結系列文章的彙總pdf