hadoop3.3.0叢集搭建記錄

hadoop3.3.0

hive3.1.2

spark3.0.0

主要安裝了上面這仨????

結果如下所示:

檢視java路徑:

為了友善直接用root使用者安裝

因為hadoop3.3.0已經下載下傳到<code>/Downloads</code>檔案夾中,是以先解壓重命名複制到目标路徑

事實證明dsa用了仍需要密碼,改用rsa後即可免密碼

出現權限不足的問題,下面嘗試另外的方法

解鎖賬戶仍然失敗

懷疑是ssh占用了(也不應該)我虛拟機不知道為什麼open-vm-tools安裝了卻不能複制粘貼剪切闆以及拖動檔案,是以用了xshell走ssh來實作複制粘貼代碼及檔案傳輸。結果證明和這個并沒有關系

後來發現是未配置root密碼所緻,配置好後解決ssh免密登入的問題

dfs.namenode.http-addressmaster.hadoop:9000

<code>hdfs namenode -format</code>

打開debug模式後檢視到下列輸出

驗證本地庫是否加載成功

顯然爛了,嘗試重新格式化namenode

結果沒發生過任何變化

啟動了jps完全是空的,檢視日志有這個錯誤

如果配置檔案沒問題的話,那就是hostname的問題。確定hostname跟配置檔案對應即可

修改主機名

解決,如果不行格式化一下namenode試試

但我想用scala3.0.0的,官網說有個coursier的啥工具能快速安裝,但是我安裝的時候一直報443錯誤,不能解決(如下

是以去github直接下載下傳tar包來安裝吧https://github.com/lampepfl/dotty/releases/tag/3.0.0

打算安裝spark3.0.0的版本,目錄裡面選擇帶hadoop3.2.0的(指的是3.2.0和之後的)https://archive.apache.org/dist/spark/spark-3.0.0/

<code>./start-all.sh</code>

可能原因:

路徑有空格

沒有導入java路徑

沒什麼變化

解決!

https://mirrors.bfsu.edu.cn/apache/hive/hive-3.1.2/

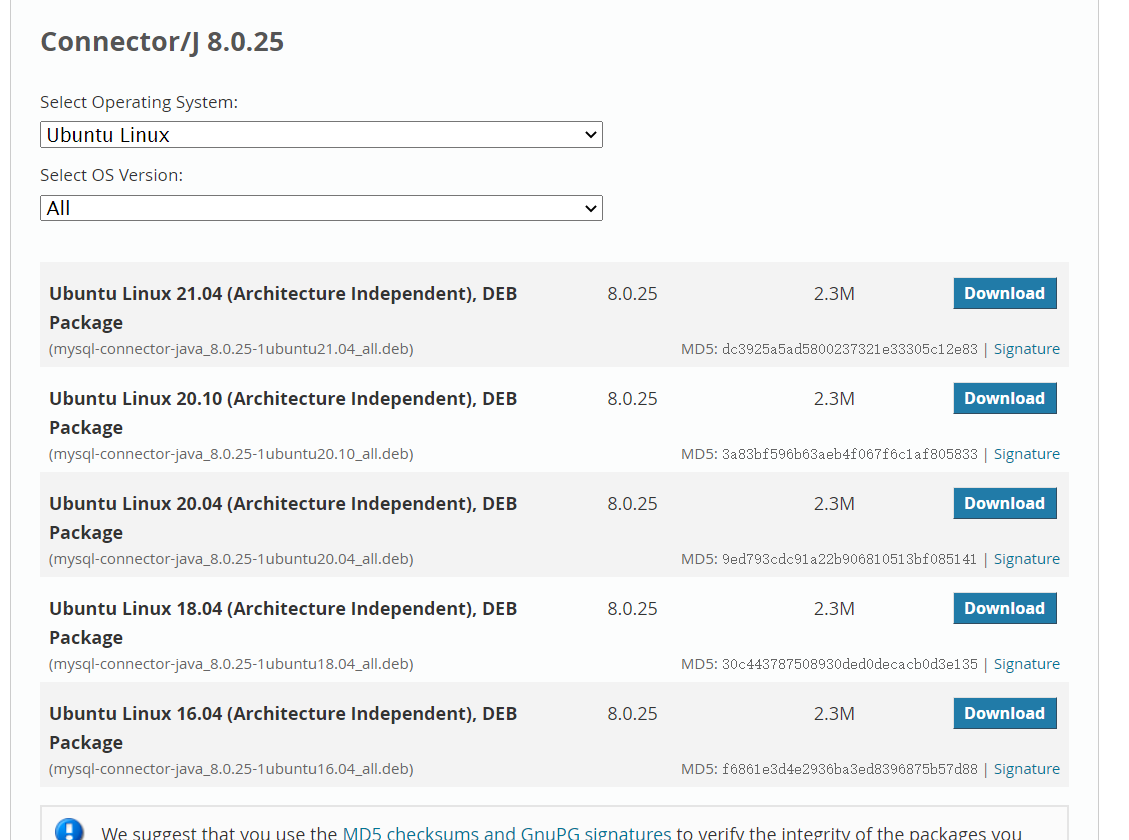

https://dev.mysql.com/downloads/connector/j/5.1.html

隻有deb的?直接安裝好像沒什麼用……而且安裝mysql已經把jar包複制過來了才對……

SLF4J沖突

删掉hive裡面的就好,保留hadoop裡面的

重新按照另一篇部落格安裝https://blog.csdn.net/w116858389/article/details/81254221

依舊報錯,看看怎麼解決吧

解決是解決了,但是中間忘記錄了……

=.=