本文來自AI新媒體量子位(QbitAI)

事情開始于一項斯坦福大學的新研究。

研究人員Yilun Wang與Michal Kosinski用監督學習算法創造出一種新模型,可以直接從面相判斷一個人的性取向,研究論文也即将發表在美國心理學學術月刊《Journal of Personality and Social Psychology》上。

納尼?!還能根據面相判斷性取向?确定我是在看科學期刊而不是誤入路邊看面相算命的小攤攤?

帶着衆多問号,我們翻看了實驗研究。

研究人員首先從交友網站的公開資訊中收集了14776人的35326張照片,想在照片中提取面部特征。從臉型、嘴型、鼻型、眉形到面部的毛發,這些特征全部被提取并量化。

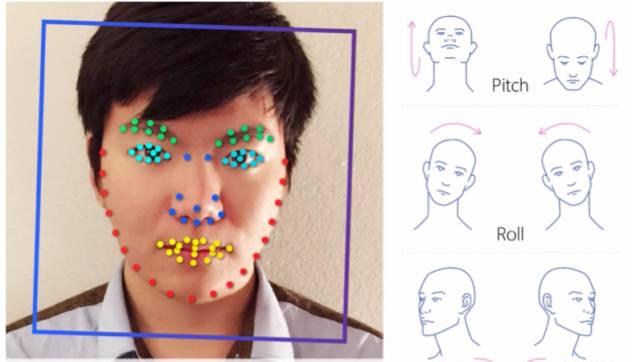

△ 研究人員先标記面部特征,同時用傾斜度、轉動和偏轉角度等參數定位人臉

之後,研究人員用深度神經網絡(DNN)從中提取與性取向有關的特征。在此,他們引入VGG-Face DNN模型,想通過面部表情、背景、光線、圖像屬性(亮度或對比度等)等因素來表示圖像中的人臉。

△ 系統識别的可以預測性取向的面部特征

随後,研究人員用預測模型、邏輯回歸等奇異值分解(SVD)等方法将圖像分類,判斷哪些圖像中的人為同志。

△ 這是由數千張圖檔組成的合成臉,展示了系統觀察到的面部特征細微差别。右圖中的綠色/紅色線條分别代表男女異性戀者/同志者面部器官的位置形狀

最後,研究人員随意挑選圖像,讓電腦猜測受試者的性取向,結果證明AI系統的表現明顯優于人類——

在沒有穿搭風格、人物動作等因素影響的情況下,就單一面部資訊而言,分類器識别男女性取向的準确率分别達到了81%和71%。

研究人員還設計對照組讓人類判斷照片中人的性取向。實驗證明,人類對男女性取向識别準确率分别為61%和54%。對比看來,算法的準确率明顯優于人類的直覺判斷。

如果通過5張以上照片讓系統識别人類性取向,則男女性取向準确率分别提高到91%和83%。

研究人員意外地發現,性取向與面部特征存在些許關聯,一般情況下,男同有“女性化”特征,女同有“男性化”特征。比如,男同的下颚、鼻子和前額比直男大,與異性戀女性相比,女同的下颚更大,額頭更小。

這篇論文的作者是Yilun Wang和Michal Kosinski。兩個人一起收集了資料并進行分析,論文為Michal Kosinski執筆完成。

量子位經過查詢發現,Yilun Wang現在的身份是IDG資本駐舊金山灣區的投資顧問,投資領域專注于AI、機器人、機器學習、計算機視覺等。此前,Yilun曾在Google、百度深度學習研究院、格靈深瞳、微軟等公司實習。

Yilun Wang大學畢業于浙江大學,2016年在斯坦福獲碩士學位。

而Michal Kosinski博士是斯坦福商學院的助理教授。2014年,Kosinski在劍橋大學獲得心理學博士學位。先後供職于微軟研究院、劍橋大學,并有過創業經曆。

Kosinski還是一位活躍在各種活動和采訪中的學者。

今年初的CeBIT’17大會上,Kosinski發表了一場題為《The End of Privacy》(隐私的終結)的演講。(當然他在别的場合也經常講這個)

其實Kosinski的這個演講,跟上面的主題一脈相承。

在《隐私的終結》裡,Kosinski指出人們已經在網上留下太多的數字足迹,隻需要通過一個強大的算法,把所有這些零散的足迹手機起來,就能描繪出你的真實樣貌。

我們本來制作了一個壓好字幕的視訊,不過兩次騰訊都沒稽核通過。是以,直接放一個YouTube位址吧:

https://youtu.be/DYhAM34Hhzc

對于這項研究,部分美國媒體“表示強烈譴責和極大的憤慨”,比如TechCrunch。

他們在标題上指責這項研究“顯示了資料時代的黑暗面”,還說這項研究“除了将一個已經很脆弱的人群暴露在新型的系統化虐待之下,還直接打擊了我們的平等觀念:不能以貌取人、也不能通過一兩張照片這麼簡單的東西來判斷性取向這樣的隐私。”

英國的《經濟學人》情緒穩定,不過《衛報》腦補了一些應用場景,比如懷疑自己形婚了,用這個AI gaydar來測一測自己的另一半,或者青少年用它來測自己、測同學……

《衛報》還”采訪了多倫多大學心理學副教授Nick Rule,這位學者曾經研究過gaydar背後的科學,而對于斯坦福的這項研究,他認為非常“令人不安”,擔心可能有人出于惡意來“根據人們的外表來分析他們、識别他們”。

reddit上網友的反應就淡定得多,量子位摘錄一些網友評論如下:

“是以,他們造了一個Gaydar?”

“Stereotype的存在看來是有原因的”

“好吧……我覺得我還挺擅長通過長相判斷誰是同志。但如果我說“Joe看起來90%是gay”,是不是不道德?”

“可怕。”

“第一個資料集來自‘一家美國交友網站’。我感覺這說的是OKCupid。”

“我真不明白這有什麼可怕的。這個研究可以非常有用,而且不違背道德。”

“我覺得這進一步增強了我們對于性别的認知,我之前不知道面孔中還包含了這麼多和性取向有關的資訊。”

“很多判斷都是基于穿着打扮。如論文中的例子,面部毛發較少常被歸為男同(訓練資料沒包括熊?)戴着棒球帽的常被歸為女同。”

“放在交友網站上的照片,可能會包括與性取向有關的隐藏資訊。”

“我沒看得太仔細,有點疑惑是為什麼用預建構和預訓練的神經網絡,而不是自己訓練?他們的确自己訓練了,而且表現更好,但他們擔心過拟合。我不知道為什麼。”

“DNN能夠進行純粹的面部特征分離,不受面部表情、背景、光照、頭部方向、圖像屬性(亮度、對比度)等因素的影響。這能消除圖檔噪聲帶來的過拟合風險。”

你怎麼看這件事?歡迎在下方留言給我們~

在量子位微信公衆号(ID:QbitAI)背景的對話界面回複“gaydar”,即可收到這份有趣的論文。

— 完 —

本文作者:安妮 李林

原文釋出時間:2017-09-08