Active Object Localization with Deep Reinforcement Learning

ICCV 2015

最近Deep Reinforcement Learning算是火了一把,在Google Deep Mind的首頁上,更是許多關于此的paper,基本都發在ICML,AAAI,IJCAI等各種人工智能,機器學習的牛會頂刊,甚至是Nature,可以參考其官方publication page: https://www.deepmind.com/publications.html

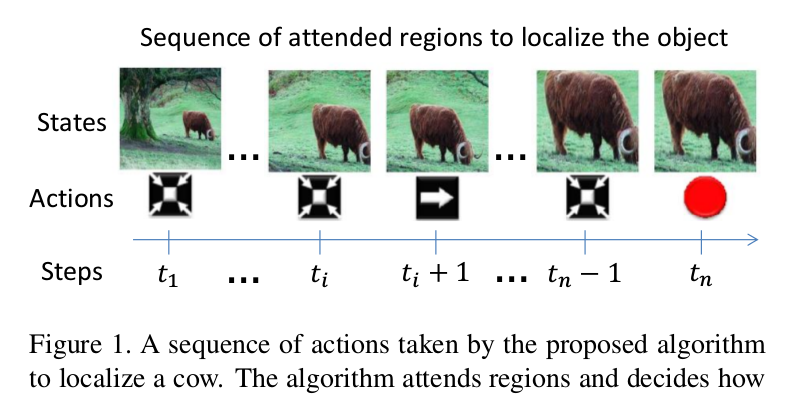

本文是做特定物體的定位和檢測,但是不用提取proposal的方式。本文的方法采用從上至下的搜尋政策,剛開始的時候,是分析整個場景,然後向物體準确的位置行進。其實,就是先用一個較大的box将物體框住,然後一步一步的縮小,最終使得物體完美的被一個緊湊的box圍住。重點是這個step by step的定位過程,該過程是由一個機制确定,并且分析目前可見區域的内容,然後選擇下一步最優的action,每一步transformation都盡可能将背景部分砍掉,并且要将物體完整的留在box之中,示例的調整過程如下圖所示:

本文所用的方法是 dynamic attention-action strategy,需要注意目前區域的内容,使得轉移box的導向是:the target object is progressively more focused. 為了模拟所提出機制的attention,目前box覆寫目标物體的好壞決定了獎勵函數(reward function)。基于DeepQNetwork algorithm,作者将獎勵函數和增強學習(reinforcement learning setting)結合來學習一個定位政策(localization policy)。作者的結果表明,一個訓練的agent可以在11步左右定位到一個物體的示例,這意味着該算法可以在處理11個區域之後準确的找到一個物體。

Object Localization as a Dynamic Decision Process

本文将物體定位問題看做為馬爾科夫決策過程(Markov decision process (MDP)),因為這套設定提供了一個正式的架構來模組化一個agent,能夠做出一系列的決策。該機制擁有目前可見區域的狀态描述(state representation with information of the currently visible region) 和 過去的動作(past actions),在訓練的過程中,會對每一個決定都會給出positive or negative rewards。在測試的過程中,該機制不在收到回報,不再更新model,隻是遵循學習到的政策。是以,MDP由三個部分構成,即:a set of actions A, a set of states S, and a reward function R.

1. Localization Actions

可以看到 action set A 有8個轉移動作(四個方向的移動,尺寸的放大和縮小,長寬比例的變換)和1個終止動作(Trigger)。box的位置:b = [x1, y1, x2, y2], 任何一個轉移動作(transformation actions)都會對box造成一個discrete change,通過:

2. State

The state representation is a tuple (o, h), 其中 o 是觀測區域的特征向量,h 是一個向量,存儲的是所采用action的曆史記錄。特征向量 o 是用CNN網絡結構提取的,将輸入改為224*224,将fc6層的feature提出來。在曆史記錄向量中,每一個action都表示為一個9維的二進制向量,除了存在的那個動作為1,其餘的都為0. 文中将該記錄編碼為10個 past actions,那麼h就是一個 90維的向量。

3. Reward Function

獎勵函數 R 和標明一個特定區域後該機制定位物體的提升程度成正比。預測box和給定box的重疊程度作為我們setup的改善的衡量标準。More specifically,獎勵函數用從一個狀态到另一個狀态的IoU的不同來預測。假設觀測區域的box 為b,目标物體的gt box為 g。b和g之間的IoU定義為:

IoU(b, g) = area(b^g) / area(bvg).

當agent標明action a 從 s 移動到 s'時,執行獎勵函數 Ra(s, s'). 每一個狀态 s 有一個相關的box b包含傾向的區域,then the reward is as follows:

Ra(s, s') = sign ( IoU(b', g) - IoU(b, g) )

可以看到,從狀态s到s',如果IoU改善了,那麼獎勵就是positive的,否則就是negative的。獎勵機制是二值 r 屬于{-1, +1}, 适合用所有轉移box的action。通過這種方式,agent對于那些移走box的操作給予懲罰,對于那些符合要求的action給予獎勵,直到沒有其餘的轉移可以更好的改善定位,在這種情況下,就要進行trigger操作了。

Trigger擁有一個不同的獎勵機制,因為這個操作會帶來終止狀态,該action的IoU差别會永遠為0。IoU的門檻值函數作為trigger的獎勵:

最終,the reward scheme顯示的考慮了step的個數作為一個cost,the agent follow a greedy strategy,which prefers short sequences because any unnecessary step pays a penalty that reduces the accumulated utility.

Finding a Localization Policy with Reinforcement Learning

Agent的設計是為了一系列的選擇actions來轉移bbox,使得在與環境互動的過程中,得到的rewards最大。核心問題是找到一個政策指導agent的決策制定的過程。一個政策就是一個函數pi(s)來指定選擇action a,當current state is s。由于我們沒有狀态轉移機率,且獎勵函數是依賴于資料的,該問題就構成了利用Q-Learning的增強學習問題。

本文follow了Mnih et al.的deep Q-learning algorithm,該算法利用神經網絡預測 action-value function,與之前的Q-learning方法對比,有如下幾點優勢:

(1). Q-network的輸出有許多單元(units),像該問題的多個actions一樣。

(2). 該算法結合一個 replay-memory來收集不同的經驗和在長期運作中進行學習。

(3). 為了更新model,該算法從replay-memory uniformly at random的選擇transitions,來破壞狀态之間的短期關系。這使得算法更加穩定并且阻止了參數的不收斂。

在學習了 action-value function Q(s, a)之後,agent采用的政策就是選擇擁有最大預測值的 action a。

1. Q-learning for Object Localization

網絡結構如上圖所示,輸入圖像是:224*224,經過5個卷基層,提取fc6層的feature,然後訓練 Deep Q-Network,最終輸出9個actions, 這9個action 就是 對應 fc 的9個輸出。

2. Training Localization Agents

另外,為了更好的了解Deep Q-Network,還是抽空看一下這篇文章" Human-level control through deep reinforcement learning"。

The link is here: http://gnusha.org/~nmz787/pdf/Human-level_control_through_deep_reinforcement_learning.pdf

大家有什麼疑惑,歡迎一起讨論學習!