Attention For Fine-Grained Categorization

Google ICLR 2015

本文說是将Ba et al. 的基于RNN 的attention model 拓展為受限更少,或者說是非受限的視覺場景。這個工作和前者很大程度上的不同在于,用一個更加有效的視覺網絡,并且在attention RNN之外進行視覺網絡的預訓練。

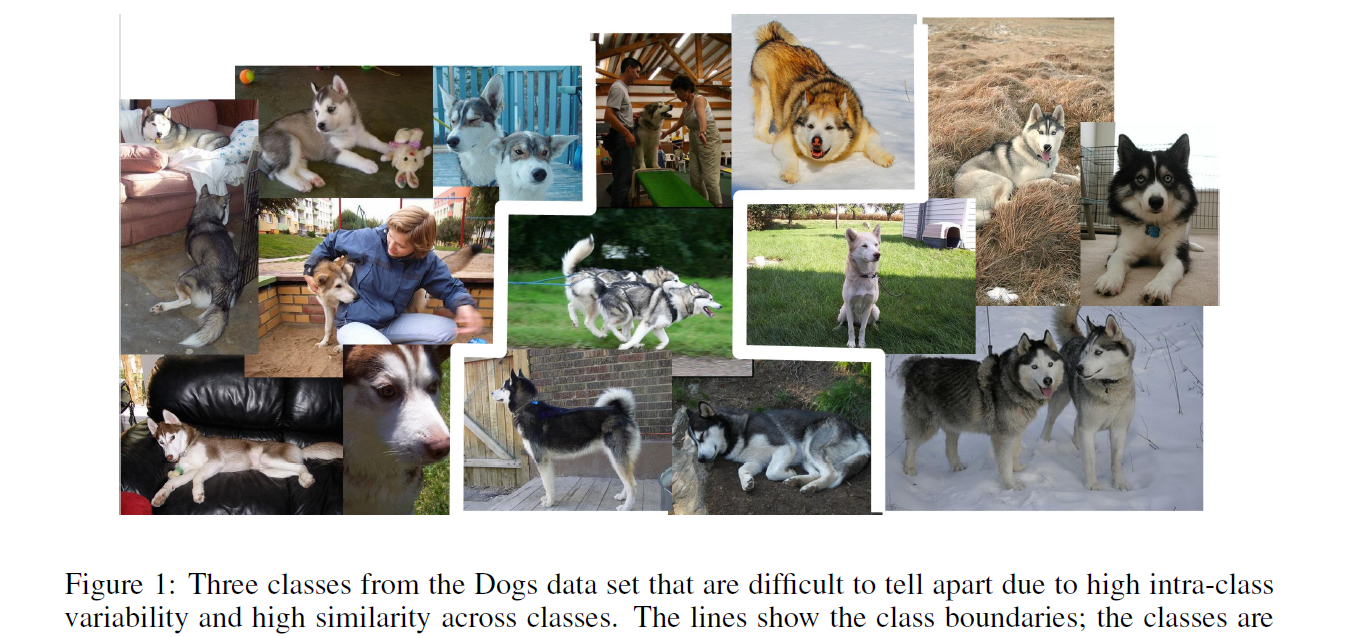

前人的工作在學習 visual attention model 時已經解決了一些計算機視覺問題,并且表明加上不同的attention mechanisms 可以有效的提升算法的性能。但是之前的工作基本都是受限的環境或者基于玩具這種資料集,本文的算法可以處理更加具有挑戰性的因素,如:遮擋等更加複雜的場景。下面這個資料集就給出了案例:

本文模型架構主要來源于“ Multiple Object Recognition with Visual Attention ”,大體上是一直的,主要有一下幾點不同:

1. our model chooses actions for N glimpses and then classifies only after the final glimpse, as opposed to the sequence task in Ba et al. 每一個實驗當中 glimpse的個數是固定的。

2. 因為資料集中的圖像是不斷變化的,那麼“foveal” glimpses patches 的大小和輸入圖像最短邊的比例保持一緻。

3. 用“vanilla” RNN 來代替 LSTM,在 glimpse n 處,$r_n^{(1)}$ and $r_n^{(2)}$ 都由4096個點構成,當$i =1, 2$時,$r_n(i)$ 和 $r_{n+1}(i)$ 是全連接配接的。

4. 本文并非将 glimpse visual core $G_{image}(x_n|W_{image})$ and $G_{loc}(l_n|W_{loc})$的輸出進行元素級相乘,而是将其輸出進行concatenate實作線性組合,然後使其通過一個全連接配接層。

最後,然後是最大的不同之處在于:将visual glimpse network $G_{image}(x_n|W_{image})$ 替換為 基于"GoogleLeNet" model的更加強大且有效的視覺核心(visual core)。

由于是基于他人的架構,是以本文對模型方面的介紹較少,我待會回去解釋下那個引用的文章,結合那篇文章,來了解這個paper。

留下空白頁,談談自己的感受:

我先去看看那個文章,回頭再補回來!等我!!!