雲栖号資訊:【 點選檢視更多行業資訊】

在這裡您可以找到不同行業的第一手的上雲資訊,還在等什麼,快來!

RL 算法通常假設,在擷取觀測值、計算動作并執行期間環境狀态不發生變化。這一假設在仿真環境中很容易實作,然而在真實機器人控制當中并不成立,很可能導緻控制政策運作緩慢甚至失效。為緩解以上問題,最近谷歌大腦與 UC 伯克利、X 實驗室共同提出一種并發 RL 算法,使機器人能夠像人一樣「邊做邊思考」。目前,該論文已被 ICLR 2020 接收。

該研究在如下情況中研究強化學習:在受控系統随着時間演變的過程中同時對動作進行采樣。換句話說,所研究的機器人必須在執行着上一個動作的同時考慮下一個動作。就如同人或動物一樣,機器人必須同時思考及行動,在上一個動作完成之前決定下一個動作。

為了開發用于此類并發性控制問題的算法架構,研究者從連續時間的貝爾曼方程開始,随後以考慮系統延遲的方式進行離散化。通過對現有基于價值(value-based)的深度強化學習算法進行簡單的架構擴充,該團隊提出了一類新型近似動态規劃方法,并在模拟基準任務和大規模機器人抓取任務上進行了評估(機器人必須「邊走邊思考」)。

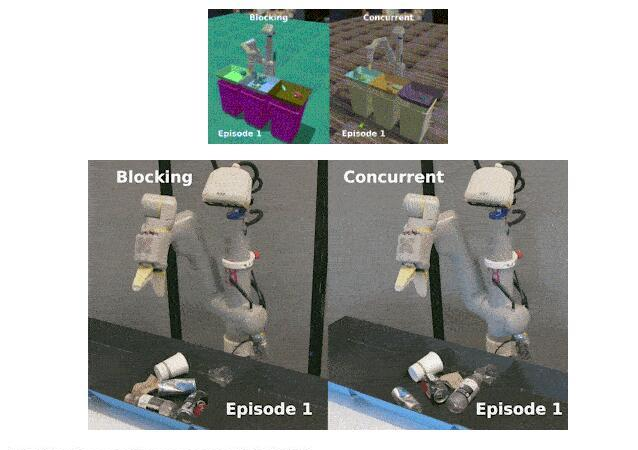

以下分别為該方法在仿真與真實機器人上的運作效果:

論文位址:

https://arxiv.org/abs/2004.06089項目網頁:

https://sites.google.com/view/thinkingwhilemoving并發動作環境

下圖(a)表示在阻塞環境(blocking environment)中,動作以順序阻塞的方式執行,假設在擷取狀态與執行動作之間環境狀态不發生變化。我們也可以将其了解為:從智能體的角度看來,擷取狀态與推斷政策是瞬間完成的。與此相反,圖(b)中表示的并發環境(concurrent environment)在擷取狀态與推斷政策之間并沒有假設環境不變,而是允許環境在此期間發生變化。

阻塞環境與并發環境中不同階段的執行順序對比圖。

基于價值的連續與離散并發強化學習算法

研究者從連續時間強化學習的角度開始探索,因為它可以輕松地表示系統的并發特性。之後研究者證明,基于連續情況得出的結論同樣适用于随後在所有實驗中使用的更為常用的離散環境。

連續環境方程

為了進一步分析并發環境,研究者引入下列符号。智能體在一個周期内選擇 N 個動作軌迹(a_1 , ..., a_N),其中每個 a_i(t) 為一個用于産生控制,并以時間 t 作為變量的連續函數。令 t_{AS} 為擷取狀态、推斷政策與任意額外通信時延的間隔時間。在 t 時刻,智能體開始計算狀态 s(t) 的第 i 個動作 a_i(t)。同時,在時間間隔 (t − H + t_{AS},t+t_{AS}) 内執行之前選取的動作 a_{i−1}(t)。在 t+t_{AS} 時刻(t ≤ t+t_{AS} ≤ t+H),智能體切換到去執行來自 a_i(t) 的動作。并發環境下的連續 Q 函數可表示如下:

前兩項分别對應執行 (t,t + t_{AS}) 時刻的動作 a_{i−1}(t) 和 (t + t_{AS},t + t_{AS} + H) 時刻動作 a_i(t) 的期望折扣回報。通過對随機方程 p 進行采樣,可獲得一個僅關于政策 rollouts 的單樣本(single-sample)蒙特卡洛估計器 Q:

接下來,對于連續時間情形,研究者定義了一個新的并發貝爾曼 backup 算子:

以上算子将貝爾曼算子擴充為考慮并發動作的情形,研究者證明改進後的算子保持了其吸引域的特性,這對于 Q-learning 的收斂性至關重要。

離散環境方程

為了簡化離散情形下的符号(此時動作方程 a_i(t) 與該方程在 t 時刻的值 a_i(t) 并非必需),研究者将目前狀态設定為 s_t,将目前動作設定為 a_t,将上一時刻動作設定為 a_{t−1}(分别将其下标 i 替換為 t)。在以上符号記法下,研究者定義了離散情形下的并發 Q 方程:

其中 t_{AS′} 為動作 a_t 在 t + t_{AS} 時刻開始執行時的「溢出間隔」(spillover duration)。于是,并發貝爾曼算子(以下标 c 表示)為:

與連續情形類似,研究者也證明了該離散貝爾曼算子是一個吸引域。

實驗結果

簡單一階控制問題

首先,研究者通過對标準的 Cartpole 和 Pendulum 環境的并發版本進行控制變量研究,說明了并發控制範式對基于價值的 DRL 方法的影響。

為了估計不同并發知識表示的相對重要性,研究者分析了每種并發知識表示對其他超參數值組合的敏感性,如下圖所示:

Cartpole 和 Pendulum 環境中的實驗結果。

大規模機械臂抓取任務

接下來,研究者分别在仿真與真實機械臂上進行了實驗。

圖 3:仿真和真實環境下的機械臂抓取任務圖示。

表 1 通過對無條件模型與并發知識模型進行比較總結了阻塞和并發模式的性能。并發知識模型能夠學習更快的軌迹,其周期持續時間與阻塞無條件模型相比減少了 31.3%。

表 1:大規模仿真機械臂抓取任務的實驗結果。

此外,研究者在現實世界機器人抓取任務中,對比了并發模型和阻塞模型的定性政策行為,如圖 3b 所示。

如表 2 所示,這些模型在抓取成功方面性能相當,但是就政策持續時間而言,并發模型比阻塞模型快 49%(政策持續時間用來衡量政策的總執行時間,但不包括在周期持續時間中的基礎架建構立和拆除時間,并發操作無法對此優化)。

表 2:真實機械臂抓取結果。

【雲栖号線上課堂】每天都有産品技術專家分享!

課程位址:

https://yqh.aliyun.com/live立即加入社群,與專家面對面,及時了解課程最新動态!

【雲栖号線上課堂 社群】

https://c.tb.cn/F3.Z8gvnK

原文釋出時間:2020-05-12

本文作者:機器之心編譯

本文來自:“

51cto”,了解相關資訊可以關注“

”